python实现拉普拉斯特征图降维示例

这种方法假设样本点在光滑的流形上,这一方法的计算数据的低维表达,局部近邻信息被最优的保存。以这种方式,可以得到一个能反映流形的几何结构的解。

步骤一:构建一个图G=(V,E),其中V={vi,i=1,2,3…n}是顶点的集合,E={eij}是连接顶点的vi和vj边,图的每一个节点vi与样本集X中的一个点xi相关。如果xi,xj相距较近,我们就连接vi,vj。也就是说在各自节点插入一个边eij,如果Xj在xi的k领域中,k是定义参数。

步骤二:每个边都与一个权值Wij相对应,没有连接点之间的权值为0,连接点之间的权值:

步骤三:令 ,实现广义本征分解:

,实现广义本征分解:

使 是最小的m+1个本征值。忽略与

是最小的m+1个本征值。忽略与  =0相关的本征向量,选取另外m个本征向量即为降维后的向量。

=0相关的本征向量,选取另外m个本征向量即为降维后的向量。

1、python实现拉普拉斯降维

def laplaEigen(dataMat,k,t):

m,n=shape(dataMat)

W=mat(zeros([m,m]))

D=mat(zeros([m,m]))

for i in range(m):

k_index=knn(dataMat[i,:],dataMat,k)

for j in range(k):

sqDiffVector = dataMat[i,:]-dataMat[k_index[j],:]

sqDiffVector=array(sqDiffVector)**2

sqDistances = sqDiffVector.sum()

W[i,k_index[j]]=math.exp(-sqDistances/t)

D[i,i]+=W[i,k_index[j]]

L=D-W

Dinv=np.linalg.inv(D)

X=np.dot(D.I,L)

lamda,f=np.linalg.eig(X)

return lamda,f

def knn(inX, dataSet, k):

dataSetSize = dataSet.shape[0]

diffMat = tile(inX, (dataSetSize,1)) - dataSet

sqDiffMat = array(diffMat)**2

sqDistances = sqDiffMat.sum(axis=1)

distances = sqDistances**0.5

sortedDistIndicies = distances.argsort()

return sortedDistIndicies[0:k]

dataMat, color = make_swiss_roll(n_samples=2000)

lamda,f=laplaEigen(dataMat,11,5.0)

fm,fn =shape(f)

print 'fm,fn:',fm,fn

lamdaIndicies = argsort(lamda)

first=0

second=0

print lamdaIndicies[0], lamdaIndicies[1]

for i in range(fm):

if lamda[lamdaIndicies[i]].real>1e-5:

print lamda[lamdaIndicies[i]]

first=lamdaIndicies[i]

second=lamdaIndicies[i+1]

break

print first, second

redEigVects = f[:,lamdaIndicies]

fig=plt.figure('origin')

ax1 = fig.add_subplot(111, projection='3d')

ax1.scatter(dataMat[:, 0], dataMat[:, 1], dataMat[:, 2], c=color,cmap=plt.cm.Spectral)

fig=plt.figure('lowdata')

ax2 = fig.add_subplot(111)

ax2.scatter(f[:,first], f[:,second], c=color, cmap=plt.cm.Spectral)

plt.show()

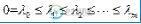

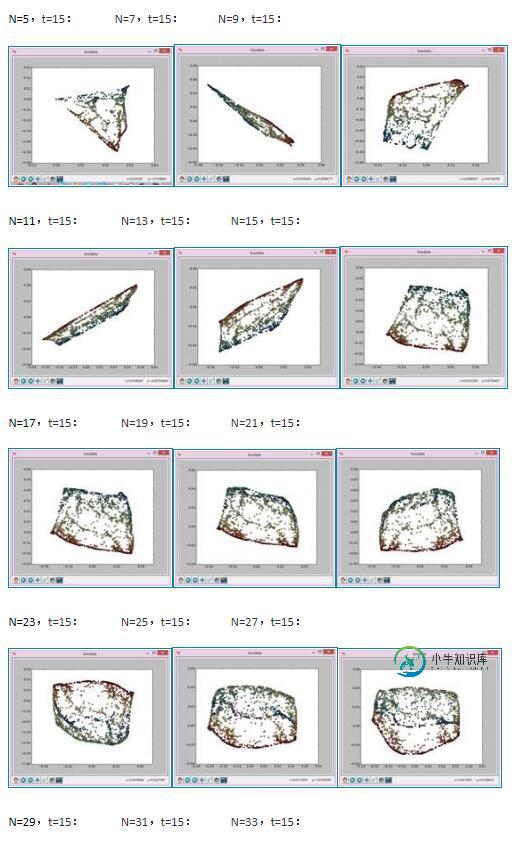

2、拉普拉斯降维实验

用如下参数生成实验数据存在swissdata.dat里面:

def make_swiss_roll(n_samples=100, noise=0.0, random_state=None): #Generate a swiss roll dataset. t = 1.5 * np.pi * (1 + 2 * random.rand(1, n_samples)) x = t * np.cos(t) y = 83 * random.rand(1, n_samples) z = t * np.sin(t) X = np.concatenate((x, y, z)) X += noise * random.randn(3, n_samples) X = X.T t = np.squeeze(t) return X, t

实验结果如下:

以上这篇python实现拉普拉斯特征图降维示例就是小编分享给大家的全部内容了,希望能给大家一个参考,也希望大家多多支持小牛知识库。

-

我在Travis上构建Symfony 3.2项目时遇到了一些问题。下载所有依赖项后,它会给我以下错误消息: Sensio\Bundle\DistributionBundle\Composer\ScriptHandler::clearCache无法打开输入文件:应用程序/控制台脚本Sensio\Bundle\DistributionBundle\Composer\ScriptHandler::cle

-

拉普拉斯(Laplacian)操作也是一个派生的操作,用来找出图像中的边缘。 这是一个二阶导数掩模。 在这个隐藏中,我们有两个进一步的分类,一个是正拉普拉斯操作,另一个是负拉普拉斯操作。 与其他算子不同,拉普拉斯并没有在任何特定方向上取出边缘,而是在后续分类中取出边缘。 向内边缘 向外边缘 可以使用类的方法对图像执行拉普拉斯变换操作,以下是此方法的语法。 该方法接受以下参数 - src - 表示源

-

#24届软开秋招面试经验大赏# 认准拉普拉斯,秋招必上岸 就业zixun可私。 字节二面安排在了滴滴车轮战之后。滴滴面完三轮之后我都累麻了。一小时之后又面字节,直接榨干。因此我愿意给这次面试打上五星难度。 由于过于劳累,面的啥已经忘了,大概回忆一下。 面了一小时,难度五颗星。 1 自我介绍 2 实习介绍 项目介绍 科研介绍 3 多余建模的范式 4 数据怎么组织的 5 冷启动问题咋解决 6 数据增强

-

#24届软开秋招面试经验大赏# 认准拉普拉斯,秋招必上岸 就业zixun可私。 面的是提前批,面试官看起来挺凶,其实还可以。 不过这一面其实问了我很多刁钻的问题,不过都没有抓着不放,回答一下就放过我了。感恩。 不知道字节商业化卷不卷。 面了一小时,难度4.5颗星。 1 自我介绍 2 实习介绍 项目介绍 科研介绍 3 介绍延迟转换问题,怎么解决 4 介绍怎么做的反事实 5 让我给我的论文里的结论做个

-

#24届软开秋招面试经验大赏# 认准拉普拉斯,秋招必上岸 就业zixun可私。 真没想到,秋招第一个offer竟然是字节的。面的是提前批,但是面完的时候已经到了八月末了,发的是正式批的offer。 hr小姐姐怪温柔的。 1 自我介绍 2 介绍过往经历 3 问我对几家公司的评价和对比 4 做owner的经历 5 和前面面试官的聊天经历 6 怎么平衡学习和实习 7 聊做过的学生工作 8 聊未来工作的选

-

#24届软开秋招面试经验大赏# 认准拉普拉斯,秋招必上岸 就业zixun可私。 京东整体面试难度中规中矩,不过面试体验确实好。 基本每轮面试官上来都先自我介绍,hr面甚至介绍了十分钟。一面面试官也很让人舒服。 东哥还是拿咱们当兄弟啊 一面一小时,难度3.5颗星。 1 自我介绍 2 项目介绍 科研介绍 实习介绍 3 问我的科研,什么是SSB问题 4 什么是PSC问题(论文里提出的问题) 5 具体是怎