pandas处理csv文件的方法步骤

一、我的需求

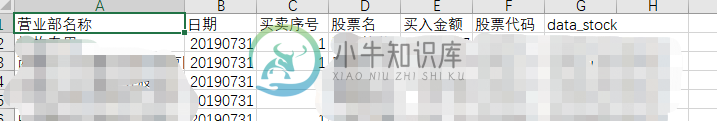

对于这样的一个 csv 表,需要将其

(1)将营业部名称和日期和股票代码进行拼接

(2)对于除了买入金额不同的的数据需要将它们的买入金额相加,每个买入金额乘以买卖序号的符号表示该营业名称对应的买入金额

比如:xx公司,20190731,1,股票1,4000,C20201010,xxxx

我这里想要的结果是:xx公司2019713C20201010,4000

二、代码

(1)首先由于文件是 gbk,所以读取是需要注意 encoding

(2)日期是int类型,所以需要转化为 字符串

import pandas as pd

import numpy as np

#读取数据

filename = "test.csv"

# 读取 excel 表,根据文件的编码指定编码方式

data = pd.read_csv(filename, encoding='gbk')

# 将所有内容转为字符串

# data = data.applymap(str)

# 将日期这一列转为字符串

data['日期'] = data['日期'].apply(str)

# print(data.loc[0,'营业部名称'])

# print(data.loc[0,'日期'])

# print(data.loc[0,'股票代码'])

# print(data.loc[0,'买卖序号'])

# print(data.loc[0,'买入金额'])

# 拼接:营业部名称+日期+股票代码

data['name_date_code'] = data['营业部名称'] + data['日期'] + data['股票代码']

# 取"买卖序号"的符号和买入金额相乘

# np.sign 获取序号对应的符号

data['buy'] = np.sign(data['买卖序号']) * data['买入金额']

data = data.drop(['营业部名称', '日期', '买卖序号', '股票名', '买入金额', '股票代码', 'data_stock'], axis=1)

# 将 name_date_code 相同的行,金额相加

buy_sum = data.groupby('name_date_code')['buy'].sum()

# 将相加的金额加入数据data,缺失数据用0填充

data['buy_sum'] = data.loc[:, 'name_date_code'].map(buy_sum).fillna(0)

# 将买入金额删掉,只剩下两列数据

data = data.drop(['buy'], axis=1)

# 删除重复行

data = data.drop_duplicates()

# 写入数据,同样需要注意指定编码格式

data.to_csv("YYBD_result.csv", encoding='gbk',index=False)

三、总结

(1)编码格式,正常是 utf-8 的不用指定,用默认的即可

(2)pandas 读取一行数据

# data.iloc 取一整行 print(data.iloc[0])

(3)pandas 处理数据确实很厉害,字符串拼接,类型转换,删除重复行,真方便

到此这篇关于pandas处理csv文件的方法步骤的文章就介绍到这了,更多相关pandas处理csv文件内容请搜索小牛知识库以前的文章或继续浏览下面的相关文章希望大家以后多多支持小牛知识库!

-

本文向大家介绍python使用pandas处理excel文件转为csv文件的方法示例,包括了python使用pandas处理excel文件转为csv文件的方法示例的使用技巧和注意事项,需要的朋友参考一下 由于客户提供的是excel文件,在使用时期望使用csv文件格式,且对某些字段内容需要做一些处理,如从某个字段中固定的几位抽取出来,独立作为一个字段等,下面记录下使用acaconda处理的过程; (

-

本文向大家介绍Python使用Pandas对csv文件进行数据处理的方法,包括了Python使用Pandas对csv文件进行数据处理的方法的使用技巧和注意事项,需要的朋友参考一下 今天接到一个新的任务,要对一个140多M的csv文件进行数据处理,总共有170多万行,尝试了导入本地的MySQL数据库进行查询,结果用Navicat导入直接卡死....估计是XAMPP套装里面全默认配置的MySQL性能不

-

问题内容: 这是我的问题。 与一堆.csv文件(或其他文件)。熊猫是读取它们并保存为格式的简便方法。但是当文件数量巨大时,我想通过多处理读取文件以节省一些时间。 我的早期尝试 我手动将文件分成不同的路径。分别使用: 然后合并它们。 如何运行它们以解决我的问题? 任何意见,将不胜感激! 问题答案: 使用:

-

对理解这一差异的任何帮助都是感激的。

-

主要内容:read_csv(),to_csv()在《 Python Pandas读取文件》中,我们讲解了多种用 Pandas 读写文件的方法。本节我们讲解如何应用这些方法 。 我们知道,文件的读写操作属于计算机的 IO 操作,Pandas IO 操作提供了一些读取器函数,比如 pd.read_csv()、pd.read_json 等,它们都返回一个 Pandas 对象。 在 Pandas 中用于读取文本的函数有两个,分别是: read_csv(

-

介绍 逗号分隔值(Comma-Separated Values,CSV,有时也称为字符分隔值,因为分隔字符也可以不是逗号),其文件以纯文本形式存储表格数据(数字和文本)。 Hutool针对此格式,参考FastCSV项目做了对CSV文件读写的实现(Hutool实现完全独立,不依赖第三方) CsvUtil是CSV工具类,主要封装了两个方法: getReader 用于对CSV文件读取 getWriter