Python使用Pandas对csv文件进行数据处理的方法

今天接到一个新的任务,要对一个140多M的csv文件进行数据处理,总共有170多万行,尝试了导入本地的MySQL数据库进行查询,结果用Navicat导入直接卡死....估计是XAMPP套装里面全默认配置的MySQL性能不给力,又尝试用R搞一下吧结果发现光加载csv文件就要3分钟左右的时间,相当不给力啊,翻了翻万能的知乎发现了Python下的一个神器包:Pandas(熊猫们?),加载这个140多M的csv文件两秒钟就搞定,后面的html" target="_blank">分类汇总等操作也都是秒开,太牛逼了!记录一下这次数据处理的过程:

使用Python3.6.4环境(对中文支持比较好),安装Pandas包

pip install pandas

基本使用:

import pandas as pd

import numpy as np #进行具体的sum,count等计算时候要用到的

df=pd.read_csv('d:/snp/nh23.csv') #这里绝对路径一定要用/,windows下也是如此,不加参数默认csv文件首行为标题行

df.head() #查看引入的csv文件前5行数据

df[“播种面积”] #查看指定列,后面跟[:5]查看前5行数据

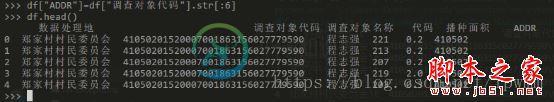

df[“调查对象代码”].str[:6] #获取指定列前6位字符串

df["ADDR"]=df["调查对象代码"].str[:6] #将上一行处理后的6位地址码作为新列ADDR插入

gp=df.groupby(["ADDR","代码"])["播种面积"].sum() #根据ADDR和代码进行分组后对播种面积列进行sum求和计算

pv=df.pivot_table(["播种面积"],index="ADDR",columns="代码",margins=True,aggfunc=np.sum,fill_value=0) #数据透视图,对播种面积列进行汇总计算,index为行,columns为列,margins=True增加一个全部行汇总,aggfunc=np.sum透视图中对播种面积值进行sum计算,这里np是开头import的numpy as np,fill_value=0对空值进行0替换,否则没有数据会显示NaN

pv.to_csv("d:/snp/test.csv") #写入csv文件

总结

以上所述是小编给大家介绍的Python使用Pandas对csv文件进行数据处理的方法,希望对大家有所帮助,如果大家有任何疑问请给我留言,小编会及时回复大家的。在此也非常感谢大家对小牛知识库网站的支持!

如果你觉得本文对你有帮助,欢迎转载,烦请注明出处,谢谢!

-

本文向大家介绍python使用pandas处理excel文件转为csv文件的方法示例,包括了python使用pandas处理excel文件转为csv文件的方法示例的使用技巧和注意事项,需要的朋友参考一下 由于客户提供的是excel文件,在使用时期望使用csv文件格式,且对某些字段内容需要做一些处理,如从某个字段中固定的几位抽取出来,独立作为一个字段等,下面记录下使用acaconda处理的过程; (

-

本文向大家介绍pandas处理csv文件的方法步骤,包括了pandas处理csv文件的方法步骤的使用技巧和注意事项,需要的朋友参考一下 一、我的需求 对于这样的一个 csv 表,需要将其 (1)将营业部名称和日期和股票代码进行拼接 (2)对于除了买入金额不同的的数据需要将它们的买入金额相加,每个买入金额乘以买卖序号的符号表示该营业名称对应的买入金额 比如:xx公司,20190731,1,股票1,4

-

本文向大家介绍使用pandas库对csv文件进行筛选保存,包括了使用pandas库对csv文件进行筛选保存的使用技巧和注意事项,需要的朋友参考一下 这个操作现在看来真没啥难的,但是我找相关的资料真的找了好久。 多数大佬都是直接pandas官网甩我脸上,然后举一个入门级的例子。 https://pandas.pydata.org/docs/reference/index.html 首先导入panda

-

本文向大家介绍使用NumPy和pandas对CSV文件进行写操作的实例,包括了使用NumPy和pandas对CSV文件进行写操作的实例的使用技巧和注意事项,需要的朋友参考一下 数组存储成CSV之类的区隔型文件: 下面代码给随机数生成器指定种子,并生成一个3*4的NumPy数组 将一个数组元素的值设为NaN: NumPy的savetxt()函数是与loadtxt()相对应的一个函数,它能以诸如CSV

-

本文向大家介绍使用Python Pandas进行数据分析,包括了使用Python Pandas进行数据分析的使用技巧和注意事项,需要的朋友参考一下 在本教程中,我们将看到使用Python pandas库进行的数据分析。图书馆的熊猫都是用C语言编写的。因此,我们在速度上没有任何问题。它以数据分析而闻名。我们在熊猫中有两种类型的数据存储结构。它们是Series和DataFrame。让我们一一看。 1.

-

本文向大家介绍对pandas处理json数据的方法详解,包括了对pandas处理json数据的方法详解的使用技巧和注意事项,需要的朋友参考一下 今天展示一个利用pandas将json数据导入excel例子,主要利用的是pandas里的read_json函数将json数据转化为dataframe。 先拿出我要处理的json字符串: pandas.read_json的语法如下: 第一参数就是json文