如何清理Kafka的日志?

Kafka的消息存储在磁盘中,为了控制磁盘占用空间,Kafka需要不断地对过去的一些消息进行清理工作。Kafka的每个分区都有很多的日志文件,这样也是为了方便进行日志的清理。在Kafka中,提供日志清理和日志压缩两种方式:

日志删除(Log Deletion):按照指定的策略直接删除不符合条件的日志。

日志压缩(Log Compaction):按照消息的key进行整合,有相同key的但有不同value值,只保留最后一个版本。

在Kafka的broker或topic配置中:

以段(segment日志)为单位来进行定期清理的。本节我们来详细介绍Kafka数据处理中的日志删除和日志压缩。

定时日志删除任务

Kafka日志管理器中会有一个专门的日志删除任务来定期检测和删除不符合保留条件的日志分段文件,这个周期可以通过broker端参数log.retention.check.interval.ms来配置,默认值为300,000,即5分钟。当前日志分段的保留策略有3种:

1. 基于时间的保留策略

2. 基于日志大小的保留策略

3. 基于日志起始偏移量的保留策略

基于时间的保留策略

以下三种配置可以指定如果Kafka中的消息超过指定的阈值,就会将日志进行自动清理:

- log.retention.hours

- log.retention.minutes

- log.retention.ms

其中,优先级为 log.retention.ms > log.retention.minutes > log.retention.hours。默认情况,在broker中,配置如下:

log.retention.hours=168

也就是,默认日志的保留时间为168小时,相当于保留7天。

删除日志分段时:

1. 从日志文件对象中所维护日志分段的跳跃表中移除待删除的日志分段,以保证没有线程对这些日志分段进行读取操作

2. 将日志分段文件添加上“.deleted”的后缀(也包括日志分段对应的索引文件)

3. Kafka的后台定时任务会定期删除这些“.deleted”为后缀的文件,这个任务的延迟执行时间可以通过file.delete.delay.ms参数来设置,默认值为60000,即1分钟。

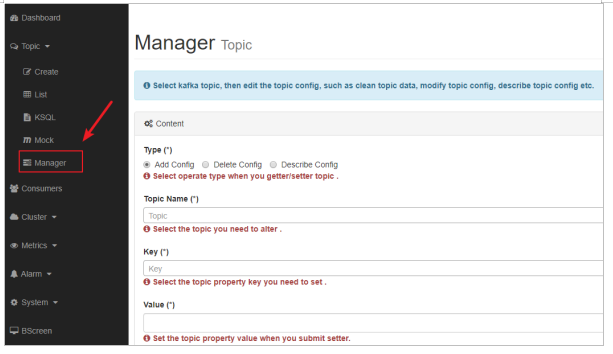

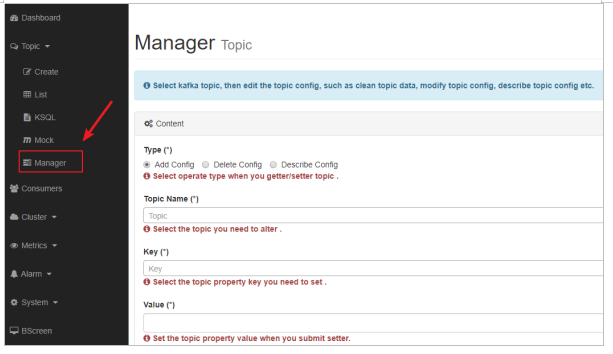

设置topic 5秒删除一次

1. 为了方便观察,设置段文件的大小为1M。

key: segment.bytes

value: 1048576

1. 设置topic的删除策略

key: retention.ms

value: 5000

尝试往topic中添加一些数据,等待一会,观察日志的删除情况。我们发现,日志会定期被标记为删除,然后被删除。

基于日志大小的保留策略

日志删除任务会检查当前日志的大小是否超过设定的阈值来寻找可删除的日志分段的文件集合。可以通过broker端参数 log.retention.bytes 来配置,默认值为-1,表示无穷大。如果超过该大小,会自动将超出部分删除。

注意:

log.retention.bytes 配置的是日志文件的总大小,而不是单个的日志分段的大小,一个日志文件包含多个日志分段。

基于日志起始偏移量保留策略

每个segment日志都有它的起始偏移量,如果起始偏移量小于 logStartOffset,那么这些日志文件将会标记为删

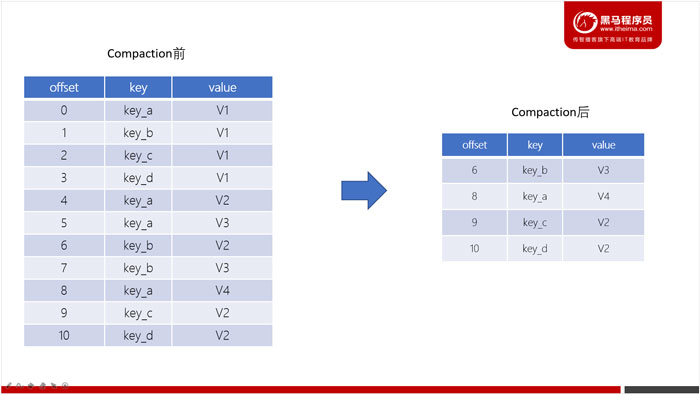

日志压缩(Log Compaction)

Log Compaction是默认的日志删除之外的清理过时数据的方式。它会将相同的key对应的数据只保留一个版本。

Log Compaction执行后,offset将不再连续,但依然可以查询Segment。

Log Compaction执行前后,日志分段中的每条消息偏移量保持不变。Log Compaction会生成一个新的Segment文件。

Log Compaction是针对key的,在使用的时候注意每个消息的key不为空。

基于Log Compaction可以保留key的最新更新,可以基于Log Compaction来恢复消费者的最新状态。

-

kafka版本1.1 我们使用Kafka KStream根据事件本身中选定的键聚合事件。大致低于它的作用 在“聚合器”函数中,我在一定条件下返回空值,以产生墓碑事件。 kafka创建两个主题,重新分区和变更。在重新分区主题中保留设置为-1。不管墓碑事件如何,这些主题都在继续增长。我找不到清理它们的方法。 我们的要求是直截了当的: 只要满足密钥的条件,该密钥的聚合更改日志就没有用处。我们希望彻底永久

-

我刚刚注意到我的笔记本电脑上的磁盘空间用完了。通过发现,Docker使用了很多: 文件夹包含152个以结尾的文件夹。 我已经运行了以下命令来清理 什么是,为什么它会消耗那么多空间,我如何清理它? 我有Docker版本17.06.1-CE,版本874A737。它是在一次清理之后发生的,所以这肯定还是一个问题。

-

null 正如https://stackoverflow.com/a/51845202/2674303的注释中提到的,我可以在metadataStore表中添加额外的列,在该列中我可以标记消息是否已处理。根本不是问题。但是我如何在我的清洁器中使用这个标志呢?MetadataStore只有键和值

-

问题内容: 我使用以下命令读取了Docker容器日志输出 我通过调用来将大量数据记录到node.js应用程序的日志中。我需要清理日志,因为它太长了,并且该命令首先运行日志的现有行,然后结束。我该如何清洁使其再次变短?我想查看类似的命令: 但是它似乎不存在。 问题答案: 首先,如果只需要查看较少的输出,则可以让docker只向您显示更新的行: 或者,您可以限制一些行: 要删除Docker for L

-

partition/data只有15G,kafka日志文件夹是-/data/var/kafka/kafka-logs data/var/kafka/kafka-logs下的大多数文件夹大小为4K-40K 但两个文件夹的大小非常大--5G-7G,这导致/数据是100%

-

问题内容: 我过去经常查看特定容器的日志。 有清除这些日志的好方法吗? 问题答案: 从这个问题出发,您可以运行一种代码: 或有类似的truncate命令: 我对这两个都不满意,因为它们直接修改Docker的文件。当docker将json格式的数据写入文件时,可能会发生外部日志删除,导致部分行并破坏了从cli 读取任何日志的能力。 相反,您可以让Docker自动为您轮换日志。如果使用默认的JSON日

-

我想清除JTextArea。 目前,我正在使用 如果我使用

-

本文向大家介绍MySQL 自动清理binlog日志的方法,包括了MySQL 自动清理binlog日志的方法的使用技巧和注意事项,需要的朋友参考一下 说明: 开启MySQL binlog日志的服务器,如果不设置自动清理日志,默认binlog日志一直保留着,时间一长,服务器磁盘空间被binlog日志占满,导致MySQL数据库出错。 使用下面方法可以安全清理binlog日志 一、没有主从同步的情况下清理