基于Centos7 部署Varnish缓存代理服务器

一.Varnish概述

1.Varnish 简介

Varnish是一款高性能且开源的反向代理服务器和HTTP加速器,其采用全新的软件体系机构,和现在的硬件体系紧密配合。与传统的squid相比,Varnish具有高性能、速度快、管理更加方便等优点,目前很多大型的网站都开始尝试使用Varnish来代替squid,这便是Varnish迅速发展的最根本的原因。

Varnish的主要特征:

(1)缓存代理位置:可以使用内存也可以使用磁盘;

(2)日志存储:日志存储在内存中;

(3)支持虚拟内存的使用;

(4)有精确的时间管理机制,即缓存的时间属性控制;

(5)状态引擎架构:在不同的引擎上完成对不同的缓存和代理数据进行处理;

(6)缓存管理:以二叉堆管理缓存数据,做到数据的及时清理;

2.Varnish 与 Squid 的对比相同点

- 都是开源软件;

- 都是一个反向代理服务器;

Varnish 的优势

(1)稳定性:Varnish和Squid在完成相同负载的工作时,Squid服务器发生故障的几率要高于Varnish,因为使用Squid需要经常重启;

(2)访问速度更快:Varnish所有缓存的数据都是直接从内存中读取,而Squid是从硬盘中读取;

(3)支持更多的并发连接:因为Varnish的TCP连接和释放的速度比Squid快很多

Varnish 的劣势

(1)Varnish进程一旦重启,缓存数据都会从内存中完全释放,此时所有请求都会发送到后端服务器,在高并发情况下,会给后端服务器造成很大压力;

(2)在Varnish使用中如果使用单个URL的请求通过负载均衡时,则每次请求都会落在不同的Varnish服务器中,造成请求都会到后端服务器;而且同样的秦桂在多台服务器上缓存,也会造成Varnish的缓存资源的浪费,造成性能下降;

Varnish 劣势的解决方案

针对劣势一:在访问量很大的情况下推荐使用 varnish 的内存缓存方式启动,而且后面需要 跟多台 squid/nginx 服务器。主要为了防止前面的 varnish 服 务、服务器被重启的情况下, 大量请求穿透 varnish,这样 squid/nginx 可以就担当第二层 CACHE,而且也弥补了 varnish 缓 存在内存中重启都会释放的问题;

针对劣势二:可以在负载均衡上做 url 哈希,让单个 url 请求固定请求到一台 varnish 服务器 上;

3.Varnish的工作原理

当Varnish服务器收到客户端的请求时,首选检查缓存中是否有数据,如果有,则直接响应客户端;如果没有则向后端服务器请求相应的资源,缓存到Varnish服务器本地,再响应客户端;

根据规则和请求页面的类型选择数据是否需要进行缓存,可以根据请求头中Cache-Contorl判断是否缓存,以及cookis是否有标记,这些功能都可以通过编写配置文件的方式来实现。

4.Varnish简单架构

Varnish分为management进程和child进程

- management进程:对child进程进行管理,同事对VCL配置进行编译,并应用到不同的状态引擎中;

- child进程:生成线程池,负责对用户请求进行处理,并通过hash查找返回用户结果;

child进程生成的常见线程有

- accept线程:接收新的连接请求并响应;

- worker线程:会话,处理请求资源;

- expiry线程:清除缓存中过期的内容;

5.varnish 主要配置部分

- 后端配置:给Varnish添加反向代理服务器节点,最少配置一个;

- ACL配置:给Varnish添加访问控制列表,可以指定这些列表访问或禁止访问;

- probes配置:给Varnish添加探测后端服务器是否正常的规则,方便切换或禁止对应后端服务器;

- directors配置:给Varnish添加负载均衡模式管理多个后端服务器;

- 核心子程序配置:给Varnish添加后端服务器切换,请求缓存、访问控制、错误处理等规则;

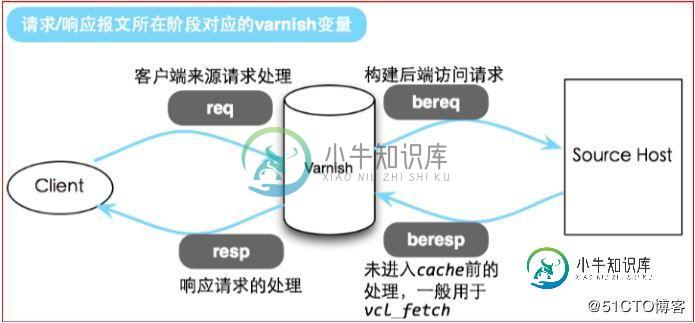

6.VCL 中内置预设变量:变量(也叫 object):

如图

(1)req:客户端请求Varnish服务器时可用的变量;

(2)bereq:Varnish服务器请求后端服务器可用的变量;

(3)beresp:后端服务器响应Varnish服务器请求,并返回结果时,使用的变量;

(4)resp:Varnish服务器响应客户端请求是使用的变量;

(5)obj:高速缓存对象,缓存后端响应请求内容;

(6)now:作用就是返回当前的时间戳;

客户端

Clienet.ip:返回客户端的IP地址

Client.port:获取客户端请求的端口号(在vatnish4.0以后需要调取std模块才能使用)语法为 import std; std.port(client.ip)

Client.identiy 获取客户端标识码,软件在安装过程中会生成一个序列号,用来标识身份

服务器

Server.hostname:服务器主机名

Server.identiy:获取服务器标识码

Server.ip:获取服务器IP地址

Server.prot:获取服务器IP端口号,需要调用std模块

客户端请求req (客户端请求发送的对象)

- Req:整个请求的数据结构

- req.bachend_hint:指定请求后端节点 如gif 给图片服务器

- Req.can_gzip:客户端是否接受gzip传输编码(通常浏览器支持所有压缩格式)

- req.hash_always_miss:是否从缓存中读取数据

- req.hash_ignore_busy: 忽略缓存中忙碌的数据 死锁(如两台varnish服务器在处理过程中共同争抢一个资源造成堵塞,如果不手动停止则会僵持支持僵持下去)

- req.http:对应请求http的header

- req.method :请求类型或者请求的方式(如gt,post)

- req.proto:客户端请求使用的http协议的版本

- req.restarts:重新启动次数,默认最大值是4(通常用于判断是否访问过服务器)

- req.url:请求的url

- req.xid:唯一id,varnish服务器访问时在头部增加了X-varnish,后面的数字是varnish的id,第一个数据是请求的标识id,第二个数据是缓存的标识id

varnish请求后端服务器(bereq)

- bereq:整个后端请求的数据结构

- bereq.backend:所请求后端节点的配置

- bereq.between_bytes_timeout:从后端每接收一个字节之间的等待时间或者超时时间

- bereq.http:对应发送到后端的http的头部信息

- bereq.method: 发送到后端的请求类型或者请求方式

- bereq.proto:发送到后端的请求的http协议版本

- bereq.retires:相同请求重试计数

- bereq.uncacheable:请求数据没有被缓存,或者请求不缓存

- bereq.url:发送到后端请求的url

- bereq.xid:请求唯一id

后端服务器向varnish返回数据beresq

- Beresp:后端服务器响应数据

- Beresp.backend.ip:后端响应(处理请求数据)服务器的IP地址

- Beresp.backend.name:后端响应服务器的节点名

- Beresp.do_gunzip:默认为false,缓存前解压改对象

- Beresp.grace:设置缓存过期的额外宽限时间

- Beresp.http:响应时http的头部

- Beresp.keep:对象缓存后带保持时间

- Beresp.proto:响应的http版本

- Beresp.reason :后端服务器返回的http状态信息

- Beresp.status:后端服务器返回的在状态码

- Beresp.storage_hint:指定保存的的特定存储器(内存)

- Beresp.ttl:改对象缓存的剩余时间,指定统一缓存剩余时间

- Beresp,uncacheable:对数据不进行缓存

存储

- Storage.<name>.free_space:存储可用空间(字节数)

- Storage.<name>.used_space:存储剩余时间(字节数)

- Storage.<name>.happy:存储节点状态

- deliver将数据发送给客户端,返回的数据

- fetch从后端获取数据,并将数据缓存到本地

7.特定功能语句

- Ban(expression):清除指定对象缓存;

- Call(subroutine):调用子程序;

- Hash_data(input):根据input的子程序的值生成hash键;

- New():创建新的vcl对象,只能在vcl_init 子进程中;

- Return():结束当前子程序,并指定继续下一步动作;

- Rollback():恢复 HTTP 头到原来状态,已经弃用,使用 std.rollback() 代替;

- Synthetic (STRING):合成器,定义返回给客户端页面和状态码;

- Regsub(str,regex,sub)使用正则表达式替换第一次出现的字符串;

- Regsuball(str,regex,sub)替换所有出现的字符串;

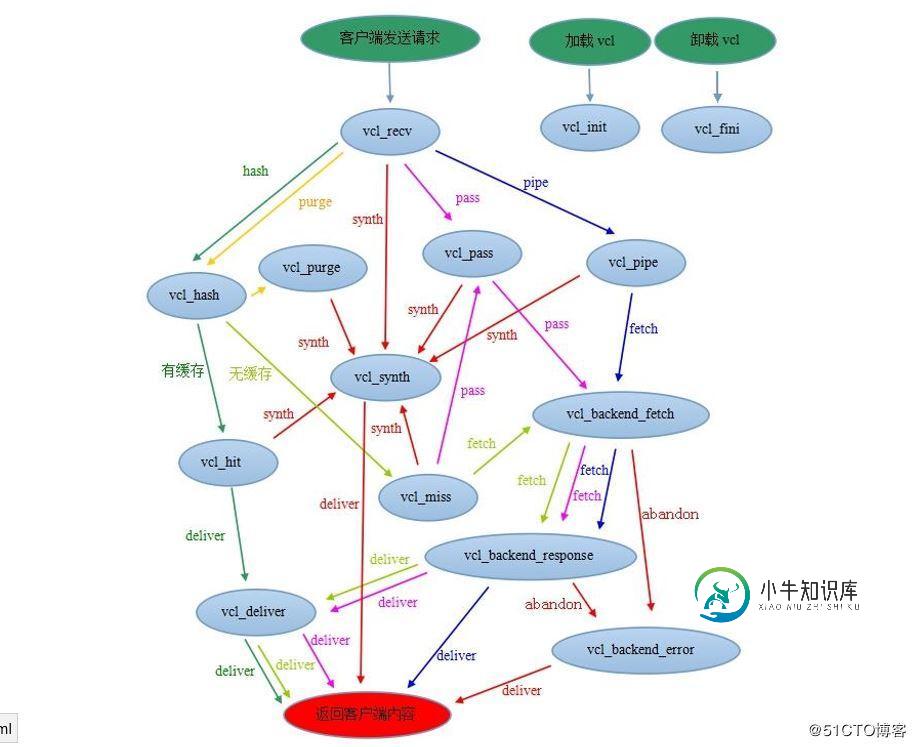

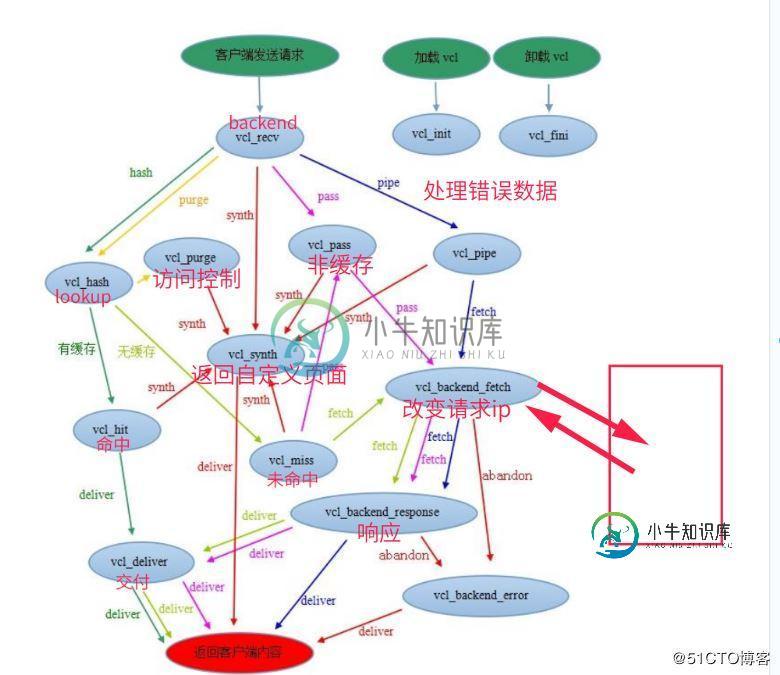

8.varnish请求处理的步骤

如图

varnish请求处理的步骤

Receive 状态(vcl_recv)。也就是请求处理的入口状态,根据 VCL 规则判断该请求应该 pass(vcl_pass)或是 pipe(vcl_pipe),还是进入 lookup(本地查询)。

Lookup 状态。进入该状态后,会在 hash 表中查找数据,若找到,则进入 hit(vcl_hit)状态,否则进入 miss(vcl_miss)状态。

Pass(vcl_pass)状态。在此状态下,会直接进入后端请求,即进入 fetch(vcl_fetch)状态

Fetch(vcl_fetch)状态。在 fetch 状态下,对请求进行后端获取,发送请求,获得数据,并根据设置进行本地存储。

Deliver(vcl_deliver)状态。将获取到的数据发给客户端,然后完成本次请求。

Pipe状态。建立客户端和服务器之间的直接连接,从后端服务器调取数据

vcl_recv 子程序: 开始处理请求,通过 return (动作);

vcl_pipe 子程序: pipe 模式处理,该模式主要用于直接取后端响应内容返回客户端,可定义响应内容返回客户端。

vcl_pass 子程序: pass 模式处理,该模式类似 hash 缓存模式,仅不做缓存处理.

vcl_hit 子程序: hash 缓存模式时,存在 hash 缓存时调用,用于缓存处理,可放弃或修改缓存.

vcl_miss 子程序: hash 缓存模式时,不存在 hash 缓存时调用,用于判断性的选择进入后端取响应内容,可以 修改为 pass 模式。

vcl_hash 子程序: hash缓存模式,生成hash值作为缓存查找键名提取缓存内容,主要用于缓存hash键值处理, 可使用 hash_data(string) 指定键值组成结构,可在同一个页面通过 IP 或 cookie 生成不同的 缓存键值。

vcl_purge 子程序: 清理模式,当查找到对应的缓存时清除并调用,用于请求方法清除缓存,并报告

vcl_deliver 子程序: 客户端交付子程序,在 vcl_backend_response 子程序后调用(非 pipe 模式),或 vcl_hit 子程 序后调用,可用于追加响应头信息,cookie 等内容。

vcl_backend_fetch 子程序: 发送后端请求之前调用,可用于改变请求地址或其它信息,或放弃请求。

vcl_backend_response 子程序: 后端响应后调用,可用于修改缓存时间及缓存相关信息。

vcl_backend_error 子程序: 后端处理失败调用,异常页面展示效果处理,可自定义错误响应内容,或修改 beresp.status 与 beresp.http.Location 重定向等。

vcl_synth 子程序: 自定义响应内容。可以通过 synthetic()和返回值 synth 调用,这里可以自定义异常显示 内容,也可以修改 resp.status 与 resp.http.Location 重定向。

vcl_init 子程序: 加载 vcl 时最先调用,用于初始化 VMODs,该子程序不参与请求处理,仅在 vcl 加载时调用 一次。

vcl_fini 子程序: 卸载当前 vcl 配置时调用,用于清理 VMODs,该子程序不参与请求处理,仅在 vcl 正常丢弃 后调用。

二.安装Varnish

下载varnish软件包 链接: https://pan.baidu.com/s/1OfnyR-5xFuxMUYJTnhQesA 提取码: m9q4

除了一台varnish服务器,可以再开俩台web服务器,提供web页面就可以。

[root@localhost ~]# yum -y install autoconf automake libedit-devel libtool ncurses-devel pcre-devel pkgconfig python-docutils python-sphinx

[root@localhost ~]# tar zxf varnish-4.0.3.tar.gz

[root@localhost ~]# cd varnish-4.0.3/

[root@localhost varnish-4.0.3]# ./configure && make && make install

[root@localhost varnish-4.0.3]# cp etc/example.vcl /usr/local/var/varnish/

//复制Varnish主配置文件

[root@localhost /]# vim /usr/local/var/varnish/example.vcl

//编辑Varnish主配 看原来的修改

vcl 4.0;

import directors;

import std;

backend default {

.host = "127.0.0.1";

.port = "80";

}

probe backend_healthcheck {

.url="/";

.interval = 5s;

.timeout = 1s;

.window = 5;

.threshold = 3;

}

backend web1 {

.host = "192.168.148.132";

.port = "80";

.probe = backend_healthcheck;

}

backend web2 {

.host = "192.168.148.133";

.port = "80";

.probe = backend_healthcheck;

}

acl purgers {

"127.0.0.1";

"localhost";

"192.168.148.0/24";

!"192.168.148.133";

}

sub vcl_init {

new web_cluster=directors.round_robin();

web_cluster.add_backend(web1);

web_cluster.add_backend(web2);

}

//把原来的全部删除添加如下

sub vcl_recv {

set req.backend_hint = web_cluster.backend();

if (req.method == "PURGE") {

if (!client.ip ~ purgers) {

return (synth(405, "Not Allowed."));

}

return (purge);

}

if (req.method != "GET" &&

req.method != "HEAD" &&

req.method != "PUT" &&

req.method != "POST" &&

req.method != "TRACE" &&

req.method != "OPTIONS" &&

req.method != "PATCH" &&

req.method != "DELETE") {

return (pipe);

}

if (req.method != "GET" && req.method != "HEAD") {

return (pass);

}

if (req.url ~ "\.(php|asp|aspx|jsp|do|ashx|shtml)($|\?)") {

return (pass);

}

if (req.http.Accept-Encoding) {

if (req.url ~ "\.(bmp|png|gif|jpg|jpeg|ico|gz|tgz|bz2|tbz|zip|rar|mp3|mp4|ogg|swf|flv)$") {

unset req.http.Accept-Encoding;

} elseif (req.http.Accept-Encoding ~ "gzip") {

set req.http.Accept-Encoding = "gzip";

} elseif (req.http.Accept-Encoding ~ "deflate") {

set req.http.Accept-Encoding = "deflate";

} else {

unset req.http.Accept-Encoding;

}

}

if (req.url ~ "\.(css|js|html|htm|bmp|png|gif|jpg|jpeg|ico|gz|tgz|bz2|tbz|zip|rar|mp3|mp4|ogg|swf|flv)($|\?)") {

unset req.http.cookie;

return (hash);

}

if (req.restarts == 0) {

if (req.http.X-Forwarded-For) {

set req.http.X-Forwarded-For = req.http.X-Forwarded-For + ", " + client.ip;

} else {

set req.http.X-Forwarded-For = client.ip;

}

}

return (hash);

}

sub vcl_hash {

hash_data(req.url);

if (req.http.host) {

hash_data(req.http.host);

} else {

hash_data(server.ip);

}

return (lookup);

}

sub vcl_hit {

if (req.method == "PURGE") {

return (synth(200, "Purged."));

}

return (deliver);

}

sub vcl_miss {

if (req.method == "PURGE") {

return (synth(404, "Purged."));

}

return (fetch);

}

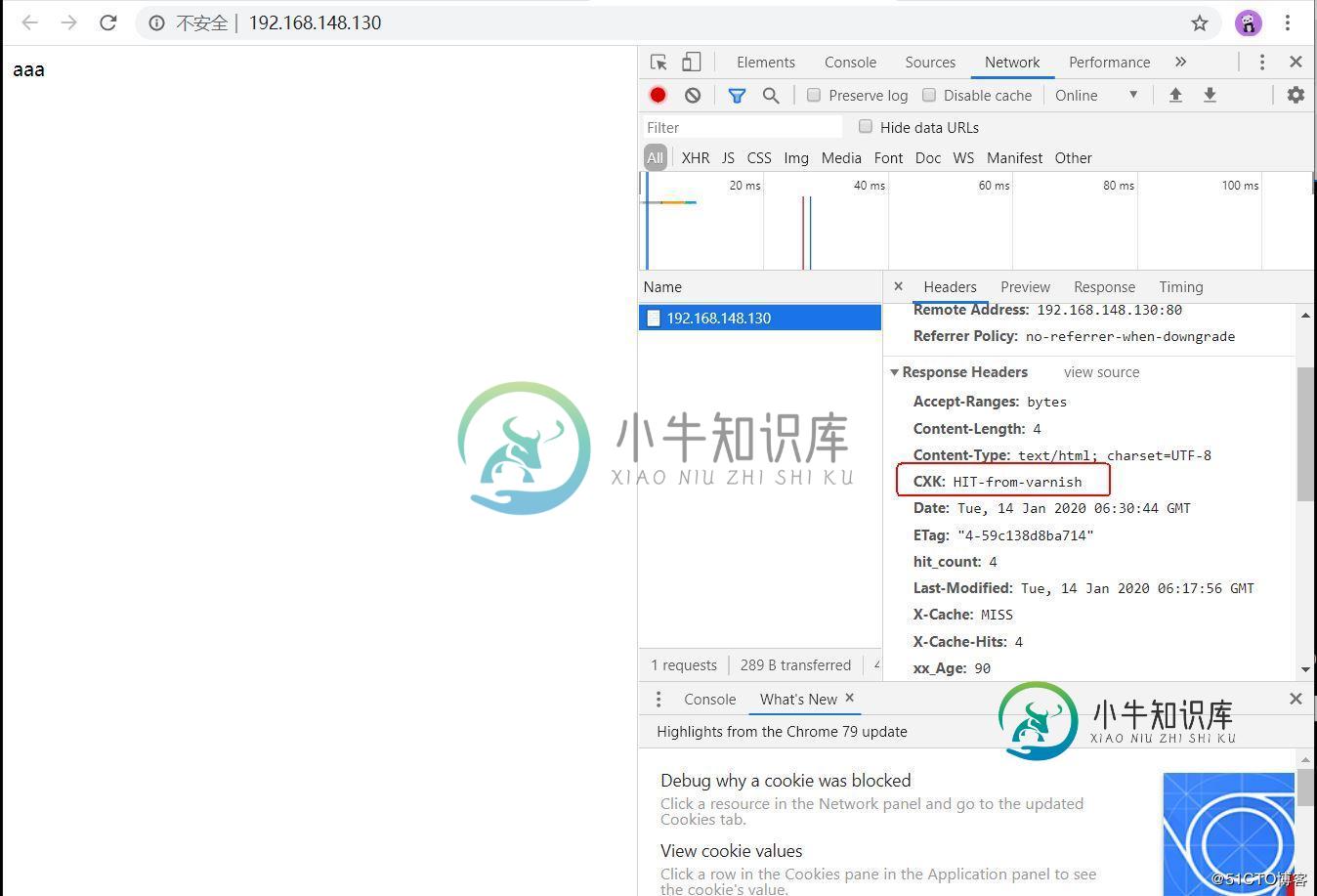

sub vcl_deliver {

if (obj.hits > 0) {

set resp.http.CXK = "HIT-from-varnish";

set resp.http.X-Cache-Hits = obj.hits;

} else {

set resp.http.X-Cache = "MISS";

}

unset resp.http.X-Powered-By;

unset resp.http.Server;

unset resp.http.X-Drupal-Cache;

unset resp.http.Via;

unset resp.http.Link;

unset resp.http.X-Varnish;

set resp.http.xx_restarts_count = req.restarts;

set resp.http.xx_Age = resp.http.Age;

set resp.http.hit_count = obj.hits;

unset resp.http.Age;

return (deliver);

}

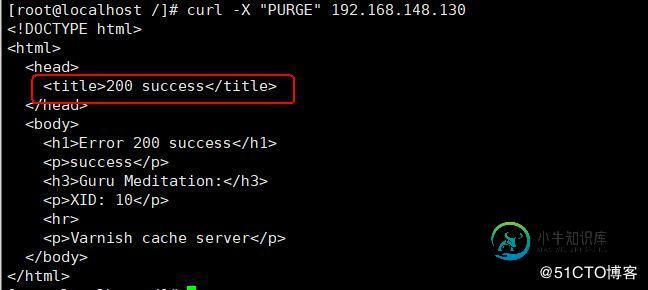

sub vcl_purge {

return (synth(200,"success"));

}

sub vcl_backend_error {

if (beresp.status == 500 ||

beresp.status == 501 ||

beresp.status == 502 ||

beresp.status == 503 ||

beresp.status == 504) {

return (retry);

}

}

sub vcl_fini {

return (ok);

}

[root@localhost /]# varnishd -f /usr/local/var/varnish/example.vcl -s malloc,200M -a 0.0.0.0:80

//启动服务

第一台web提供页面

[root@localhost ~]# yum -y install httpd [root@localhost ~]# echo aaa > /var/www/html/index.html [root@localhost ~]# systemctl stop firewalld [root@localhost ~]# systemctl start httpd

第二台

[root@localhost ~]# yum -y install httpd [root@localhost ~]# echo bbb > /var/www/html/index.html [root@localhost ~]# systemctl stop firewalld [root@localhost ~]# systemctl start httpd

如果重启Varnishd如下:

[root@localhost /]# netstat -anpt | grep 80 [root@localhost /]# killall -9 varnishd [root@localhost /]# varnishd -f /usr/local/var/varnish/example.vcl -s malloc,200M -a 0.0.0.0:80

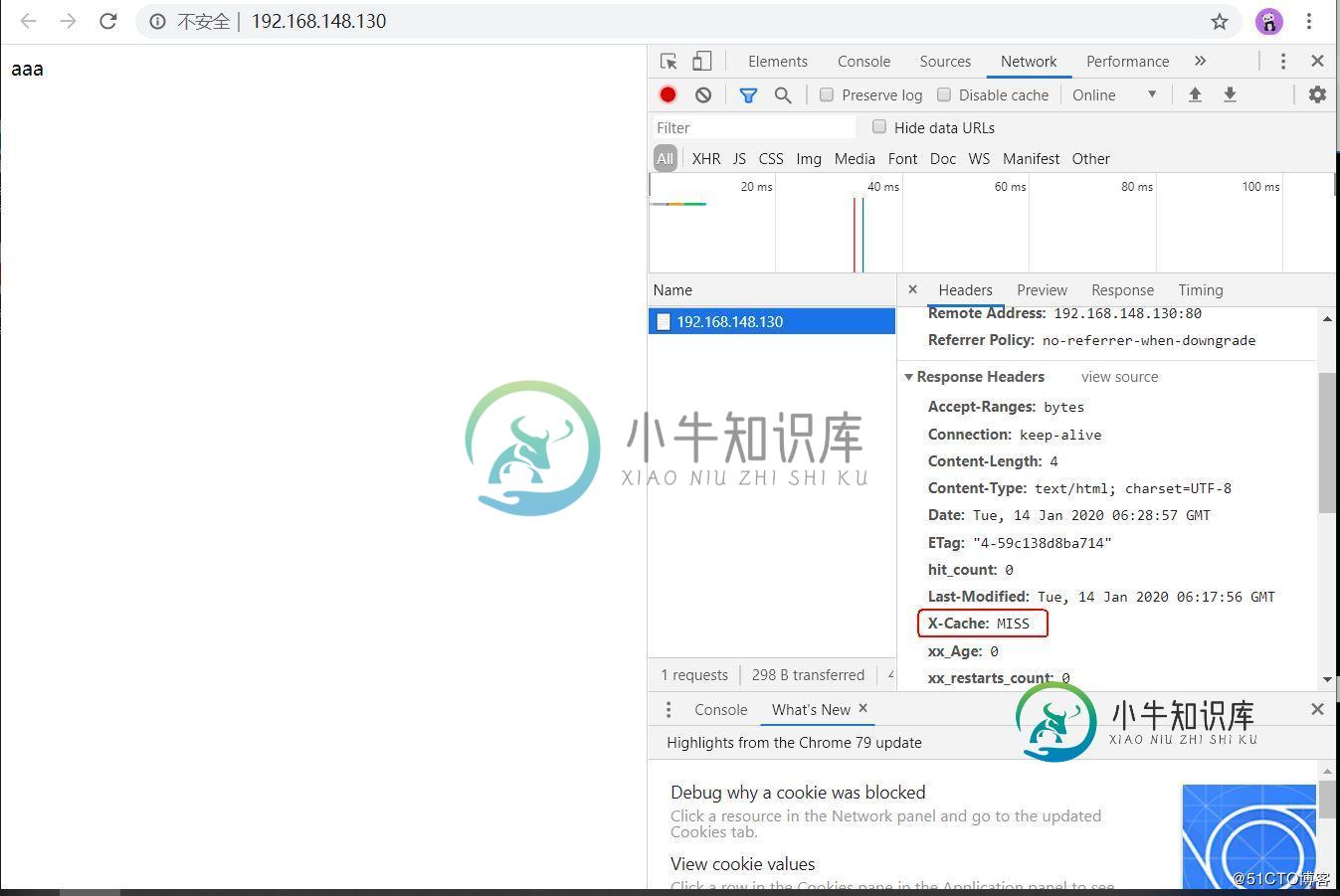

客户端访问如下:

刷新一下

[root@localhost /]# curl -X "PURGE" 192.168.148.130 //清除缓存

Varnish配置文件解释

vcl 4.0;

import directors;

import std;

# Default backend definition. Set this to point to your content server.

probe backend_healthcheck {

.url="/"; #访问后端服务器根路径

.interval = 5s; #请求时间间隔

.timeout = 1s; #请求超时时间

.window = 5; #指定轮询次数5次

.threshold = 3; #如果出现3次失败则表示后端服务器异常

}

backend web1 { #定义后端服务器

.host = "192.168.1.7"; #要转向主机(即后端主机)的 IP 或域名

.port = "80"; #指定后端服务器的端口号

.probe = backend_healthcheck; #健康检查调用backend_healthcheck定义的内容

}

backend web2 {

.host = "192.168.1.8";

.port = "80";

.probe = backend_healthcheck;

}

acl purgers { #定义访问控制列表

"127.0.0.1";

"localhost";

"192.168.1.0/24";

!"192.168.1.8";

}

sub vcl_init { #调用 vcl_init 初始化子程序创建后端主机组,即 directors

new web_cluster=directors.round_robin(); #使用 new 关键字创建 drector 对象,使用 round_robin(轮询) 算法

web_cluster.add_backend(web1); #添加后端服务器节点

web_cluster.add_backend(web2);

}

sub vcl_recv {

set req.backend_hint = web_cluster.backend(); #指定请求的后端节点web_cluster定义的后端节点

if (req.method == "PURGE") { #判断客户端的请求头部是否是PURGE

if (!client.ip ~ purgers) { #如果是,再判断客户端的IP地址是不是在ACL访问控制列表中.

return (synth(405, "Not Allowed.")); #如果不是,返回给客户端405状态码并且返回定义的页面.

}

return (purge); #如果是ACL定义的,则交给purge处理.

}

if (req.method != "GET" &&

req.method != "HEAD" &&

req.method != "PUT" &&

req.method != "POST" &&

req.method != "TRACE" &&

req.method != "OPTIONS" &&

req.method != "PATCH" &&

req.method != "DELETE") { #判断客户端的请求类型

return (pipe);

}

if (req.method != "GET" && req.method != "HEAD") {

return (pass); #如果不是GET及HEAD则交给pass.

}

if (req.url ~ "\.(php|asp|aspx|jsp|do|ashx|shtml)($|\?)") {

return (pass); #当客户端访问的是.php等结尾的交给pass处理.

}

if (req.http.Accept-Encoding) {

if (req.url ~ "\.(bmp|png|gif|jpg|jpeg|ico|gz|tgz|bz2|tbz|zip|rar|mp3|mp4|ogg|swf|flv)$") {

unset req.http.Accept-Encoding; #取消客户端接收的压缩类型

} elseif (req.http.Accept-Encoding ~ "gzip") {

set req.http.Accept-Encoding = "gzip"; #如果有gzip类型,标记gzip类型.

} elseif (req.http.Accept-Encoding ~ "deflate") {

set req.http.Accept-Encoding = "deflate";

} else {

unset req.http.Accept-Encoding; #其他未定义的页面也取消客户但接收的压缩类型.

}

}

if (req.url ~ "\.(css|js|html|htm|bmp|png|gif|jpg|jpeg|ico|gz|tgz|bz2|tbz|zip|rar|mp3|mp4|ogg|swf|flv)($|\?)") {

unset req.http.cookie; #取消客户端的cookie值.

return (hash); #将请求转发给hash子程序,也就是查看本地缓存.

}

if (req.restarts == 0) { #判断客户端是不是第一次请求

if (req.http.X-Forwarded-For) { #如果是第一次请求,设置获取客户端的IP地址.

set req.http.X-Forwarded-For = req.http.X-Forwarded-For + ", " + client.ip;

} else {

set req.http.X-Forwarded-For = client.ip;

}

}

return (hash);

}

sub vcl_hash {

hash_data(req.url); #查看客户端请求的页面,并且进行hash

if (req.http.host) {

hash_data(req.http.host); #设置客户端的主机

} else {

hash_data(server.ip); #设置服务器的IP

}

return (lookup);

}

sub vcl_hit {

if (req.method == "PURGE") { #如果是HIT并且当客户端请求的类型是PURGE返回的200的状态码,并返回相应页面.

return (synth(200, "Purged."));

}

return (deliver);

}

sub vcl_miss {

if (req.method == "PURGE") {

return (synth(404, "Purged.")); #如果是miss返回404

}

return (fetch);

}

sub vcl_deliver {

if (obj.hits > 0) {

set resp.http.CXK = "HIT-from-varnish"; #设置http头部X-Cache =hit

set resp.http.X-Cache-Hits = obj.hits; #返回命令的次数

} else {

set resp.http.X-Cache = "MISS";

}

unset resp.http.X-Powered-By; #取消显示web版本

unset resp.http.Server; #取消显示varnish服务

unset resp.http.X-Drupal-Cache; #取消显示缓存的框架

unset resp.http.Via; #取消显示文件内容来源

unset resp.http.Link; #取消显示HTML的超链接地址

unset resp.http.X-Varnish; #取消显示varnish的id

set resp.http.xx_restarts_count = req.restarts; #设置客户端请求的次数

set resp.http.xx_Age = resp.http.Age; #显示缓存文件的时长

#set resp.http.hit_count = obj.hits; #显示缓存命中的次数

#unset resp.http.Age;

return (deliver);

}

sub vcl_pass {

return (fetch); #将后端服务器返回的数据缓存到本地

}

sub vcl_backend_response {

set beresp.grace = 5m; #缓存额外宽限时间

if (beresp.status == 499 || beresp.status == 404 || beresp.status == 502) {

set beresp.uncacheable = true; #当后端服务器相应状态码是449等,不缓存

}

if (bereq.url ~ "\.(php|jsp)(\?|$)") {

set beresp.uncacheable = true; #当是PHP的页面不缓存

} else {

if (bereq.url ~ "\.(css|js|html|htm|bmp|png|gif|jpg|jpeg|ico)($|\?)") {

set beresp.ttl = 15m; #当是上面结尾的,缓存15分钟

unset beresp.http.Set-Cookie;

} elseif (bereq.url ~ "\.(gz|tgz|bz2|tbz|zip|rar|mp3|mp4|ogg|swf|flv)($|\?)") {

set beresp.ttl = 30m; #缓存30分钟

unset beresp.http.Set-Cookie;

} else {

set beresp.ttl = 10m; #生存时间10分钟

unset beresp.http.Set-Cookie;

}

}

return (deliver);

}

sub vcl_purge {

return (synth(200,"success"));

}

sub vcl_backend_error {

if (beresp.status == 500 ||

beresp.status == 501 ||

beresp.status == 502 ||

beresp.status == 503 ||

beresp.status == 504) {

return (retry); #如果状态码是上述其中之一,则重新请求

}

}

sub vcl_fini {

return (ok);

}

以上就是本文的全部内容,希望对大家的学习有所帮助,也希望大家多多支持小牛知识库。

-

我使用Spring boot和hazelcast作为我的REST缓存服务。 我在服务层(API)使用带有自定义密钥生成器的spring@cacable注释进行缓存。除了从自定义键生成器函数中抛出RuntimeException之外,其他一切都可以正常工作,它不是由我添加到处理错误场景中的自定义错误类处理的。 扩展组织的自定义错误类(CacheErrorHandler)。springframewor

-

部署服务 我们使用 docker service 命令来管理 Swarm 集群中的服务,该命令只能在管理节点运行。 新建服务 现在我们在上一节创建的 Swarm 集群中运行一个名为 nginx 服务。 $ docker service create --replicas 3 -p 80:80 --name nginx nginx:1.13.7-alpine 现在我们使用浏览器,输入任意节点 IP

-

关于aiohttp服务器部署,这里有以下几种选择: 独立的服务器。 使用nginx, HAProxy等反向代理服务器,之后是后端服务器。 在反向代理之后在部署一层gunicorn,然后才是后端服务器。 独立服务器 只需要调用aiohttp.web.run_app(),并传递aiohttp.web.Application实例即可。 该方法最简单,也是在比较小的程序中最好的解决方法。但该方法并不能完全

-

我正在实现一个使用Swift Stack的Joss客户机调用外部服务的Lagom服务。如何缓存此信息以避免每次调用服务时都调用外部服务?

-

StaticCache 静态变量形式的缓存(是存放于当前进程的内存中)。注册中心的服务地址也存放于静态缓存中。 StaticCache::set($key, $value, $canUnset = true) use StaticCache; StaticCache::set('foo', 'bar'); //默认该变量可以被释放,也可设置不释放。使用情况:在使用Async

-

问题内容: 尽管我有很多编写代码的经验。我真的没有太多的部署经验。我正在编写一个项目,该项目使用mongodb进行持久化,使用redis进行元缓存,并使用其播放页面。我正在决定是否要购买专用服务器,还是要从亚马逊/ linode购买多个小型/中型实例(每个,mongo,redis,play一次)。我想到了以下折衷方案,我想知道是否有人可以添加到列表中或提供进一步的见解。我倾向于(b)从linode