PyCharm搭建Spark开发环境实现第一个pyspark程序

一, PyCharm搭建Spark开发环境

Windows7, Java1.8.0_74, Scala 2.12.6, Spark 2.2.1, Hadoop2.7.6

通常情况下,Spark开发是基于Linux集群的,但这里作为初学者并且囊中羞涩,还是在windows环境下先学习吧。

参照这个配置本地的Spark环境。

之后就是配置PyCharm用来开发Spark。本人在这里浪费了不少时间,因为百度出来的无非就以下两种方式:

1.在程序中设置环境变量

import os

import sys

os.environ['SPARK_HOME'] = 'C:\xxx\spark-2.2.1-bin-hadoop2.7'

sys.path.append('C:\xxx\spark-2.2.1-bin-hadoop2.7\python')

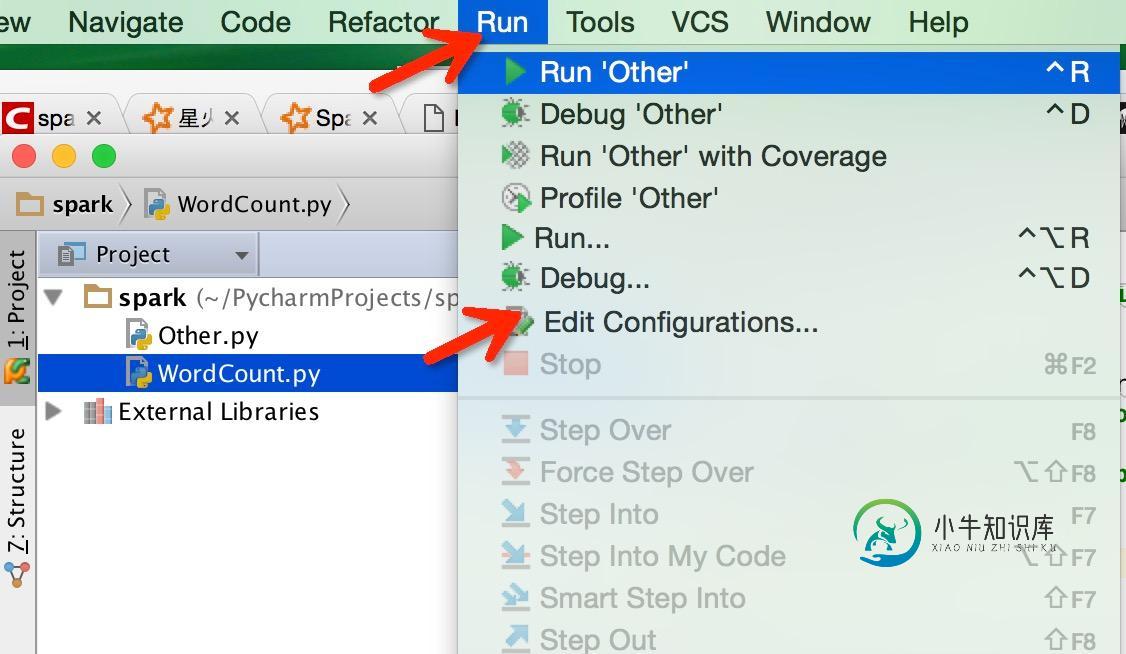

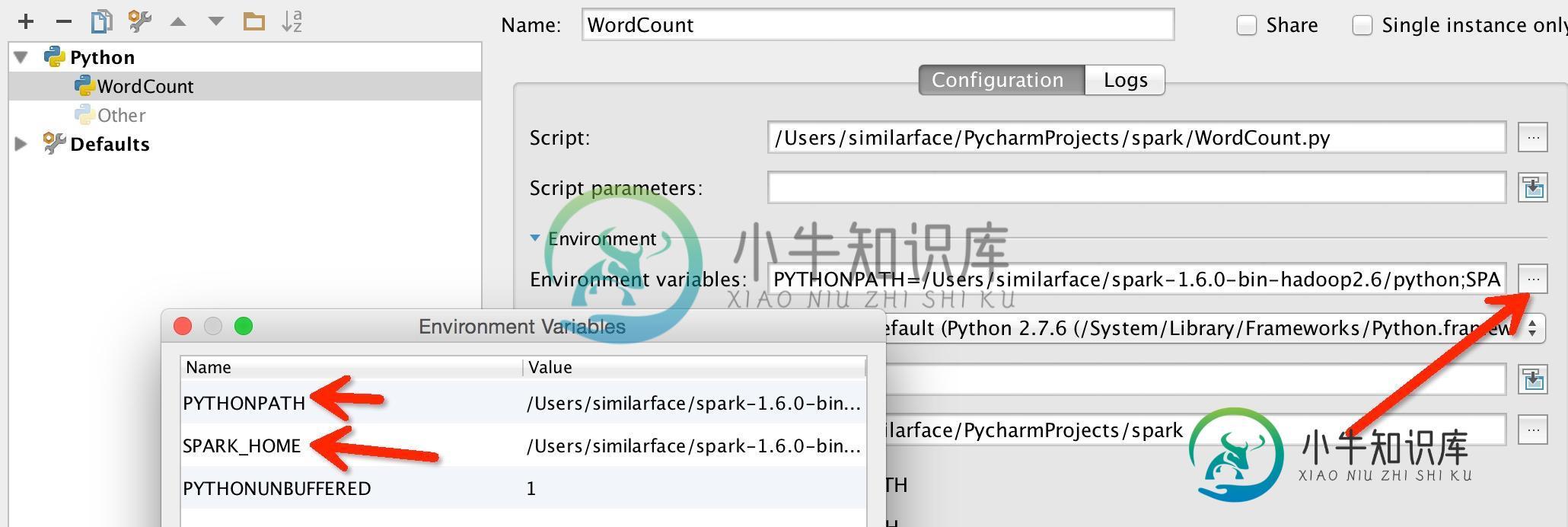

2.在Edit Configuration中添加环境变量

不过还是没有解决程序中代码自动补全。

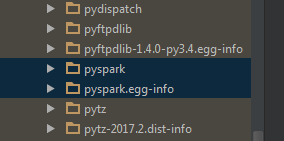

想了半天,观察到spark提供的pyspark很像单独的安装包,应该可以考虑将pyspark包放到python的安装目录下,这样也就自动添加到之前所设置的pythonpath里了,应该就能实现pyspark的代码补全提示。

将spark下的pyspark包放到python路径下(注意,不是spark下的python!)

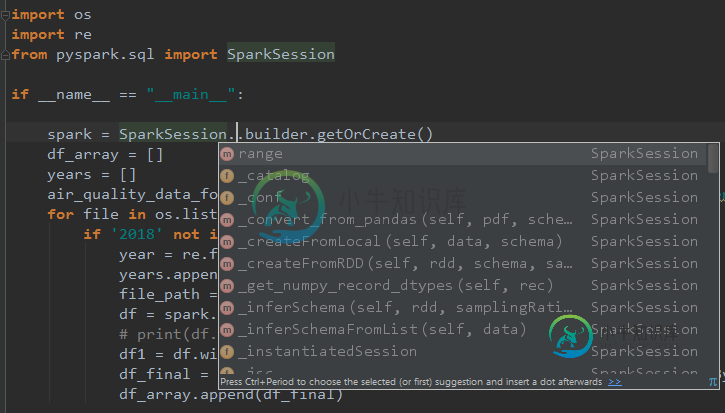

最后,实现了pyspark代码补全功能。

二.第一个pyspark程序

作为小白,只能先简单用下python+pyspark了。

数据:Air Quality in Madrid (2001-2018)

需求:根据历史数据统计出每个月平均指标值

import os

import re

from pyspark.sql import SparkSession

if __name__ == "__main__":

spark = SparkSession.builder.getOrCreate()

df_array = []

years = []

air_quality_data_folder = "C:/xxx/spark/air-quality-madrid/csvs_per_year"

for file in os.listdir(air_quality_data_folder):

if '2018' not in file:

year = re.findall("\d{4}", file)

years.append(year[0])

file_path = os.path.join(air_quality_data_folder, file)

df = spark.read.csv(file_path, header="true")

# print(df.columns)

df1 = df.withColumn('yyyymm', df['date'].substr(0, 7))

df_final = df1.filter(df1['yyyymm'].substr(0, 4) == year[0]).groupBy(df1['yyyymm']).agg({'PM10': 'avg'})

df_array.append(df_final)

pm10_months = [0] * 12

# print(range(12))

for df in df_array:

for i in range(12):

rows = df.filter(df['yyyymm'].contains('-'+str(i+1).zfill(2))).first()

# print(rows[1])

pm10_months[i] += (rows[1]/12)

years.sort()

print(years[0] + ' - ' + years[len(years)-1] + '年,每月平均PM10统计')

m_index = 1

for data in pm10_months:

print(str(m_index).zfill(2) + '月份: ' + '||' * round(data))

m_index += 1

运行结果:

- 2017年,每月平均PM10统计 01月份: |||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||| 02月份: |||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||| 03月份: |||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||| 04月份: |||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||| 05月份: |||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||| 06月份: |||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||| 07月份: |||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||| 08月份: |||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||| 09月份: |||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||| 10月份: |||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||| 11月份: |||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||| 12月份: ||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||

由以上统计结果,可以看出4月份的PM10最低。

Done!

以上就是本文的全部内容,希望对大家的学习有所帮助,也希望大家多多支持小牛知识库。

-

一、安装Spark 1.1 下载并解压 官方下载地址:http://spark.apache.org/downloads.html ,选择 Spark 版本和对应的 Hadoop 版本后再下载: 解压安装包: # tar -zxvf spark-2.2.3-bin-hadoop2.6.tgz 1.2 配置环境变量 # vim /etc/profile 添加环境变量: export SPARK

-

依照以下操作,你可使用Docker在Mac,Linux上搭建PPMessage开发环境。 前言:Docker 的作用 ? Docker allows you to package an application with all of its dependencies into a standardized unit for software development. Docker containe

-

《论语?魏灵公》曰:“工欲善其事,必先利其器”,做好一件事,准备工作非常重要。在开始学习Java技术之前,先介绍如何搭建Java开发环境是非常重要的一件事。 Oracle公司提供的JDK只是一个开发工具包,它不是一个IDE(Integrated Development Environments,集成开发环境),IDE的开发工具将程序的编辑、编译、调试、执行等功能集成在一个开发环境中,使用户可以很方

-

要开发kibana 插件,首先要在本地搭建开发环境,我这里推荐使用vs code,如果问我为什么,我只想说这么火的开发工具,不用一下,怎么跟上世界开发潮流呢。 第一步 首先 需要安装node.js,可以去官网下载最新版本,对于如何安装就不废话了。 第二步 下载 kibana 源代码,在github下载即可。 第三步 在kibana项目根目录下执行 1. $ git tag 2. $ git che

-

简单起见,一开始的服务器只会是一个工程,构建会也只是一个jar包。 开发环境就用最流行的java8、maven3,IDE可以随自己喜好。 新建maven工程,如下: POM文件如下: <?xml version="1.0" encoding="UTF-8"?> <project xmlns="http://maven.apache.org/POM/4.0.0" xmlns:xsi

-

我们将在Mac上使用docker环境编译kuberentes。 安装依赖 brew install gnu-tar Docker环境,至少需要给容器分配4G内存,在低于3G内存的时候可能会编译失败。 执行编译 切换目录到kuberentes源码的根目录下执行: ./build/run.sh make可以在docker中执行跨平台编译出二进制文件。 需要用的的docker镜像: gcr.io/goo