Python爬虫定时计划任务的几种常见方法(推荐)

记得以前的Windows任务定时是可以正常使用的,今天试了下,发现不能正常使用了,任务计划总是挂起。接下来记录下Python爬虫定时任务的几种解决方法。

1.方法一、while True

首先最容易的是while true死循环挂起,不废话,直接上代码:

import os

import time

import sys

from datetime import datetime, timedelta

def One_Plan():

# 设置启动周期

Second_update_time = 24 * 60 * 60

# 当前时间

now_Time = datetime.now()

# 设置 任务启动时间

plan_Time = now_Time.replace(hour=9, minute=0, second=0, microsecond=0)

# 设置差值,-1 day, 21:48:53.246576,类似于这样

# time.sleep()需要传入int,所以下面使用.total_seconds()

# 主要用来计算差值,返回int,具体功能可以自行查阅相关资料

delta = plan_Time - now_Time

first_plan_Time = delta.total_seconds() % Second_update_time

print("距离第一次执行需要睡眠%d秒" % first_plan_Time)

return first_plan_Time

# while Ture代码块,挂起程序,睡眠时间结束后调用函数名进行执行

while True:

s1 = One_Plan()

time.sleep(s1)

# 下面这里是自己定义的函数,想跑代码的可以换成hellow world函数或者注释掉这行测试下

exe_file(D_list)

print("正在执行首次更新程序")

个人感觉使用这种方式进行定时计划的启动如果为单个程序,并且一天执行一次的话没什么问题,如果要考虑到一天执行多个任务并且一天需要执行多次,短板一下就凸显出来了。

在工作的情况中还需要考虑到很多因素,比如爬虫程序需要在晚上12点和早上6点、9点,下午3点执行四次,并且需要同时执行4个爬虫,还需要考虑到网络是否稳定,如果程序挂掉该怎么处理等等因素。

2.方法二、Timer模块

之前说了最简单的定时启动,可以说是最简单粗暴的,人生苦短,python优雅,有没有那种很简单很简单,几行代码就可以搞定的那种?必须有的哈!简单举个例子说一下,上一个方法的末尾提到过需要考虑到其他因素,这就来了:

现在需要启动一个selenium的爬虫,使用火狐驱动+多线程,大家都明白的,现在电脑管家显示CPU占用率20%,启动selenium后不停的开启浏览器+多线程,好,没过5分钟,CPU占用率直接拉到90%+,电脑卡到飞起,定时程序虽然还在运行,但是已经类似于待机状态,是不是突然感觉到面对电脑卡死,第一反应:卧槽,这个lj电脑,怎么程序都跑不起来,我还写这么多代码,*****!!

是吧,接下来上代码,具体功能,请自行查阅相关资料深造:

from datetime import datetime

from threading import Timer

import time

# 定时任务

def task():

print(datetime.now().strftime("%Y-%m-%d %H:%M:%S"))

def timedTask():

'''

第一个参数: 延迟多长时间执行任务(秒)

第二个参数: 要执行的函数

第三个参数: 调用函数的参数(tuple)

'''

Timer(5, task, ()).start()

while True:

timedTask()

time.sleep(5)

7行代码,是不是很优雅?优不优雅的主要是代码少,不费劲对吧。

2020-06-05 14:06:39

2020-06-05 14:06:44

2020-06-05 14:06:49

2020-06-05 14:06:54

2020-06-05 14:06:59

2020-06-05 14:07:04

2020-06-05 14:07:09

2020-06-05 14:07:14

2020-06-05 14:07:19

2020-06-05 14:07:24

3. 方法三、sched模块

这次直接上模块——sched模块

代码如下:

from datetime import datetime

import sched

import time

def timedTask():

# 初始化 sched 模块的 scheduler 类,传入(time.time, time.sleep)这两个参数

schedscheduler = sched.scheduler(time.time, time.sleep)

# 增加调度任务,enter(睡眠时间,执行级别,执行函数)

scheduler.enter(5, 1, task)

# 运行任务

scheduler.run()

# 定时任务

def task():

print(datetime.now().strftime("%Y-%m-%d %H:%M:%S"))

if __name__ == '__main__':

timedTask()

这个模块也很容易上手,需要注意,scheduler()只会执行一次就结束程序,可以在mian下面添加while Ture或者直接添加调度任务在timeTask中就可以,另外除了这样的写法外,还有另外一种写法,上代码:

import schedule

import time

def hellow():

print('hellow')

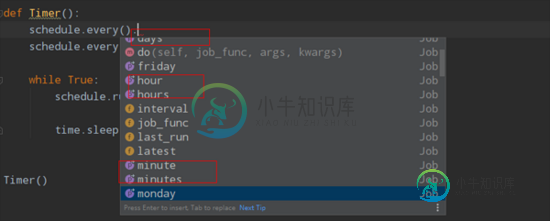

def Timer():

schedule.every().day.at("09:00").do(hellow)

schedule.every().day.at("18:00").do(hellow)

while True:

schedule.run_pending()

time.sleep('需要睡眠的周期')

Timer()

在这里可以看到,有day-hour-minute,定时任务非常的方便,在while True里添加需要睡眠的时间,在函数模块内添加需要执行的次数即可。

到此这篇关于Python爬虫定时计划任务的几种常见方法的文章就介绍到这了,更多相关Python爬虫定时计划任务内容请搜索小牛知识库以前的文章或继续浏览下面的相关文章希望大家以后多多支持小牛知识库!

-

本文向大家介绍Linux部署python爬虫脚本,并设置定时任务的方法,包括了Linux部署python爬虫脚本,并设置定时任务的方法的使用技巧和注意事项,需要的朋友参考一下 去年因项目需要,用python写了个爬虫。因爬到的数据需要存到生产环境的PG数据库。所以需要将脚本部署到CentOS服务器,并设置定时任务,自动启动脚本。 实施步骤如下: 1.安装pip(操作系统自带了python2.6可以

-

本文向大家介绍一文带你了解Python 四种常见基础爬虫方法介绍,包括了一文带你了解Python 四种常见基础爬虫方法介绍的使用技巧和注意事项,需要的朋友参考一下 一、Urllib方法 Urllib是python内置的HTTP请求库 二、requests方法 –Requests是用python语言基于urllib编写的,采用的是Apache2 Licensed开源协议的HTTP库 –urllib还

-

本文向大家介绍python 每天如何定时启动爬虫任务(实现方法分享),包括了python 每天如何定时启动爬虫任务(实现方法分享)的使用技巧和注意事项,需要的朋友参考一下 python2.7环境下运行 安装相关模块 想要每天定时启动,最好是把程序放在linux服务器上运行,毕竟linux可以不用关机,即定时任务一直存活; 以上这篇python 每天如何定时启动爬虫任务(实现方法分享)就是小编分享给

-

本文向大家介绍node实现爬虫的几种简易方式,包括了node实现爬虫的几种简易方式的使用技巧和注意事项,需要的朋友参考一下 说到爬虫大家可能会觉得很NB的东西,可以爬小电影,羞羞图,没错就是这样的。在node爬虫方面,我也是个新人,这篇文章主要是给大家分享几种实现node 爬虫的方式。第一种方式,采用node,js中的 superagent+request + cheerio。cheerio是必须

-

python应用最多的场景还是web快速开发、爬虫、自动化运维:写过简单网站、写过自动发帖脚本、写过收发邮件脚本、写过简单验证码识别脚本。 爬虫在开发过程中也有很多复用的过程,这里总结一下,以后也能省些事情。

-

本文向大家介绍python爬虫面试宝典(常见问题),包括了python爬虫面试宝典(常见问题)的使用技巧和注意事项,需要的朋友参考一下 是否了解线程的同步和异步? 线程同步:多个线程同时访问同一资源,等待资源访问结束,浪费时间,效率低 线程异步:在访问资源时在空闲等待时同时访问其他资源,实现多线程机制 是否了解网络的同步和异步? 同步:提交请求->等待服务器处理->处理完毕返回 这个期间客户端浏览