Docker实践—CentOS7上部署Kubernetes详解

Kubernetes架构

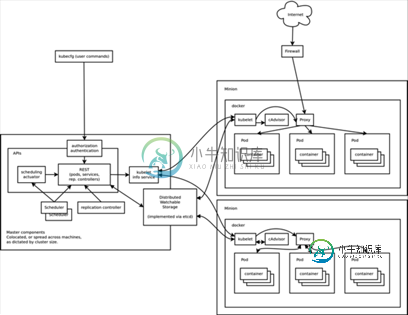

Kubernetes的整体架构如下:

Master为主控节点,上面运行apiserver,scheduler,controller-manager等组件。Minion相当于工作节点,上面运行kubelet,proxy,cAdvisor以及最重要的docker等组件。下面来实际部署一下这套集群管理工具。

环境

yy1 10.193.6.35

yy2 10.193.6.36

yy1作为master,yy2作为minion。

# cat /etc/centos-release

CentOS Linux release 7.0.1406 (Core)

安装kubernetes

# curl https://copr.fedoraproject.org/coprs/eparis/kubernetes-epel-7/repo/epel-7/eparis-kubernetes-epel-7-epel-7.repo -o /etc/yum.repos.d/eparis-kubernetes-epel-7-epel-7.repo # yum install kubernetes -y

配置yy1

# cat /etc/kubernetes/apiserver ### # kubernetes system config # # The following values are used to configure the kubernetes-apiserver # # The address on the local server to listen to. KUBE_API_ADDRESS="10.193.6.35" # The port on the local server to listen on. KUBE_API_PORT="8080" # How the replication controller and scheduler find the apiserver KUBE_MASTER="10.193.6.35:8080" # Comma seperated list of minions MINION_ADDRESSES="10.193.6.36" # Port minions listen on MINION_PORT="10250" # cat /etc/kubernetes/config ### # kubernetes system config # # The following values are used to configure various aspects of all # kubernetes services, including # # kubernetes-apiserver.service # kubernetes-controller-manager.service # kubernetes-kubelet.service # kubernetes-proxy.service # Comma seperated list of nodes in the etcd cluster KUBE_ETCD_SERVERS="http://10.193.6.35:4001" # logging to stderr means we get it in the systemd journal KUBE_LOGTOSTDERR="true" # journal message level, 0 is debug KUBE_LOG_LEVEL=0 # Should this cluster be allowed to run privleged docker containers KUBE_ALLOW_PRIV="true"

启动yy1上相关服务

master上需要运行etcd,kube-apiserver,kube-controller-manager,kube-scheduler这4个进程。

for SERVICES in etcd kube-apiserver kube-controller-manager kube-scheduler; do systemctl restart $SERVICES systemctl enable $SERVICES systemctl status $SERVICES done

配置yy2

# cat /etc/kubernetes/kubelet ### # kubernetes kublet (minion) config # The address for the info server to serve on MINION_ADDRESS="10.193.6.36" # The port for the info server to serve on MINION_PORT="10250" # You may leave this blank to use the actual hostname MINION_HOSTNAME="10.193.6.36" # cat /etc/kubernetes/config ### # kubernetes system config # # The following values are used to configure various aspects of all # kubernetes services, including # # kubernetes-apiserver.service # kubernetes-controller-manager.service # kubernetes-kubelet.service # kubernetes-proxy.service # Comma seperated list of nodes in the etcd cluster KUBE_ETCD_SERVERS="http://10.193.6.35:4001" # logging to stderr means we get it in the systemd journal KUBE_LOGTOSTDERR="true" # journal message level, 0 is debug KUBE_LOG_LEVEL=0 # Should this cluster be allowed to run privleged docker containers KUBE_ALLOW_PRIV="true"

修改yy2 kubelet的配置

CentOS7上没有docker.socket服务,注释掉kubelet中对docker.socket的依赖。

/usr/lib/systemd/system/kubelet.service

[Unit] Description=Kubernetes Kubelet #After=docker.socket cadvisor.service After=cadvisor.service #Requires=docker.socket cadvisor.service Requires=cadvisor.service

启动yy2上的相关服务

minion上需要运行kube-proxy,kubelet以及docker。

for SERVICES in kube-proxy kubelet docker; do systemctl restart $SERVICES systemctl enable $SERVICES systemctl status $SERVICES done

创建pod描述文件

创建一个apache的pod描述文件。

# cat apache.json

{

"id": "apache",

"desiredState": {

"manifest": {

"version": "v1beta1",

"id": "apache-1",

"containers": [{

"name": "master",

"image": "fedora/apache",

"ports": [{

"containerPort": 80,

"hostPort": 80

}]

}]

}

},

"labels": {

"name": "apache"

}

}

创建pod

通过html" target="_blank">客户端工具kubecfg提交任务给apiserver,由scheduler选择一个minion部署容。

[root@yy1 ~]# kubecfg -c apache.json create pods I0925 06:43:26.768122 09313 request.go:292] Waiting for completion of /operations/1 ID Image(s) Host Labels Status ---------- ---------- ---------- ---------- ---------- apache fedora/apache / name=apache Waiting [root@yy1 ~]# kubecfg list pods ID Image(s) Host Labels Status ---------- ---------- ---------- ---------- ---------- apache fedora/apache 10.193.6.36/ name=apache Waiting

apache服务会自动部署到机器yy2,yy2上的docker会自动下载image,然后启动apache服务。顺利的话,过一会儿,apache服务就会在yy2上起来。

[root@yy1 ~]# kubecfg list pods ID Image(s) Host Labels Status ---------- ---------- ---------- ---------- ---------- apache fedora/apache 10.193.6.36/ name=apache Running

可以尝试访问一下,

以上就是本文的全部内容,希望对大家的学习有所帮助,也希望大家多多支持小牛知识库。

-

本文向大家介绍详解Docker+Jenkins+Gitlab+Django应用部署实践,包括了详解Docker+Jenkins+Gitlab+Django应用部署实践的使用技巧和注意事项,需要的朋友参考一下 一、背景介绍 在互联网应用快速更新迭代的大背景下,传统的人工手动或简单脚本已经不能适应此变化,此时Devops为我们提供了良好的解决方案,应用好CI/CD可以大大的方便我们的日常工作,自动化快

-

本文向大家介绍Docker实践--部署Nodejs应用,包括了Docker实践--部署Nodejs应用的使用技巧和注意事项,需要的朋友参考一下 这个例子的目标是为了向大家展示如何在Docker的container里运行Node.js程序。我会先创建一个简单的Node.js web app,来构建一个镜像。然后基于这个Image运行一个container。从而实现快速部署。 由于网络的原因我的Nod

-

Puppet Chef Ansible

-

本文向大家介绍docker kubernetes dashboard安装部署详细介绍,包括了docker kubernetes dashboard安装部署详细介绍的使用技巧和注意事项,需要的朋友参考一下 docker之kubernetes dashboard部署 1. 环境说明: 1). 架构: 注: 本次实验服务器环境均采用centos 7. 服务安装均采用yum install. 192.16

-

本文介绍了小米公司部署Open-Falcon的一些实践经验,同时试图以量化的方式分析Open-Falcon各组件的特性。 概述 Open-Falcon组件,包括基础组件、作图链路、报警链路。小米公司部署Open-Falcon的架构,如下: 其中,基础组件以绿色标注圈住、作图链路以蓝色圈住、报警链路以红色圈住,橙色填充的组件为域名。每个模块(子服务)都有自己的特性,根据其特性来制定部署策略。接下来,

-

本文介绍了小米公司部署Open-Falcon的一些实践经验,同时试图以量化的方式分析Open-Falcon各组件的特性。 概述 Open-Falcon组件,包括基础组件、作图链路、报警链路。小米公司部署Open-Falcon的架构,如下: 其中,基础组件以绿色标注圈住、作图链路以蓝色圈住、报警链路以红色圈住,橙色填充的组件为域名。每个模块(子服务)都有自己的特性,根据其特性来制定部署策略。接下来,