windows 32位eclipse远程hadoop开发环境搭建

本文假设hadoop环境在远程机器(如linux服务器上),hadoop版本为2.5.2

注:本文eclipse/intellij idea 远程调试hadoop 2.6.0主要参考了并在其基础上有所调整

由于我喜欢在win7 64位上安装32位的软件,比如32位jdk,32位eclipse,所以虽然本文中的操作系统是win7 64位,但是所有的软件都是32位的。

软件版本:

操作系统:win7 64位

eclipse: eclipse-jee-mars-2-win32

java: 1.8.0_77 32位

hadoop:2.5.2

一、安装hadoop

1、在win7中随便找一个目录解压hadoop-2.5.2.tar.gz,比如D:\app\hadoop-2.5.2\

2、配置环境变量

HADOOP_HOME = D:\app\hadoop-2.5.2\

二、安装hadoop eclipse插件

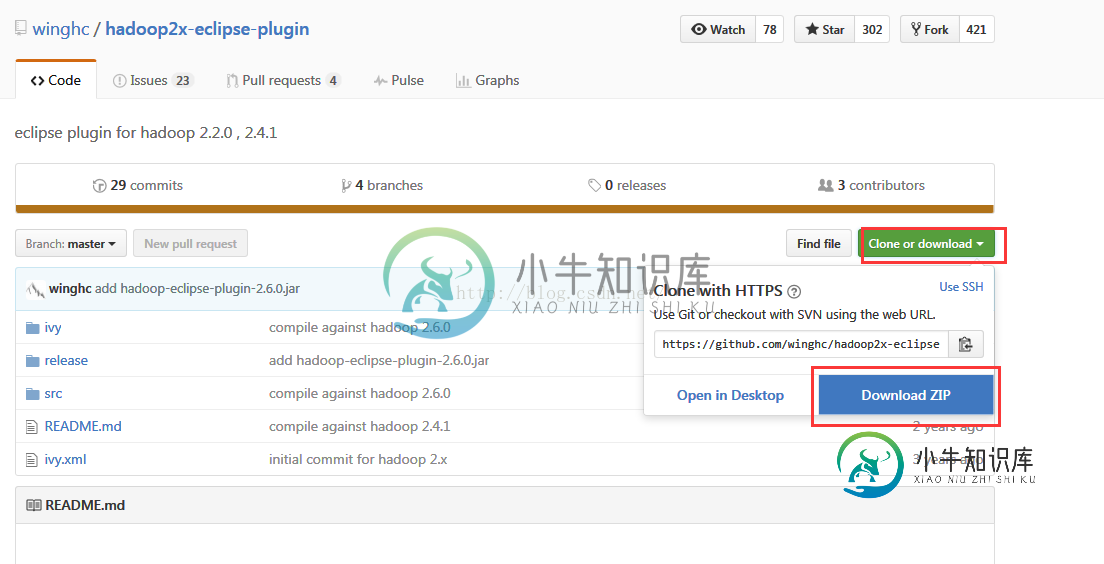

1、下载hadoop-eclipse-plugin

hadoop-eclipse-plugin是一个专门用于eclipse的hadoop插件,可以直接在IDE环境中查看hdfs的目录和文件内容。其源代码托管于github上,官网地址是https://github.com/winghc/hadoop2x-eclipse-plugin 下载release文件夹中的hadoop-eclipse-plugin-2.6.0.jar即可

2、下载windows 32位平台的hadoop插件包(hadoop.dll,winutils.exe)

由于我们的软件环境是32位的,所以需要下载32位的hadoop.dll和winutils.exe,下载地址大家可以百度 hadoop.dll 32

比如下载这个:http://xiazai.jb51.net/201607/yuanma/eclipse-hadoop(jb51.net).rar

将winutils.exe复制到$HADOOP_HOME\bin目录,将hadoop.dll复制到C:\Windows\SysWOW64目录下(注:由于我们的操作系统是64位,而软件是32位,所以我们是拷到这个目录下,另外,如果你的操作系统就是32位,那么就直接拷到c:\windwos\system32目录下)

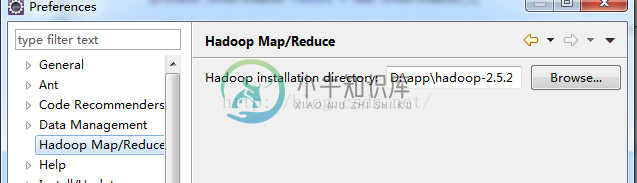

3、配置hadoop-eclipse-plugin插件

启动eclipse,window->preferences->hadoop map/reduce 指定win7上的hadoop根目录(即:$HADOOP_HOME)

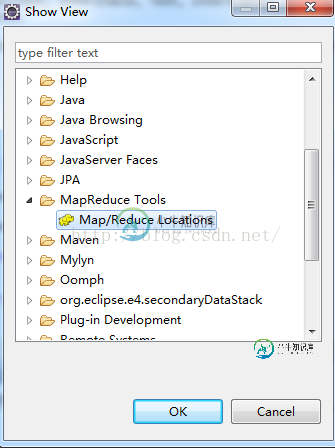

切换Map/reduce视图

windows->show view->other Map/Reduce Locations

然后在下面的Map/Reduce Locations 面板中添加新的Location

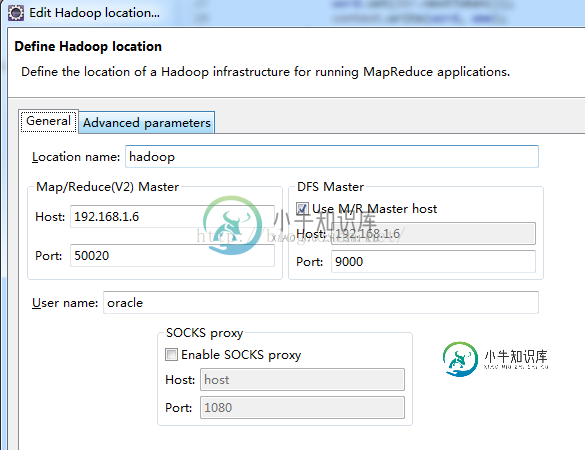

按照如下配置

Location name 这里就是起个名字,随便起

Map/Reduce(V2) Master Host 这里就是虚拟机里hadoop master对应的IP地址,下面的端口对应 hdfs-site.xml里dfs.datanode.ipc.address属性所指定的端口

DFS Master Port这里的端口,对应core-site.xml里fs.defaultFS所指定的端口

最后的user name要跟虚拟机里运行hadoop的用户名一致,我是用hadoop身份安装运行hadoop 2.6.0的,所以这里填写hadoop,如果你是用root安装的,相应的改成root

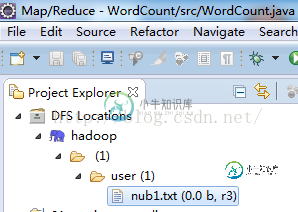

这些参数指定好以后,点击Finish,eclipse就知道如何去连接hadoop了,一切顺利的话,在Project Explorer面板中,就能看到hdfs里的目录和文件了

可以在文件上右击,选择删除试下,通常第一次是不成功的,会提示一堆东西,大意是权限不足之类,原因是当前的win7登录用户不是虚拟机里hadoop的运行用户,解决办法有很多,比如你可以在win7上新建一个hadoop的管理员用户,然后切换成hadoop登录win7,再使用eclipse开发,但是这样太烦,最简单的办法:

hdfs-site.xml里添加

<property> <name>dfs.permissions.enabled</name> <value>false</value> </property>

总而言之,就是彻底把hadoop的安全检测关掉(学习阶段不需要这些,正式生产上时,不要这么干),最后重启hadoop,再到eclipse里,重复刚才的删除文件操作试下,应该可以了。

注:如果无法连接,请先尝试telnet 192.168.1.6 9000 (请将ip和端口换成自己的hadoop server ip和端口)确保端口可以访问。

如果telnet不成功,可能是core-site.xml里fs.defaultFS的值有问题,比如配置的是localhost:9000,可以考虑把localhost换成主机名

三、编写wordcount示例

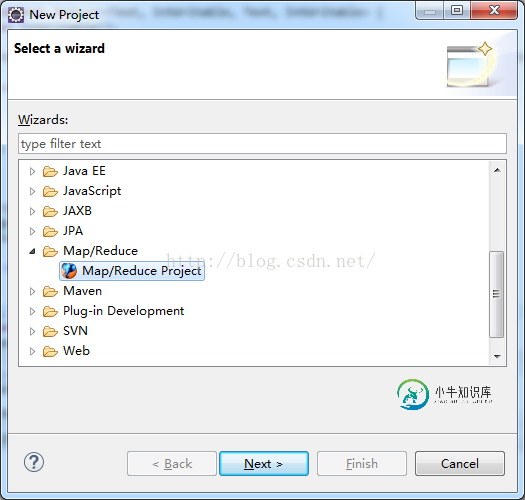

1、新建一个项目,选择Map/Reduce Project

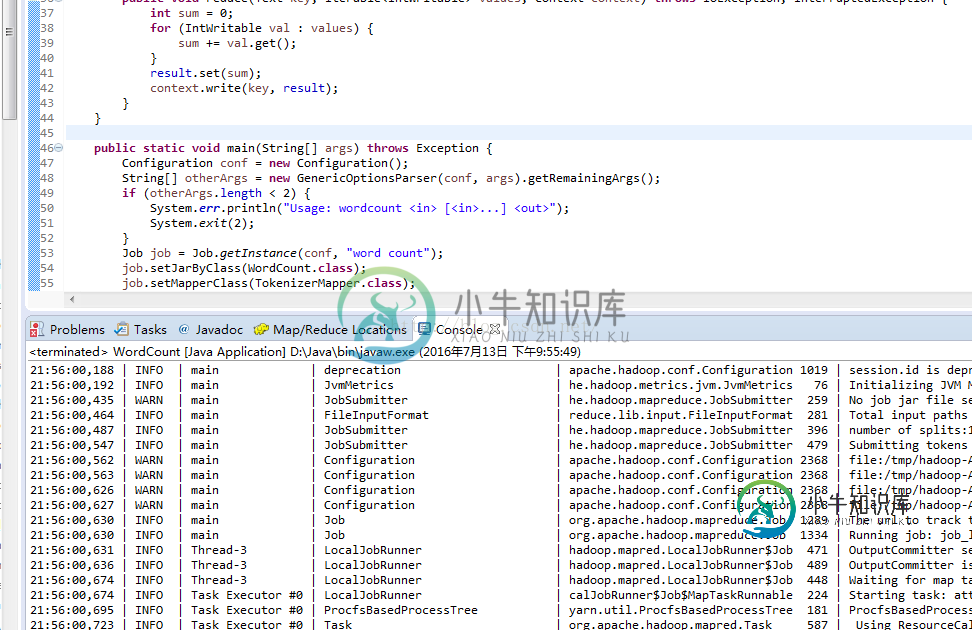

后面的Next就行了,然后新建一个类WodCount.java 代码如下:

import java.io.IOException; import java.util.StringTokenizer; import org.apache.hadoop.conf.Configuration; import org.apache.hadoop.fs.Path; import org.apache.hadoop.io.IntWritable; import org.apache.hadoop.io.Text; import org.apache.hadoop.mapreduce.Job; import org.apache.hadoop.mapreduce.Mapper; import org.apache.hadoop.mapreduce.Reducer; import org.apache.hadoop.mapreduce.lib.input.FileInputFormat; import org.apache.hadoop.mapreduce.lib.output.FileOutputFormat; import org.apache.hadoop.util.GenericOptionsParser; public class WordCount { public static class TokenizerMapper extends Mapper<Object, Text, Text, IntWritable> { private final static IntWritable one = new IntWritable(1); private Text word = new Text(); public void map(Object key, Text value, Context context) throws IOException, InterruptedException { StringTokenizer itr = new StringTokenizer(value.toString()); while (itr.hasMoreTokens()) { word.set(itr.nextToken()); context.write(word, one); } } } public static class IntSumReducer extends Reducer<Text, IntWritable, Text, IntWritable> { private IntWritable result = new IntWritable(); public void reduce(Text key, Iterable<IntWritable> values, Context context) throws IOException, InterruptedException { int sum = 0; for (IntWritable val : values) { sum += val.get(); } result.set(sum); context.write(key, result); } } public static void main(String[] args) throws Exception { Configuration conf = new Configuration(); String[] otherArgs = new GenericOptionsParser(conf, args).getRemainingArgs(); if (otherArgs.length < 2) { System.err.println("Usage: wordcount <in> [<in>...] <out>"); System.exit(2); } Job job = Job.getInstance(conf, "word count"); job.setJarByClass(WordCount.class); job.setMapperClass(TokenizerMapper.class); job.setCombinerClass(IntSumReducer.class); job.setReducerClass(IntSumReducer.class); job.setOutputKeyClass(Text.class); job.setOutputValueClass(IntWritable.class); for (int i = 0; i < otherArgs.length - 1; ++i) { FileInputFormat.addInputPath(job, new Path(otherArgs[i])); } FileOutputFormat.setOutputPath(job, new Path(otherArgs[otherArgs.length - 1])); System.exit(job.waitForCompletion(true) ? 0 : 1); } }

然后再src目录下创建一个log4j.properties,内容如下:(为了方便运行起来后,查看各种输出)

log4j.rootLogger=INFO, stdout

#log4j.logger.org.springframework=INFO

#log4j.logger.org.apache.activemq=INFO

#log4j.logger.org.apache.activemq.spring=WARN

#log4j.logger.org.apache.activemq.store.journal=INFO

#log4j.logger.org.activeio.journal=INFO

log4j.appender.stdout=org.apache.log4j.ConsoleAppender

log4j.appender.stdout.layout=org.apache.log4j.PatternLayout

log4j.appender.stdout.layout.ConversionPattern=%d{ABSOLUTE} | %-5.5p | %-16.16t | %-32.32c{1} | %-32.32C %4L | %m%n

最终目录结构如下:

2、配置运行参数

因为WordCount是输入一个文件用于统计单词字,然后输出到另一个文件夹下,所以给二个参数,参考上图,在Program arguments里,输入

hdfs://192.168.1.6:9000/user/nub1.txt

hdfs://192.168.1.6:9000/user/output

注意的是,如果user/nub1.txt文件没有,请先手动上传(使用eclipse中DFS Location工具的右键),然后/output/ 必须是不存在的,否则程序运行到最后,发现目标目录存在,也会报错。

好了,运行即可

以上就是本文的全部内容,希望对大家的学习有所帮助,也希望大家多多支持小牛知识库。

-

本文向大家介绍使用Maven搭建Hadoop开发环境,包括了使用Maven搭建Hadoop开发环境的使用技巧和注意事项,需要的朋友参考一下 关于Maven的使用就不再啰嗦了,网上很多,并且这么多年变化也不大,这里仅介绍怎么搭建Hadoop的开发环境。 1. 首先创建工程 2. 然后在pom.xml文件里添加hadoop的依赖包hadoop-common, hadoop-client, hadoop

-

依照以下操作,你可使用Docker在Mac,Linux上搭建PPMessage开发环境。 前言:Docker 的作用 ? Docker allows you to package an application with all of its dependencies into a standardized unit for software development. Docker containe

-

本文向大家介绍Eclipse中Python开发环境搭建简单教程,包括了Eclipse中Python开发环境搭建简单教程的使用技巧和注意事项,需要的朋友参考一下 一、背景介绍 Eclipse是一款基于Java的可扩展开发平台。其官方下载中包括J2EE方向版本、Java方向版本、C/C++方向版本、移动应用方向版本等诸多版本。除此之外,Eclipse还可以通过安装插件的方式进行诸如Python、A

-

要开发kibana 插件,首先要在本地搭建开发环境,我这里推荐使用vs code,如果问我为什么,我只想说这么火的开发工具,不用一下,怎么跟上世界开发潮流呢。 第一步 首先 需要安装node.js,可以去官网下载最新版本,对于如何安装就不废话了。 第二步 下载 kibana 源代码,在github下载即可。 第三步 在kibana项目根目录下执行 1. $ git tag 2. $ git che

-

简单起见,一开始的服务器只会是一个工程,构建会也只是一个jar包。 开发环境就用最流行的java8、maven3,IDE可以随自己喜好。 新建maven工程,如下: POM文件如下: <?xml version="1.0" encoding="UTF-8"?> <project xmlns="http://maven.apache.org/POM/4.0.0" xmlns:xsi

-

我们将在Mac上使用docker环境编译kuberentes。 安装依赖 brew install gnu-tar Docker环境,至少需要给容器分配4G内存,在低于3G内存的时候可能会编译失败。 执行编译 切换目录到kuberentes源码的根目录下执行: ./build/run.sh make可以在docker中执行跨平台编译出二进制文件。 需要用的的docker镜像: gcr.io/goo