《同花顺》专题

-

Jaxb解组(不同的包装元素具有相同的元素)

我有下面的xml结构: 有不同的 Field(X) 包装器元素,它们包含相同的用户元素。XML 中可以发送 n 个字段。因此,我不能为每个单独的Jaxb。我需要访问用户,但在取消编组步骤后忽略 Field 元素。不幸的是,我无权更改xml结构。我无法找到解决方案。任何指针都会有所帮助。

-

IE 11向不同的子域发送不同的User-Agent标头

嗯,我一直在研究基于用户代理的子域间共享会话保护。 我非常惊讶,在IE 11预览版最近发布之前,它一直运行良好。有 2 个子域 example.com和sub.example.com 我已经拦截了对两个域的请求,似乎发送到每个域的用户代理HTTP标头是不同的。 example.com请求有: 用户代理: Mozilla/5.0 (视窗 NT 6.1;哇64;三叉戟/7.0;rv:11.0) 像壁虎

-

基于工作者、核和数据流大小确定最佳火花分区数

Spark-land中有几个类似但不同的概念,围绕着如何将工作分配到不同的节点并并发执行。具体有: Spark驱动程序节点() Spark群集可用的辅助节点数() Spark executors的数量() 所有工作人员/执行人员同时操作的DataFrame() ()中的行数 () ,最后是每个工作节点上可用的CPU核数() 我相信所有的Spark集群都只有一个Spark驱动程序,然后是0+个工作节

-

我如何选择一个元素的属性有特殊的花括号[重复]

我有一个html按钮,如下所示。它将有一个属性 单击此按钮时,我需要获取该属性,并为另一个具有不同类和相同属性的元素创建一个属性选择器 我尝试了jquery属性选择器,但这不起作用 我可以使用JS或jQuery修复程序

-

查找信号到达字符串中所有位置所花费的时间-C ++

本文向大家介绍查找信号到达字符串中所有位置所花费的时间-C ++,包括了查找信号到达字符串中所有位置所花费的时间-C ++的使用技巧和注意事项,需要的朋友参考一下 在本教程中,我们将编写一个程序来计算信号到达字符串中所有位置所花费的时间。让我用一个例子来解释它。 我们将有一个仅包含s和p字符的字符串。s是信号,p是字符串中的位置。信号从s开始,沿左右两个方向传播。我们假设要花费一个单位时间才能到达

-

非常漂亮的新年祝福!C语言实现漂亮的烟花效果

本文向大家介绍非常漂亮的新年祝福!C语言实现漂亮的烟花效果,包括了非常漂亮的新年祝福!C语言实现漂亮的烟花效果的使用技巧和注意事项,需要的朋友参考一下 本文实例为大家分享了C语言实现漂亮的烟花效果展示的具体代码,供大家参考,具体内容如下 程序名称:祝福烟花,祝福朋友 编译环境:VC++6.0 && easyx(立冬版) 以上就是本文的全部内容,希望对大家的学习有所帮助,也希望大家多多支持呐喊教程

-

钻孔器无法读取Spark生成的拼花地板中的大多数列

我在分布式模式下仅在数据极顶部运行Drill 1.15(3个节点,每个节点有32GB内存)。我正在尝试读取HDF中Spark作业生成的拼花文件。 生成的文件正在spark中读取,很好,但在Drill中读取时,除了少数列之外,它似乎对其他列不起作用。 组织。阿帕奇。训练常见的例外。UserRemoteException:数据读取错误:从磁盘读取时发生异常。文件:[文件名]。拼花地板列:行组开始:11

-

spark sql:读取拼花地板分区文件时超出了GC开销限制

我尝试从hdfs读取现有的拼花文件使用火花sql为我的POC,但击中OOM错误。 我需要读取给定分区日期的所有分区文件。分区如下:日期/file_dir_id 日期文件夹下有1200个子文件夹 拼花文件夹结构 日期: 文件\u dir\u 1 文件\u 1。拼花地板 文件2。拼花地板 文件\u 3。拼花地板 文件\u 3。拼花地板 当我尝试读取特定日期的文件时,上面提到的数字会引发ession.r

-

在Flink中进行检查点时,定时器太多花费了太多时间

任何解决这一问题的建议都将不胜感激。或者我们可以用另一种方式来计数?我想补充一些细节。滑动大小是一个事件和窗口大小超过10小时(每秒大约有300个事件),我们需要对每个事件做出反应。所以在这种情况下,我们没有使用Flink提供的窗口。我们使用来存储前面的信息。在中用于触发旧数据的清理作业。最后dinstinct键的数量非常多。

-

Windows群集上的火花程序失败,错误CreateProcess error=5,访问被拒绝

我试图在我的Windows10笔记本电脑上的Spark V2.0.0集群上执行一个程序。端口31080上有一个主节点,端口32080上有一个从节点。集群使用独立管理器,并使用JDK1.8,从服务器有一个自定义工作目录。 当通过spark-submit或Eclipse>Run程序提交程序时,我会得到以下错误,执行器进入一个循环(创建了一个新的执行器,并且连续失败)。请引导。 请求删除执行人0

-

为什么一个Kafka的消费者要花很长时间才开始消费?

我们启动一个Kafka消费者,监听一个可能还没有创建的主题(不过,主题自动创建是启用的)。 此后不久,一位制作人发表了关于这个话题的消息。 Kafka原木

-

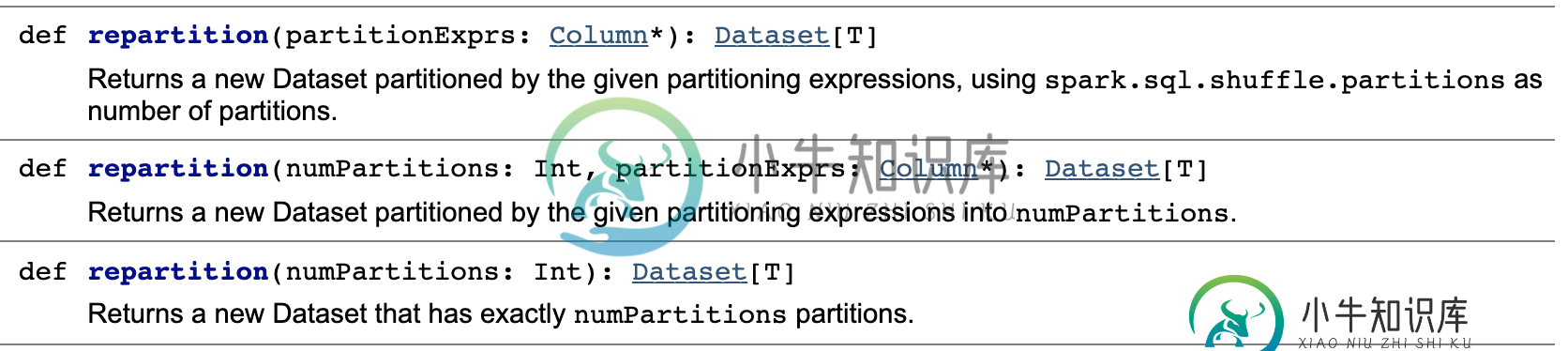

按列进行火花重新分区,每个列的分区数是动态的

按列进行火花重新分区,每个列的分区数是动态的如何根据列中项数的计数来分区DataFrame。假设我们有一个包含100人的DataFrame(列是和),我们希望为一个国家中的每10个人创建一个分区。 如果我们的数据集包含来自中国的80人,来自法国的15人,来自古巴的5人,那么我们需要8个分区用于中国,2个分区用于法国,1个分区用于古巴。 下面是无法工作的代码: null 有什么方法可以动态设置每个列的分区数吗?这将使创建分区数据集变得更加容易

-

获得空指针异常时,试图添加一列火花数据集在Java

我试图在java中迭代数据集行,然后访问特定的列,找到它作为键存储在JSON文件中的值,并获取它的值。对于所有行,找到的值需要作为新列值存储在该行中。 我看到我从JSON文件中获得的不是空的,但当我尝试将其添加为列时,我在线程“main”组织中得到了 到目前为止,我有: 因此,我主要需要帮助逐行读取数据集,并执行上述后续操作。无法在网上找到太多参考资料。如果可能的话,请告诉我正确的来源。另外,如果

-

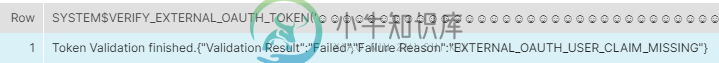

无法使用OAuth令牌从数据块" EXTERNAL _ OAuth _ USER _ CLAIM _ MISSING "连接到雪花

无法使用OAuth令牌从数据块" EXTERNAL _ OAuth _ USER _ CLAIM _ MISSING "连接到雪花我正在尝试使用 OAuth 令牌从 Databricks 连接到 Snowflake。 我已经配置使用官方留档(https://docs.snowflake.com/en/user-guide/oauth-azure.html#step-3-collect-azure-ad-information-for-snowflake)。 请求令牌时,我还会检索看似有效的令牌。格式为 {'token_typ

-

分析火花执行器内存转储{几天后,纱容器内存耗尽}

我正在开发 spark 1.3,我的应用程序是一个 spark 流应用程序。我使用纱线作为资源经理。我的应用程序运行正常几天,然后 spark 作业定期丢失执行程序。当我查看node_manager日志时,我发现了一个异常: 我对这一例外的问题如下: > 我知道11G会运行执行程序的内存。但是我在spark-defaults.conf.中将10G设置为执行程序内存。那么11G是如何分配给执行程序的