《wget》专题

-

如何使用wget从Sonatype Nexus下载工件

编辑:我可以使用我的浏览器下载工件(并登录到webinterface)

-

使用Browser/wget从Nexus OSS 3.0.0-03下载工件

我在本地安装了Nexus OSS 3.0.0-03。 我能够上传快照和释放罐子。 现在我想通过浏览器或wget下载这些JAR,但我似乎找不到REST API调用来完成这一任务(例如,在Jenkins执行的shell脚本中)。 在版本3之前,似乎可以使用以下内容:http://my_repository/nexus/service/local/artifact/maven/content?r=rep

-

如何通过curl或wget下载Google Drive url

有没有一种方法可以通过curl或wget下载一个可公开查看的Google Drive url?例如,能够做类似的事情: 注意,我希望在一个可公开查看的文件上这样做,而不需要登录到我的Google帐户(或者让其他人登录到他们的帐户,等等)。 如果有帮助,我有的cors头是:

-

使用curl和wget返回不同的文件格式

这两个命令中的任何一个都应该生成一个json文件,但实际上我得到的是一个html文件。

-

如何在Linux中使用wget-i命令为正在下载的多个文件指定文件名?

我们可以使用下载多个链接,其中是包含我们必须下载的所有URL的文件。 我在一个文件中有3个URL,例如: 我使用请求这些URL。但是,我们如何指定文件名来存储结果呢?

-

在google驱动器文件上使用Wget

文件大小为13 GB tar。日志文件如下所示:

-

wget不能用于Google drive中的共享文件

我试图使用命令从Google drive下载一个文件,但它不起作用。 该文件在web上是公开的,任何人都可以通过提供的链接直接下载。那么,为什么它不能与wget一起工作呢?

-

使用wget从google drive下载文件

是否可以一个google驱动器文件?如果是,提供的路径是什么?如果没有,是否有其他选择(bash或其他),这样我就可以避免将文件下载到我的本地并将其传输到远程?

-

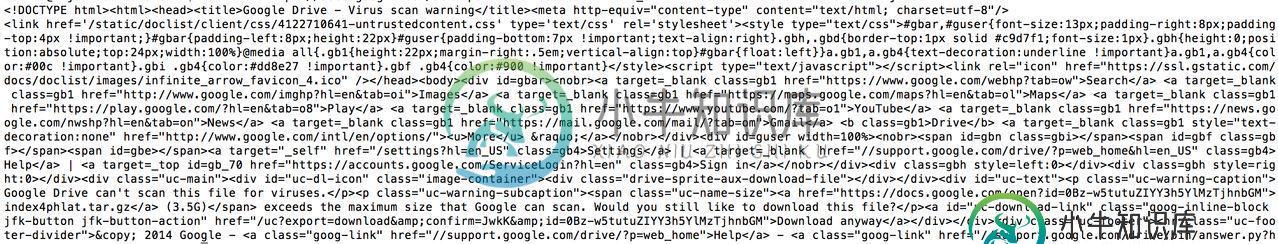

wget/curl来自google drive的大文件

wget/curl来自google drive的大文件我正在尝试用脚本从google drive下载一个文件,我在这样做时遇到了一点麻烦。我要下载的文件在这里。 我在网上找了很多,最后终于找到了一个下载。我获得了文件的UID,较小的文件(1.6MB)下载良好,但较大的文件(3.7GB)总是重定向到一个页面,该页面询问我是否要继续下载而不进行病毒扫描。谁能帮我通过那个屏幕吗? 这是我如何处理第一份文件的- 当我在另一个文件上运行相同的操作时, 我注意到

-

17. wget 文件下载

Linux系统中的wget是一个下载文件的工具,它用在命令行下。对于Linux用户是必不可少的工具,我们经常要下载一些软件或从远程服务器恢复备份到本地服务器。wget支持HTTP,HTTPS和FTP协议,可以使用HTTP代理。 wget 可以跟踪HTML页面上的链接依次下载来创建远程服务器的本地版本,完全重建原始站点的目录结构。这又常被称作”递归下载”。在递归下载的时候,wget 遵循Robot

-

GNU Wget

wget是一个从网络上自动下载文件的自由工具。它支持HTTP,HTTPS和FTP协议,可以使用HTTP代理. 所谓的自动下载是指,wget可以在用户退出系统的之后在后台执行。这意味这你可以登录系统,启动一个wget下载任务,然后退出系统,wget将在后台执行直到任务完成,相对于其它大部分浏览器在下载大量数据时需要用户一直的参与,这省去了极大的麻烦。 wget 可以跟踪HTML页面上的链接依次下载来

-

python - 为什么微博的图片用 wget 的 UA 可以下载,但是用浏览器的 UA 却无法下载?

python - 为什么微博的图片用 wget 的 UA 可以下载,但是用浏览器的 UA 却无法下载?测试的图片地址来自: https://weibo.com/3209519182/OixHyvyva 下面的代码无法下载图片 会报错 但是下面的代码可以下载图片(只修改了 User-Agent 为 wget ) 输出如下