《分类》专题

-

拆分用于分类问题的数据集的正确程序是什么?

问题内容: 我是机器学习和深度学习的新手。我想澄清我与训练之前有关的疑问 我有一个size的数据集,其中, 属于 属于 我想使用LSTM执行分类(因为序列数据) 由于各类没有相等的分布集,我如何拆分我的数据集进行训练? 选项1 :考虑整个数据,对其进行洗牌,train_test_split,然后进行培训。 选项2: 均等地分割两个班级数据集 ,对其进行洗牌,train_test_split,然后进

-

为什么在类定义的末尾不需要分号但允许分号?

问题内容: 我正在尝试从C ++转向Java。 我想知道的是,在C ++中,在类定义之后,需要使用分号(),而在Java中则不需要。 也就是说,在C ++中: 但是在Java中: 很好,我知道。 但是, 我的问题是 : 当我在类定义的末尾添加分号时,Java也可以使用,例如: 我已经编译并执行了Java所示的两个程序片段,并且它们均有效。谁能解释为什么会这样?Java类定义末尾的分号代表什么? 很

-

问题:如果给你一些数据集,你会如何分类(我是分情况答的,从数据的大小,特征,是否有缺失,分情况分别答的);

本文向大家介绍问题:如果给你一些数据集,你会如何分类(我是分情况答的,从数据的大小,特征,是否有缺失,分情况分别答的);相关面试题,主要包含被问及问题:如果给你一些数据集,你会如何分类(我是分情况答的,从数据的大小,特征,是否有缺失,分情况分别答的);时的应答技巧和注意事项,需要的朋友参考一下 参考回答: 根据数据类型选择不同的模型,如Lr或者SVM,决策树。假如特征维数较多,可以选择SVM模型,

-

在Python中将以分号分隔的字符串拆分为字典

问题内容: 我有一个看起来像这样的字符串: Python中是否有内置类/函数将采用该字符串并构造一个字典,就像我已经做到了那样: 我浏览了可用的模块,但似乎找不到任何匹配的模块。 谢谢,我确实知道如何自己编写相关代码,但是由于此类较小的解决方案通常是等待发生的雷区(即有人写道:Name1 =’Value1 = 2’;)等,因此我通常更喜欢使用测试功能。 那我自己去做 问题答案: 没有内置功能,但是

-

.NET Core实现分表分库、读写分离的通用 Repository功能

本文向大家介绍.NET Core实现分表分库、读写分离的通用 Repository功能,包括了.NET Core实现分表分库、读写分离的通用 Repository功能的使用技巧和注意事项,需要的朋友参考一下 首先声明这篇文章不是标题党,我说的这个类库是 FreeSql.Repository,它作为扩展库现实了通用仓储层功能,接口规范参考 abp vnext 定义,实现了基础的仓储层(CURD)。

-

使用由分隔符Java分隔的位置值拆分字符串

我有一个输入字符串,其中包含由分隔符(| |)分隔的4个ID。我使用的代码如下: 但有些情况下并非所有ID都存在,如: 在上面的场景中,拆分不会分为4个部分,并且无法判断拆分数组中缺少哪个id。 有人可以帮助一个有效的解决方案。

-

Spark分区:创建RDD分区,但不创建配置单元分区

这是将Spark dataframe保存为Hive中的动态分区表的后续操作。我试图在答案中使用建议,但无法在Spark 1.6.1中使用 任何推动这一进程的帮助都是感激的。 编辑:还创建了SPARK-14927

-

HTTP分段和分块可以共存吗?

问题内容: 我使用Apache 来 发布 多个文件服务器。这是代码: 问题是,类仅具有方法(始终返回false),如果我希望为我的多部分实体启用已阻止的编码,则没有“ setChunked(boolean)”选项。 我的问题是: HTTP多部分和块可以根据协议规范共存吗?如果不是,为什么其他类(如class)在哪里没有呢? 有没有什么方法可以启用分块功能一次发布多个文件,最好是使用apache库?

-

TeamCity推送功能分支到主分支

问题内容: 有什么方法可以将成功构建的功能分支推送到另一个分支? 我想要这样的东西: Git存储库(Gitorious / GitHub等)。分行: 掌握(当前项目的代码) 质量保证(代码等待质量检查的分支机构) 功能分支(许多远程分支,开发人员可以在其中开发其功能) 开发人员应仅具有对母版的读取访问权限,并且对其功能分支进行读/写QA读/写质量保证分支TeamCity-读/写母版,质量保证,仅对

-

C#二分查找算法实例分析

本文向大家介绍C#二分查找算法实例分析,包括了C#二分查找算法实例分析的使用技巧和注意事项,需要的朋友参考一下 本文实例讲述了C#二分查找算法。分享给大家供大家参考。具体实现方法如下: 希望本文所述对大家的C#程序设计有所帮助。

-

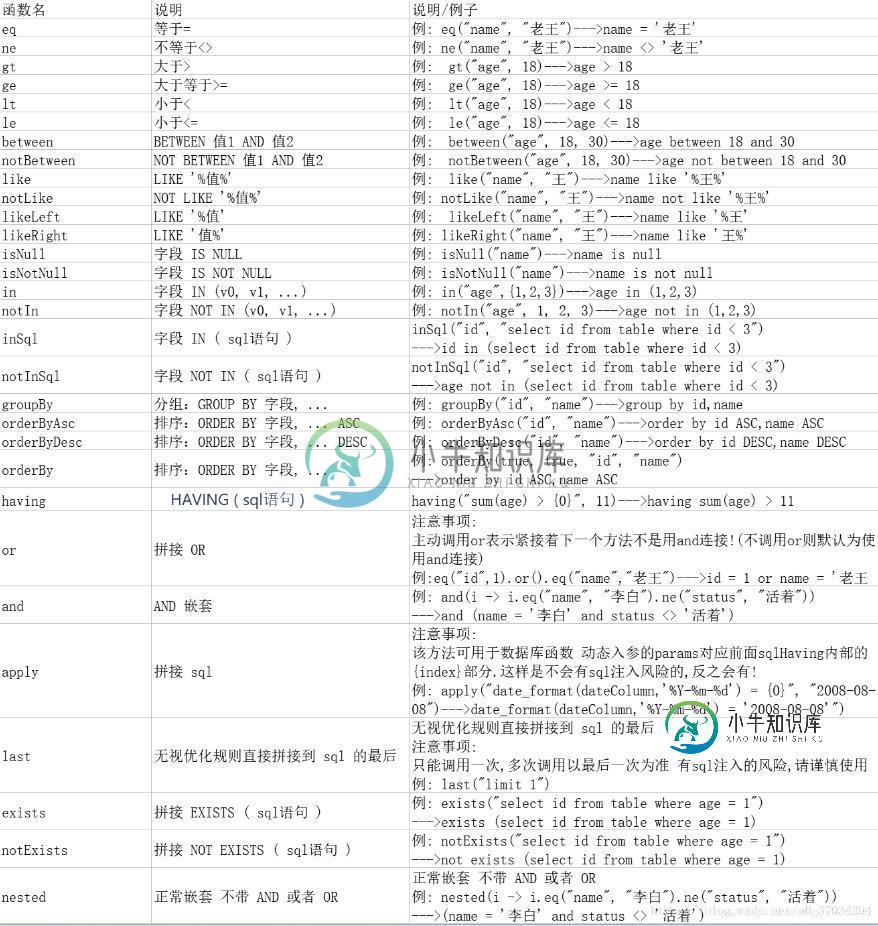

MybatisPlus,无XML分分钟实现CRUD操作

MybatisPlus,无XML分分钟实现CRUD操作本文向大家介绍MybatisPlus,无XML分分钟实现CRUD操作,包括了MybatisPlus,无XML分分钟实现CRUD操作的使用技巧和注意事项,需要的朋友参考一下 不讲太多理论知识,官网都有,直接上手。 1.测试表 引入依赖 配置文件,这里我用的是boot项目 其实简单的crud甚至不需要mybatis-plus的配置,我这里没删除,本文也并没有用到配置文件。 实体类 分页插件 编写一个我

-

elasticsearch-如何处理未分配的分片

问题内容: 我的集群处于黄色状态,因为未分配某些分片。怎么办呢? 我尝试设置所有索引,但是我认为这不起作用,因为我使用的是1.1.1版本。 我也尝试过重新启动所有机器,但同样发生。 任何想法? 编辑: 群集统计信息: 问题答案: 这些未分配的分片实际上是主节点上实际分片的未分配副本。 为了分配这些分片,您需要运行一个新的elasticsearch实例来创建一个辅助节点来承载数据副本。 编辑: 有时

-

Kafka 流 1.0 将分区分配给线程

我使用的是Kafka流,具有无状态的简单处理器拓扑结构。 我有一个主题,有100个分区,有2台机器,每台机器有50个线程,运行同一个流媒体应用程序,因此最终我将在它们之间进行1-1映射。 主题中的消息已是键控消息。 我有一个逻辑约束,一旦线程连接到一个或多个分区,它应该继续处理这些分区(当然,直到重新启动发生,它会重新洗牌) 我从日志中看到线程反复(重新)加入消费者组。 我的问题,kafka 流

-

.eh_frame和.eh_frame_hdr部分分别存储什么?

问题内容: 我知道,当使用支持异常的语言(例如C ++)时,必须向运行时环境提供其他信息,以描述在处理异常期间必须解开的调用框架。此信息包含在目标文件的特殊部分中,例如和。 但是,这些部分中存储了什么样的数据结构?我的意思是,可以使用任何C结构读取它们吗?难道他们有什么做的语句(如,,,,和在GNU汇编代码)?如果它们这样做,那么这些子句中的每一个在这些部分中引起什么?本节与该节有什么关系? 我希

-

【分享】一部分Android面试题总结~

【分享】一部分Android面试题总结~箩筐技术 1.JNI的理解 2.JVM的理解 3.JAVA线程的理解 4.线程安全的理解 5.volitile的理解 6.volitile修饰对象的问题 7.对Android系统源码的理解 8.Android事件传递机制 9.android ViewRoot 10.四大组件的使用场景 11.广播和服务的区别 博学明辨 1.组件间通信方式 2.约束布局原理 3.Handler执行流程原理 4.Mes