《大数据分析》专题

-

PHP cURL提交POST数据,多部分/表单数据混乱

所以我有一个网站,我正在建设,它将使用数据库中的数据来填写不同网站上的表格。现在我明白了,这可以很容易地用cURL或python来完成,但是,当我截取和读取post数据时,通常会非常混乱。例如,在此表单中,只有注释和分级选项,但包含所有类型的其他垃圾:

-

冷热数据拆分,平滑数据迁移要怎么做?

现在系统里面积累了大约五六年的缴费数据。 希望分离出一个冷数据库,用来保存2年以前的数据。 而主库只保存2年以内的热数据。 这个过程中,怎么保证服务不停机,实现平滑迁移呢? 怎么实现迁移完成后的数据,对于用户查询热数据、冷数据是透明无感的?

-

如何将大熊猫的每月数据转换为季度数据

问题内容: 我有月度数据。我想将其转换为1月份从1月份开始的3个月的“期间”。因此,在下面的示例中,前三个月的汇总将转换为q2的开始(所需格式:1996q2)。而将三个月度值汇总在一起而得出的数据值是三列的平均值。从概念上讲,并不复杂。有谁知道如何一口气做到这一点?潜在地,我可以通过循环来做很多艰苦的工作,并从中进行硬编码,但是我是熊猫的新手,正在寻找比暴力更聪明的东西。 所以我在寻找: 问题答案

-

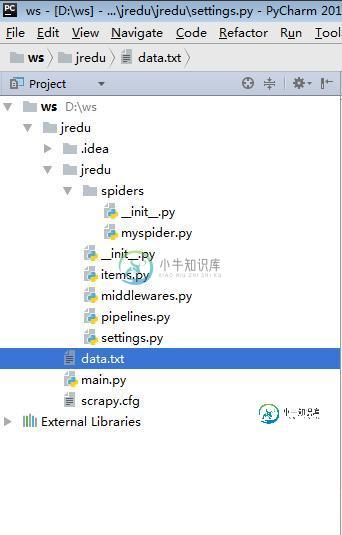

Python大数据之从网页上爬取数据的方法详解

Python大数据之从网页上爬取数据的方法详解本文向大家介绍Python大数据之从网页上爬取数据的方法详解,包括了Python大数据之从网页上爬取数据的方法详解的使用技巧和注意事项,需要的朋友参考一下 本文实例讲述了Python大数据之从网页上爬取数据的方法。分享给大家供大家参考,具体如下: myspider.py : items.py : middlewares.py : pipelines.py : settings.py

-

将大型本地数据库与服务器数据库同步(MySQL)

问题内容: 我需要每周将一个大型(3GB + / 40+个表)本地MySQL数据库同步到服务器数据库。这两个数据库完全相同。本地数据库会不断更新,每周大约需要用本地数据更新服务器数据库。您可以将其称为“镜像数据库”或“主服务器/主服务器”,但是我不确定这是否正确。 现在,数据库仅在本地存在。所以: 1)首先,我需要将数据库从本地复制到服务器。由于数据库大小和PHPMyAdmin的限制,使用PHPM

-

在其他数据框中查找最近点(包含大量数据)

问题很简单,我有两个数据帧: > 一个有90000套公寓和他们的经纬度 还有一个有3000个药房和他们的经纬度 我想为我所有的公寓创建一个新变量:“最近药房的距离” 为此,我尝试了两种花费大量时间的方法: 第一种方法:我创建了一个矩阵,我的公寓排成一行,我的药店排成一列,它们之间的距离在交叉点上,然后我只取矩阵的最小值,得到一个90000值的列向量 我只是用了一个双人床来搭配numpy: ps:我

-

pytorch下大型数据集(大型图片)的导入方式

本文向大家介绍pytorch下大型数据集(大型图片)的导入方式,包括了pytorch下大型数据集(大型图片)的导入方式的使用技巧和注意事项,需要的朋友参考一下 使用torch.utils.data.Dataset类 处理图片数据时, 1. 我们需要定义三个基本的函数,以下是基本流程 这里,我将 读取图片 的步骤 放到 __getitem__ ,是因为 这样放的话,对内存的要求会降低很多,我们只是将

-

弹性搜索未提供大量的页面大小数据

问题内容: 要获取的数据大小:大约20,000 问题:在python中使用以下命令搜索Elastic Search索引数据 但没有得到任何结果。 如果我给的尺寸小于或等于10,000,则可以正常工作,但不能与20,000相匹配, 请帮助我找到最佳的解决方案。 PS:在深入研究ES时发现此消息错误: 结果窗口太大,从+大小必须小于或等于:[10000],但为[19999]。有关请求大数据集的更有效方

-

mysql 大表批量删除大量数据的实现方法

本文向大家介绍mysql 大表批量删除大量数据的实现方法,包括了mysql 大表批量删除大量数据的实现方法的使用技巧和注意事项,需要的朋友参考一下 问题参考自:https://www.zhihu.com/question/440066129/answer/1685329456 ,mysql中,一张表里有3亿数据,未分表,其中一个字段是企业类型,企业类型是一般企业和个体户,个体户的数据量差不多占50

-

infinispan文件存储大小与数据大小不成比例

我编写了一个小型infinispan缓存PoC(下面的代码),以尝试评估infinispan的性能。运行它时,我发现对于我的配置,infinispan显然无法从磁盘中清除缓存项的旧副本,导致磁盘空间消耗比预期的要多几个数量级。 如何将磁盘使用率降低到实际数据的大致大小? 以下是我的测试代码: 这是infinispan配置: Infinispan(应该是?)配置为写入缓存,其中包含RAM中的20个最

-

科大讯飞 大数据开发工程师 1面 已挂

科大讯飞 大数据开发工程师 1面 已挂45min 自我介绍 数仓项目的数据采集模块怎么做的 flume组成,各个模块的功能 为什么要使用这些source或者是sink file channel和memory channel有什么区别,分别在什么场景使用 flume内部原理 sink消费能力弱,channel会不会丢失数据 数千台机器需要采集日志小文件到hdfs上,该怎么办? 数千个flume要怎么统一配置,修改就分发吗? maxwel

-

2018全球大数据产业将呈七大发展趋势

2018全球大数据产业将呈七大发展趋势主要内容:大数据大数据 达沃斯世界经济论坛等全球性重要会议都把“大数据”作为重要议题,进行讨论和展望。而随着大数据发展日新月异,我们国家也在审时度势、精心谋划、超前布局、力争主动。本报精心策划,就全球大数据发展趋势,中国的机遇和挑战,大数据发展法制建设等展开调研和采访。 “大数据”是今年达沃斯世界经济论坛的热词之一,与会各界都对云计算、大数据等驱动经济数字化转型因素表达了高度关注。而在年初举办的2018拉斯维加斯

-

使用mysql处理非常大的数据

问题内容: 抱歉,很长的帖子! 我有一个包含约30个表的数据库(InnoDB引擎)。这些表中只有两个表,即“ transaction”和“ shift”非常大(第一个表有150万行,而shift有23000行)。现在一切正常,我对当前的数据库大小没有任何问题。 但是,我们将有一个类似的数据库(相同的数据类型,设计等),但数据库更大,例如,“事务”表将具有约 10亿条记录 (每天约有 230 万笔交

-

postInstantiate buildSessionFactory慢/内存巨大的数据库

问题内容: 拥有一个拥有520多个表的ERP数据库,EntityPersister的postInstanciate速度非常慢,并且消耗的512M以上(仅对于一个会话Factory而言是很大的),应用程序也变得非常慢。 问题答案: 我无法发布所有更改,但是这里有一些想法: 1_ postInstanciate为所有实体和集合创建许多Entiy加载器(每个实体和每个集合的加载器类型很多),此操作应按需

-

Golang从管道中读取大量数据

问题内容: 我试图读取就是BEING柏油,流媒体,以标准输入存档,但我不知怎么读 远远 在管道的数据超过焦油发送。 我这样运行我的命令: 源代码是这样的: 对于100MB的涂油文件夹,我将获得1468个4MB的块(即6.15GB)!此外,数组的大小似乎无关紧要:如果将块大小设置为40MB,我仍然会获得约1400个40MB数据块,这根本没有意义。 要使用Go正确读取数据,我需要做些什么吗? 问题答案