《七牛云》专题

-

如何解决谷歌云存储403禁止访问bucket

我想从Google Play Analytics获取数据,它存储在Google云存储中。经过研究,洛特发现,并没有直接的API来获取谷歌播放分析报告数据。因此,我找到了通过GoogleAPI客户端PHP库链接访问GooglePlay帐户报告的方法,并遵循了给定的方法。我已经创建了服务帐户,授予了所有者权限,并启用了谷歌云api。 在链接中显示的代码中,如果我使用var_dump($bucket),

-

在Spring云配置客户端中启用/总线/刷新endpoint

我的Spring云配置客户端依赖于Spring。云起动机。公共汽车amqp,但它仍然没有启用总线/刷新endpoint 我在配置客户端应用程序中有这些依赖项,但仍然没有启用总线/刷新、总线/环境。 请让我知道我的客户申请中缺少什么。 注: 我尝试在应用程序中设置这些指标。yml或应用程序。属性,因为这些属性由总线自动配置用来启用endpoint。 在我的Spring Cloud Config Se

-

Spring云流没有向RabbitMQ发送消息,而是在同一个pod中使用。生产者和消费者在同一个应用程序中

我使用的是Spring Cloud Stream和RabbitMQ,我在同一个应用程序中配置了生产者和消费者,但使用了两个不同的通道。问题是,我的应用程序有五个副本在Kubernetes上运行,但只有发送消息的pod会使用它们,其他四个不会使用。在RabbitMQ控制台上,没有收到任何消息,消息速率图不会更改。当我注释OrdersListener时,消息会成功发送到RabbitMQ集群。有人知道可

-

Spring的云流:Spring。云流动违约消费者并发属性的确切含义

我想知道使用spring时“并发”的确切含义。云流动违约消费者并发属性。 文档(https://docs.spring.io/spring-cloud-stream/docs/Chelsea.RELEASE/reference/html/_configuration_options.html)表示“入站消费者的并发”,这可以通过多种方式解释。 幕后创建了什么类型的线程执行器? 谢啦!

-

改变Spring云流中的行为。使标头匹配器区分大小写

我需要自定义的“Id”Kafka标题,但不需要来自SpringKafka流的“Id”标题。 受保护的静态类SimplePatternBasedHeaderMatcher在公共布尔matchHeader方法中使用toLowerCase()逻辑。 所以最后我得到了两个标头:“Id”(我的标头)和“id”(由Spring Cloud Stream提供)。 如果不需要区分大小写的标头匹配器,如何通过yam

-

Spring云流-kafka-空确认标头

我想使用spring cloud stream手动提交偏移量-仅当消息处理成功时。这是我的代码应用程序。yml公司 但我的确认对象为空,因为在标头中,对象“kafka\u确认”本身不存在。 如何获取确认对象

-

基于负载的Spring云流内容路由

我们正在使用Spring Cloud Stream v2。2带有Kafka和Avro(本机编码器/解码器)。我们正在尝试根据负载的条件使用基于内容的路由。据我所知,根据Spring Cloud Stream文档,基于内容的路由只能在标头上实现,因为负载到达条件时没有经过类型转换过程。因此,除非条件基于字节格式,否则它将无法按预期工作。但是,我知道,当在本机模式下使用Avro时,会跳过消息头,并且不

-

Spring云流消息自/到JSON转换配置

我正在使用Spring Cloud Stream和RabbitMQ活页夹。它可以很好地处理字节[]负载和Java本机序列化,但我需要处理JSON负载。 这是我的处理器类。 输入到和输出到是带有Jackson注释的POJO。 如何配置JSON转换策略 消息头应该如何被接受和处理

-

抽象Spring云流生产者和消费者代码

我有一个服务,它从不同的Spring云流通道(绑定到EventHub/Kafka主题)生成和使用消息。有几种设置类似的服务。 配置如下所示 生产者/发布者代码如下所示 类似地,我还有多个其他发布者发布到不同的活动中心/主题。请注意,每个已发布的消息都有一个租户id标头。这是我的多租户应用程序特定于跟踪租户上下文的内容。还请注意,在发送消息时,我正在获取要发布到的频道。 我的消费者代码如下所示 同样

-

使用Spring云流将RabbitMQ使用者绑定到现有队列

我使用RabbitMQ网络创建了一个主题交换UITX并绑定到交换两个队列TX. Q1和TX. Q2,每个队列都相应地绑定了路由密钥rk1和rk2,并向交换产生了少量消息。 现在,我想使用Spring Cloud Stream创建一个消费者,它只从Q1获取消息。我尝试使用配置: 以及使用消息的方法的注释。 因此,我可以看到使用者创建了一个同名TX.Q1的队列(或绑定),但新队列/绑定的路由键是# 如

-

发送带有Spring云流和RabbitMq更改ID的消息

我正在使用Spring Cloud Stream和RabbitMq在不同的微服务之间交换消息。 这是我发布消息的设置。 . 以及接收消息的设置 . 我能够成功地使用此设置交换消息。我希望,发送消息和接收消息的ID是相等的。但它们总是不同的UUID。 有没有一种方法可以让消息从生产者通过RabbitMq一直保持相同的ID到消费者?

-

Spring云流动态通道

我正在使用Spring Cloud Stream,希望以编程方式创建和绑定通道。我的用例是,在应用程序启动期间,我收到要订阅的Kafka主题的动态列表。然后如何为每个主题创建频道?

-

使用Spring云数据流docker-compose配置Spring指标收集器

我有以下docker-compose.yml我有数据流服务器运行,kafka,zoomaster,mysql,指标收集器。 配置:(我只提供dataflow server(1.5.2版本),metrics collector)metrics collector:图片:springcloud/metrics-collector-kafka-10环境:-spring。安全使用者名称=Spring-Sp

-

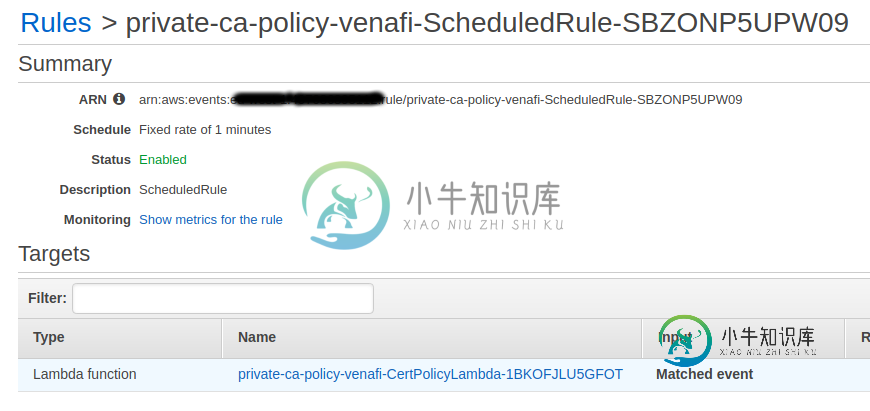

如何使用云形成将云观察事件触发器添加到AWS lambda?

如何使用云形成将云观察事件触发器添加到AWS lambda?我需要用lambda和cloudwatch事件创建一个cloudformation模板,该模板将定期触发它。这是我的模板:

-

Terraform多个云观察事件触发相同的lambda函数

我已经在Terraform中设置了以下内容。所以有两条事件规则,上午8点开始\u事件,下午6点停止\u事件。 每个事件都将一个操作传递给lambda 这很有效 我面临的问题是,我无法让Terraform将start\u事件与lambda函数相关联。我进入AWS控制台,可以手动将CloudWatch start\u事件触发器添加到lambda函数中。 如果我有start_event资源 它会抱怨语句