人脸检测在某些设备上不起作用

我在GitHub中使用这个项目:https://github.com/gankit0701/Face-Mask-Detection-In-android-App

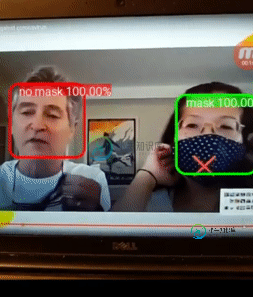

这个使用TensorFlow Lite for mobile(Android)。它检测一个人是否戴面具。它在面部顶部绘制一个框(红色/绿色)。

我奇怪的问题是,如果我直接在设备上安装演示APK,面罩检测工作正常。但是当我在Android Studio中打开项目并从那里运行项目时,检测不起作用,没有绘制框,推理时间始终为零。但是当我使用演示APK安装它时,一切都很完美:https://github.com/gankit0701/Face-Mask-Detection-In-android-App/tree/master/apk

需要注意的是,我有两个设备,一个是华为手机,该应用程序通过apk或Android Studio在这个设备上运行。另一个无法通过Android Studio运行的是RockChip Android设备。

共有1个答案

不推荐使用内部的TFLite调用。所以,“新构建”失败的原因是不推荐的调用。我已经更改了一些以在android 8.0上启动应用程序(在较新版本上失败),但您应该检查所有代码:TFLiteObjectDetectionAPIModel.java@129:

d.tfLite = new Interpreter(loadModelFile(assetManager, modelFilename), new Interpreter.Options().setNumThreads(NUM_THREADS));

TFLiteObjectDetectionAPIModel.java@281:

@Override

public void setUseNNAPI(boolean isChecked) {

if (tfLite != null && isChecked) {

// NnApiDelegate nnApiDelegate = new NnApiDelegate(loadModelFile(assetManager, modelFilename));

// tfliteOptions.addDelegate(nnApiDelegate);

// tflite = new Interpreter(tfliteModel, tfliteOptions);

}

}

}

如果您想使用NNAPI,应该重写应用程序。作为示例,请参阅此

-

我们用FCM创建了一个带有通知的聊天应用程序,我的代码是正确的,我的设备也得到了推送通知数据,但一些中国制造的设备,如vivo、oppo、一加、小米,不允许通知显示,除非我在各自厂商的受保护的应用程序列表中添加应用程序。他们有没有办法解决这个问题。 https://hackernoon.com/notifications-in-android-are-horribly-broken-b8dbec6

-

1.接口描述 对照片中的人脸进行检测,返回人脸数目和每张人脸的位置信息 图片要求 格式为 JPG(JPEG),BMP,PNG,GIF,TIFF 宽和高大于 8px,小于等于4000px 小于等于 5 MB 请求方式: POST 请求URL: https://cloudapi.linkface.cn/face/face_detect 2.请求参数 字段 类型 必需 描述 api_id string

-

我正试图在后台获取用户位置。在我的手机(htc one m7)上一切都很好,但出于某种原因,它不能在我测试的两个设备上工作:三星galaxy s3索尼Xperia Z1 顺便说一句:我把所有东西都添加到了清单中。

-

问题内容: 我正在尝试在android上进行人脸检测,并且正在遵循指南http://www.richardnichols.net/2011/01/java- facial-recognition-haar-cascade-with-jjil- guide/ 但是在android上。当我做 尽管确切的代码使用netbeans代码返回了2张面孔,但pushAndReturn似乎只从Android图像上

-

我的Android应用程序无法安装在一些“随机”、较旧的API设备上(任何低于API级别25的设备),错误如下: 所以,基本上看起来… API 我见过类似的问题,答案与小写的包名有关。我已经有了。 有人有什么想法吗? 舱单: BTW我用的是Visual Studio 2019和一夫一妻制3.7

-

调用人脸检测接口,返回人脸检测的结果 requestsyntax image = Image(uri="fds://cnbj2.fds.api.xiaomi.com/vision-test/test_img.jpg") detect_faces_request = DetectFacesRequest(image) faces_list = vision_client.analysis_faces