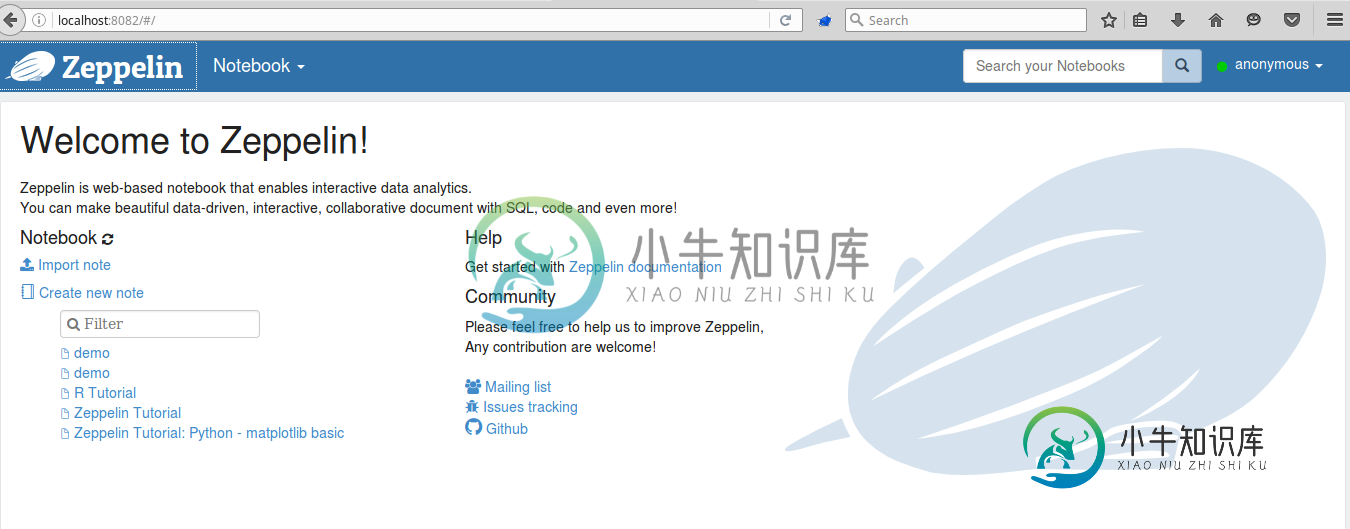

使用Spark的Apache Zeppelin配置

我一直试图用Spark2.0配置Apache Zeppeling。我设法将它们都安装在linux操作系统上,并将spark设置在8080端口上,而zeppelin服务器设置在8082端口号上。

在zeppelin的zeppelin-env.sh文件中,我将SPARK_HOME变量设置为Spark文件夹的位置。

然而,当我试图创建一个新节点时,没有正确的编译。我似乎没有配置解释器,因为开始选项卡中缺少解释器选项卡。

共有1个答案

我认为如果不从源代码构建就不可能使用Spark2.0,因为这个版本发生了一些相对较大的变化。

您可以使用Spark2.0概要文件克隆zeppelin git repo并构建,如github https://github.com/apache/zeppelin上的自述文件所述。

我试过了,很管用。

-

我有一个从配置文件读取数据的Spark作业。此文件是一个类型安全配置文件。 我要使用的外部application.conf的内容如下所示: 此application.conf文件存在于我的本地计算机文件系统中(而不是HDFS上) 我用的是Spark1.6.1和纱线 提前致谢

-

Spark提供三个位置用来配置系统: Spark properties控制大部分的应用程序参数,可以用SparkConf对象或者java系统属性设置 Environment variables可以通过每个节点的conf/spark-env.sh脚本设置每台机器的设置。例如IP地址 Logging可以通过log4j.properties配置 Spark属性 Spark属性控制大部分的应用程序设置,并

-

我设置了一个AWS EMR集群,其中包括Spark 2.3.2、hive 2.3.3和hbase 1.4.7。如何配置Spark以访问hive表? 我采取了以下步骤,但结果是错误消息: Java语言lang.ClassNotFoundException:java。lang.NoClassDefFoundError:org/apache/tez/dag/api/SessionNotRunning使用

-

当我在oozie中执行spark进程时,我有以下错误。找不到数据库。 这是我的火花配置

-

我正在与AWS工作,我有使用Spark和Hive的工作流。我的数据是按日期分区的,所以每天我的S3存储中都有一个新分区。我的问题是,当有一天加载数据失败时,我不得不重新执行那个分区。接下来编写的代码是: 在我的流动中发生了什么?如果我使用savemode.overwrite,完整的表将被删除,并且只保存分区。如果我使用savemode.append,我可能会有重复的数据。 我想要的是:在表中,分区

-

StreamingContext-fileStream也被重载以获取Hadoop配置对象,但它似乎不起作用。 来自Spark源代码的代码片段: https://github . com/Apache/spark/blob/master/streaming/src/main/Scala/org/Apache/spark/串流/StreamingContext.scala 代码片段:工作正常 编译错误