Keras输入解释:input_shape、units、batch_size、dim等

对于任何Keras层(layer类),有人能解释一下如何理解input_shape、units、dim等之间的区别吗?

例如,文档说units指定层的输出形状。

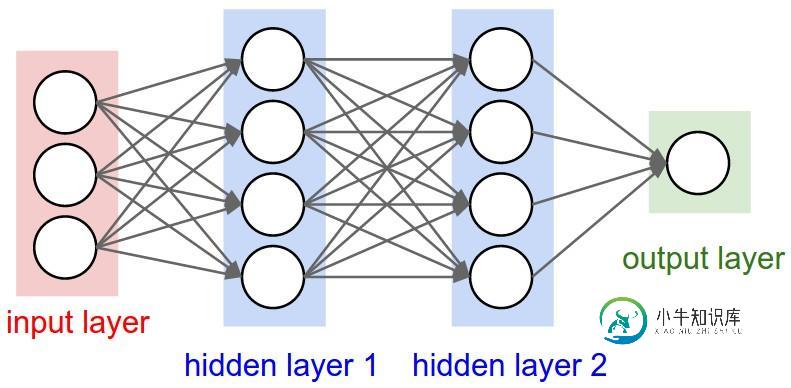

在下面的神经网络图像中,hidden layer1有4个单元。这是否直接转换为层对象的units属性?或者Keras中的单位等于隐藏层中每个权重的形状乘以单位数?

共有1个答案

“神经元”或“细胞”的数量,或其内部的任何东西。

它是每一层的属性,是的,它与输出形状相关(我们稍后将看到)。在你的图片中,除了输入层,它在概念上与其他层不同,你有:

- 隐层1:4个单位(4个神经元)

- 隐藏层2:4个单元

- 最后一层:1个单元

层与层之间流动的是张量。张量可以看作是矩阵,有形状。

在Keras中,输入层本身不是层,而是张量。它是你发送到第一个隐藏层的起始张量。这个张量必须与你的训练数据具有相同的形状。

示例:如果您有30幅50x50像素的RGB(3通道)图像,则输入数据的形状为(30,50,50,3)。那么你的输入层张量,必须有这个形状(详见“Keras中的形状”部分)。

-

null

- 如果使用

channels_last:(batch_size,imageside1,imageside2,channels) - 如果使用

channels_first:(batch_size,channels,imageside1,imageside2)

- 有关如何为循环层准备数据的详细信息

现在,输入形状是您必须定义的唯一形状,因为您的模型无法知道它。只有你知道,基于你的训练数据。

所有其他形状都是根据每一层的单元和特性自动计算的。

给定输入形状,所有其他形状都是图层计算的结果。

每一层的“单位”将定义输出形状(由该层产生的张量的形状,它将是下一层的输入)。

每种类型的层都以特定的方式工作。密集层具有基于“单元”的输出形状,卷积层具有基于“滤波器”的输出形状。但它总是基于某些层属性。(有关每层的输出内容,请参阅文档)

让我们来展示“密集”层发生了什么,这是您的图中所示的类型。

密集层的输出形状为(batch_size,units)。所以,是的,层的属性units也定义了输出形状。

-

null

权重将根据输入和输出形状完全自动计算。同样,每种类型的层都以特定的方式工作。但是权重将是一个矩阵,能够通过某种数学运算将输入形状转换为输出形状。

在密集层中,权重乘以所有输入。它是一个矩阵,每个输入有一列,每个单元有一行,但这对于基本工作来说往往不重要。

在图像中,如果每个箭头上都有一个乘法数,那么所有的数加在一起就形成了权重矩阵。

由于输入形状是您需要定义的唯一形状,Keras将在第一层中要求它。

但在这个定义中,Keras忽略了第一个维度,即批处理大小。您的模型应该能够处理任何批量大小,因此您只定义其他维度:

input_shape = (50,50,3)

#regardless of how many images I have, each image has this shape

可选地,或者当某些类型的模型需要时,您可以通过batch_input_shape=(30,50,50,3)或batch_shape=(30,50,50,3)传递包含批处理大小的形状。这将您的培训可能性限制在此唯一的批处理大小,因此只应在真正需要时才使用。

因此,即使您使用了input_shape=(50,50,3),当keras向您发送消息或打印模型摘要时,它将显示(None,50,50,3)。

第一个维度是批处理大小,它是none,因为它可以根据您提供的训练示例的数量而变化。(如果显式定义了批处理大小,则将显示您定义的数字,而不是none)

此外,在高级工作中,当您实际直接操作张量时(例如,在Lambda层中或在损失函数中),批处理大小维度将在那里。

- 因此,在定义输入形状时,忽略批处理大小:

input_shape=(50,50,3) - 直接对张量做运算时,形状会再次

(30,50,50,3) - 当keras向您发送消息时,形状将为

(无,50,50,3)或(30,50,50,3),具体取决于它向您发送的消息类型。

而到底什么是暗淡?

如果您的输入形状只有一个维度,您不需要将它作为元组给出,您将input_dim作为标量数给出。

因此,在您的模型中,输入层有3个元素,您可以使用这两个元素中的任何一个:

input_shape=(3,)--当您只有一个维度时,逗号是必需的input_dim=3

但是当直接处理张量时,dim通常会指张量有多少维。例如,具有形状(25,109,09)的张量具有2个维度。

Keras有两种实现方法,顺序模型,或者函数API模型。我不喜欢使用顺序模型,以后你将不得不忘记它无论如何,因为你将需要有分支的模型。

PS:这里我忽略了其他方面,比如激活功能。

使用顺序模型:

from keras.models import Sequential

from keras.layers import *

model = Sequential()

#start from the first hidden layer, since the input is not actually a layer

#but inform the shape of the input, with 3 elements.

model.add(Dense(units=4,input_shape=(3,))) #hidden layer 1 with input

#further layers:

model.add(Dense(units=4)) #hidden layer 2

model.add(Dense(units=1)) #output layer

from keras.models import Model

from keras.layers import *

#Start defining the input tensor:

inpTensor = Input((3,))

#create the layers and pass them the input tensor to get the output tensor:

hidden1Out = Dense(units=4)(inpTensor)

hidden2Out = Dense(units=4)(hidden1Out)

finalOut = Dense(units=1)(hidden2Out)

#define the model's start and end points

model = Model(inpTensor,finalOut)

- 输入量:

(无,3) - 隐藏1out:

(无,4) - 隐藏2out:

(无,4) - 结束:

(无,1)

-

在模型中添加LSTM层之前,我不确定是否需要添加密集输入层。例如,使用以下模型: LSTM层是否为输入层,密集层是否为输出层(即无隐藏层)?或者Keras是否创建了一个输入层,这意味着LSTM层将是一个隐藏层?

-

本文向大家介绍浅谈Keras参数 input_shape、input_dim和input_length用法,包括了浅谈Keras参数 input_shape、input_dim和input_length用法的使用技巧和注意事项,需要的朋友参考一下 在keras中,数据是以张量的形式表示的,不考虑动态特性,仅考虑shape的时候,可以把张量用类似矩阵的方式来理解。 例如 [[1],[2],[3]]

-

问题内容: 我拥有的代码(我无法更改)将Resnet与input_tensor一起使用。 研究源代码,ResNet50函数使用创建一个新的keras输入层,然后创建模型的其余部分。这是我要用自己的模型复制的行为。我从h5文件加载我的模型。 由于此模型已经具有输入层,因此我想用定义的新输入层替换它。 如何替换输入层? 问题答案: 使用以下方法保存模型时: 它将保存以下内容: 模型的体系结构,允许创建

-

Dim 是一个自托管的媒体管理器。通过最小的设置,Dim 将组织和美化你的媒体收藏,让你随时随地访问和播放它们。

-

Pascal程序可以包含称为单元的模块。 一个单元可能包含一些代码块,而这些代码块又由变量和类型声明,语句,过程等组成.Pascal和Pascal中有许多内置单元允许程序员定义和编写自己的单元以供使用后来在各种节目中。 使用内置单元 使用子句将内置单元和用户定义单元都包含在程序中。 我们已经在Pascal - Variants教程中使用了变体单元。 本教程介绍如何创建和包含用户定义的单元。 但是,

-

CSS单位 CSS有不同单位的几个单位,如宽度,边距,填充,字体大小,边框宽度等。长度表示使用数值后跟长度单位,如px,dp,em等。 它不允许在数值和长度单位之间使用空格。长度单位划分如下 - 相对单位 absolute 相对单位 长度相对于另一个长度属性相对称为相对长度单位。 单位 缩写 Pixels px Points pt Inches in Centimeters cm Picas pc