使用带头盔的Kafka/Confluent连接器

我已经安装了Kafka在当地的Minikube通过使用Helm图表https://github.com/confluentinc/cp-helm-charts按照以下说明https://docs.confluent.io/current/installation/installing_cp/cp-helm-charts/docs/index.html如下:

helm install -f kafka_config.yaml confluentinc/cp-helm-charts --name kafka-home-delivery --namespace cust360

kafka_config.yaml 几乎与默认的 yaml 相同,唯一的例外是我将其缩减为 1 个服务器/代理而不是 3 个(只是因为我试图节省本地 minikube 上的资源;希望这与我的问题无关)。

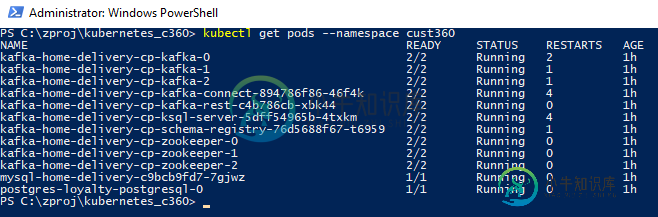

同样在Minikube上运行的还有一个MySQL实例。下面是 kubectl get pods --namespace myNamespace 的输出:

我想使用其中一个连接器(例如Debezium MySQL CDC)连接MySQL和Kafka。在说明中,它说:

安装您的连接器

使用ConFluent Hub客户端安装此连接器:

安装debezium/debezia连接器mysql: 0.9.2

听起来不错,除了1)我不知道在哪个pod上运行这个命令,2)似乎没有一个pod有汇流中心命令可用。

问题:

-

< li >合流枢纽不是通过那些舵图来安装的吗? < li >我必须自己安装合流集线器吗? < li >如果是,我必须将它安装在哪个pod上?

共有3个答案

Kafka Connect吊舱应该已经安装了汇流集线器。你应该在那个吊舱上运行命令。

只是对上面杰根评论的补充:https://stackoverflow.com/a/56049585/6002912

您可以选择执行下面的Dockerfile。推荐。

FROM confluentinc/cp-server-connect-operator:5.4.0.0

RUN confluent-hub install --no-prompt debezium/debezium-connector-postgresql:1.0.0

或者你可以使用Docker的多阶段构建。

FROM confluentinc/cp-server-connect-operator:5.4.0.0

COPY --from=debezium/connect:1.0 \

/kafka/connect/debezium-connector-postgres/ \

/usr/share/confluent-hub-components/debezium-connector-postgres/

这将帮助你节省时间,为你的插件如debezium-connector-postgres获取正确的jar文件。

来自Confluent文档:https://docs.confluent.io/current/connect/managing/extending.html#create-a-docker-包含图像的c-hub-连接器

理想情况下,这应该可以作为helm脚本的一部分进行配置,但遗憾的是,到目前为止还没有。解决这一问题的一种方法是从Confluent的Kafka Connect Docker镜像构建一个新的Docker。手动下载连接器并将内容提取到文件夹中。将其内容复制到容器中的路径。类似下面的内容。

Dockerfile的内容

FROM confluentinc/cp-kafka-connect:5.2.1

COPY <connector-directory> /usr/share/java

/usr/stock/java是Kafka Connect查找插件的默认位置。您还可以在helm安装期间使用不同的位置并提供新位置(plugin.path)。

构建此映像并将其托管在可访问的位置。在helm安装期间,您还必须提供/覆盖图像和标签详细信息。

以下是< code>values.yaml文件的路径。您可以在这里找到< code>image和< code>plugin.path值。

-

我需要为REST API创建kafka源连接器,并使用头验证,如curl-H“Authorization:Basic”-H“clientID:”“https: 我还尝试使用“connector.class”:“com.tm.kafka.connect.rest.RestSourceConnector”,我的joson文件如下 但没有希望。知道如何通过身份验证获取RESTAPI数据。我的身份验证参数

-

我有一个 Confluent 接收器连接器,它正在从 Kafka 主题获取数据。然后,它会摄取到 S3 存储桶中。 摄取工作正常,一切都很好,但是现在我需要在将Avro数据放入存储桶之前对其进行压缩。 我已经尝试了以下配置 “avro.code”,我以为会压缩数据,但它没有。取而代之的是,我还尝试了“ ”s3.compression.type“: ”snappy“ ',仍然没有运气!但是,这确实适

-

Confluent's .NET Client for Apache KafkaTM confluent-kafka-dotnet is Confluent's .NET client for Apache Kafka and theConfluent Platform. Features: High performance - confluent-kafka-dotnet is a lightw

-

我试图运行Kafka服务与Zookeper,Kafdrop和模式注册表,我使它的工作安装Kafka,Zookeper和Kadrop在一个容器,然后安装合流模式注册表在另一个(与自己的Kafka,Zoowatch,Ksql服务器和Rest代理),然而尝试要使kafdrop读取模式注册表不工作,所以现在我想只安装一个容器与Kafka,Zoowatch,Kafdrop和模式注册表,即使一切都成功安装,模

-

使用此Kafka Connect连接器: https://www.confluent.io/hub/confluentinc/kafka-connect-s3 我手动将其安装到我的kafka Connect Docker映像的插件中。我的目的是使用Kafka Connect将来自Kafka主题的Avro记录写入S3。 在运行时,使用Kafka Connect,我会得到以下错误: 在ConFluen

-

从服务器上,我能够连接并从配置了SSL的远程kafka服务器主题获取数据。 如果我指向GCS上的证书,当证书指向Google存储桶时,它会抛出错误。 其次是:Truststore和Google Cloud Dataflow 更新的代码将SSL truststore、keystore位置指向本地机器的/tmp目录认证,以防KafkaIO需要从文件路径读取。它没有抛出FileNotFounderRor