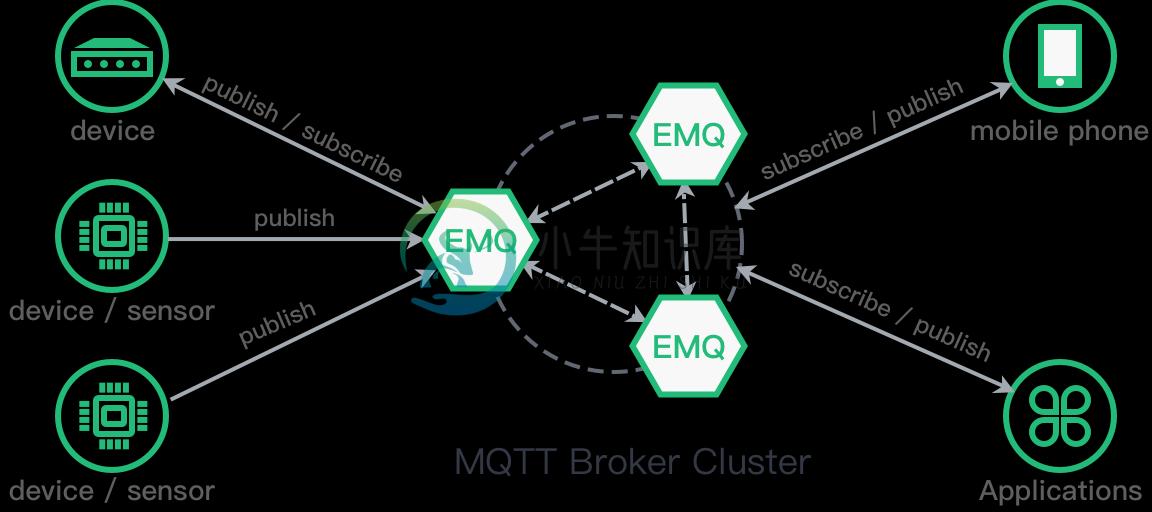

EMQX 是基于 Erlang/OTP 语言平台开发,支持大规模连接和分布式集群,发布订阅模式的开源 MQTT 消息服务器。

EMQX 消息服务器完整支持 MQTT V3.1/V3.1.1/V5.0 版本协议规范,并扩展支持 MQTT-SN 、WebSocket、CoAP、LwM2M、Stomp 以及私有 TCP/UDP 协议。EMQX 消息服务器支持单节点100万连接与多节点分布式集群。

EMQX 消息服务器为大规模设备连接 (C1000K+) 的物联网、车联网、智能硬件、移动推送、移动消息等应用,提供完全开放源码、安装部署简便、企业级稳定可靠、可弹性扩展、易于定制开发的 MQTT 消息服务器。

-

忘记过去,超越自己 ❤️ 博客主页 单片机菜鸟哥,一个野生非专业硬件IOT爱好者 ❤️ ❤️ 本篇创建记录 2023-01-15 ❤️ ❤️ 本篇更新记录 2022-01-15 ❤️ �� 欢迎关注 ��点赞 ��收藏 ⭐️留言�� �� 此博客均由博主单独编写,不存在任何商业团队运营,如发现错误,请留言轰炸哦!及时修正!感谢支持! �� Arduino ESP8266教程累计帮助过超过1W+同学

-

在我的聊天应用程序中,每当用户收到新消息时,我使用FCM和Firebase功能发送通知。 为此,我有一个FirebaseMessagingService,它覆盖了。除此之外,此服务还覆盖。每当用户第一次启动应用程序时,就会调用,我检索一个新令牌并将其存储在Firebase实时数据库中。 然后我去和一些用户聊天(不关闭应用程序)。当我收到新消息时,我会收到通知。调用。 问题是,当我关闭应用程序,然后

-

我正在编写自己的websocket服务器和客户端。我成功地处理了握手并建立了联系。 现在我正在编写send_message函数,它创建了一个合适的框架。下面的例子只是为了这个问题,它不是我最终打算写的,这只是我尝试给我相同的结果的许多方法中的一种。 输入:以上函数应发送 第一个字节 第一位设置为1-,表示这是消息的最后一帧 第二、第三和第四个-所有的零,对于这个例子来说是不相关的 以下四位-000

-

全部的 我对RabbitMQ在消耗大量消息(例如280000条)时的性能有一个问题。从性能角度来看,它似乎会上下波动。从管理控制台获取的图中所示的图表演示了这一点,其中消费者平均每秒约40条消息,然后跳到每秒约120条消息: 该模式将再次重复,它将再次返回到40,然后再次返回120,依此类推,如果我在1小时后运行相同的测试,则会发生相同的上下效应,但范围可能会有很大差异,例如每秒140到400条消

-

BeX5消息服务详解(V3.2.1)视频: 视频:https://pan.baidu.com/s/1sls5c9B 配置 1.\conf\server.xml中 <mqtt-server>tcp://localhost:1883</mqtt-server> 配置消息服务地址 <external-address>http://demo.justep.cn</external-address>配置应

-

BeX5消息服务详解(V3.2.1)视频: 视频:https://pan.baidu.com/s/1sls5c9B 配置 1.\conf\server.xml中 <mqtt-server>tcp://localhost:1883</mqtt-server> 配置消息服务地址 <external-address>http://demo.justep.cn</external-address>配置应

-

主要内容:1 ReputMessageService消息重放服务,2 doReput执行重放,2.1 isCommitLogAvailable是否需要重放,2.2 getData获取重放数据,2.3 checkMessageAndReturnSize检查消息并构建请求,2.4 doDispatch分发请求,3 总结基于RocketMQ release-4.9.3,深入的介绍了Broker 消息重放服务ReputMessageService源码。 CommitLog文件顺序存储着所有的消息,理论上

-

我的应用程序在服务器上发生某种事件后接收推送通知。 除了在一小段时间内有许多事件一个接一个地发生的情况外,一切都很正常。 设备上的Firebase令牌也是正常的,因为应用程序从Firebase控制台接收通知。

-

我在Azure中托管了两个云服务辅助角色,一个使用NServiceBus(Azure服务总线传输)消耗消息,另一个生成消息。 昨天,我部署了一个新版本的生产者工作者角色,而队列中仍然有大量消息,因为我们正在处理早上遗留下来的大量消息。当生产者启动时,它似乎已经清空(或者可能重新创建)队列,许多重要的生产消息丢失。这似乎很奇怪,但日志显示,大约在生产者角色启动时,消费者没有处理进一步的消息,我们知道