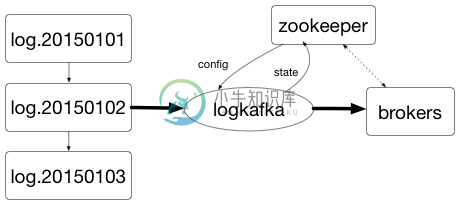

logkafka是一个日志收集代理,可以按行收集日志文件并发送到kafka 0.8,每行为一条消息。

在生产环境部署之前请查看一下FAQ。

特性

通过zookeeper来管理日志收集相关配置

日志文件轮转

批量发送

压缩 (none, gzip, snappy)

与其他日志聚合&监控工具的区别

与flume, fluentd, logstash区别:

日志收集配置和状态的管理:

flume, fluentd, logstash需要在日志所在机器添加日志收集配置项,并在本地启动服务,用于管理日志配置项和状态。

logkafka将日志收集配置和收集状态保存在zookeeper节点中:logkafka监控相应的节点,当配置变动时,logkafka会自动拉取最新的日志配置项;logkafka会将所收集文件内的当前偏移记录在本地文件中,并定期将收集的状态信息上传到zookeeper。

日志收集的顺序性

flume, fluentd, logstash的INPUT类型中都包含'tail'插件,但这些插件都是对扫描到的所有文件同时进行收集,不会考虑日志文件在时间上的顺序性。

logkafka会按时间顺序扫描新的文件。

-

集群配置说明 集群模式 集群模式- 基于nacos 动态配置发布- 基于nacos 存储- 基于elasticsearch7 数据传输方式: kafka队列 nacos配置参照nacos部署 es配置参照ELK部署 服务分布 服务 模式 IP 用途 skywalking-OAP 集群 3.1.20.23, 3.1.20.24 后端 skywalking-UI 单点 3.1.20.32 ui页面 k

-

先简单记录下操作步骤,日后把详细原理给大家讲一下。 本文讲解单kafka实例和单zookeeper实例的过程。 下载 kafka 并解压。 运行kafka包里的 zookeeper程序。 运行kafka包里的 kafka程序。 创建 一个topic:oraclelog。 在graylog中创建 kafka raw text input,创建其他kafka input会报错,目前没有研究报错原因。

-

Python集成kafka主要用到python-kafka和pyKafka,先简单介绍下两者的使用方式。 一、pyKafka生产者 import time from pykafka import KafkaClient class PyKafkaTest(object): def __init__(self, host): # 可使用k

-

这篇文章如果对你有帮助,记得点赞哦!有问题也可以给我评论~ 一、背景 公司的日志希望能够同一到一个Kibana去做一个同一的展示,那就需要将任务的日志写到kafka。 Flink1.12开始默认的日志框架就是log4j2,那么配置的方式跟之前log4j的方式有了一些区别,这边也踩了一些坑才解决。 二、需要解决的痛点 - 如何区分JobManager和TaskManager的日志 -

-

Python logging用于输出Python程序运行的日志。现实中往往一个项目会部署在多台机器之上,这种情况下,为了方便对各主机运行日志进行收集,往往会使用消息队列。通过消息队列将各台机器上的日志收集并写入日志文件。本文使用Python logging结合Kafka作为范例,将日志输出到Kafka消息队列。 Python的logging模块对于日志的处理在Handler中。因此,我们可以通过继

-

日志目录 ${kafka.logs.dir}/server.log :服务器日志 ${kafka.logs.dir}/state-change.log:状态变化日志 ${kafka.logs.dir}/kafka-request.log:请求处理日志 ${kafka.logs.dir}/log-cleaner.log:日志清理 ${kafka.logs.dir}/controller.log:管理

-

系统与程序的运行日志对排查问题以及实现一些自动化操作可能非常有用。本文将简要说明收集 TiDB 及相关组件日志的方法。 TiDB 与 Kubernetes 组件运行日志 通过 TiDB Operator 部署的 TiDB 各组件默认将日志输出在容器的 stdout 和 stderr 中。对于 Kubernetes 而言,这些日志会被存放在宿主机的 /var/log/containers 目录下,并

-

前言 在进行日志收集的过程中,我们首先想到的是使用Logstash,因为它是ELK stack中的重要成员,但是在测试过程中发现,Logstash是基于JDK的,在没有产生日志的情况单纯启动Logstash就大概要消耗500M内存,在每个Pod中都启动一个日志收集组件的情况下,使用logstash有点浪费系统资源,经人推荐我们选择使用Filebeat替代,经测试单独启动Filebeat容器大约会消

-

前面的课程中和大家一起学习了 Kubernetes 集群中监控系统的搭建,除了对集群的监控报警之外,还有一项运维工作是非常重要的,那就是日志的收集。 介绍 应用程序和系统日志可以帮助我们了解集群内部的运行情况,日志对于我们调试问题和监视集群情况也是非常有用的。而且大部分的应用都会有日志记录,对于传统的应用大部分都会写入到本地的日志文件之中。对于容器化应用程序来说则更简单,只需要将日志信息写入到 s

-

本章展示如何配置Istio来自动收集mesh中服务的遥测数据。 在本章末尾,将为mesh中的服务调用启用新的metric和新的日志流。 BookInfo应用将作为介绍本章内容的示例应用。 开始之前 在集群中安装Istio并部署一个应用程序。 本章假设Mixer使用默认配置(--configDefaultNamespace=istio-system)。 如果使用不同的值,则更新这个任务中的配置和命令

-

我有一个关于2.9版本的log4j2的问题。基本上,我想做的与这里描述的相同(log4j),只有2.9:示例log4j v1. x 我需要一个可以在类中的任何方法中调用的记录器。这是从某个起点递归地收集所有后续日志。该集合应该能够在以后以任何形式读出。 在表单中设置结束后,集合中应包括以下日志: 开始 谢谢你的帮助

-

问题内容: 我已配置Java将垃圾回收信息转储到日志中(详细GC)。我不确定日志中的垃圾回收项是什么意思。这些条目的示例发布在下面。我在Google上四处搜寻,但找不到可靠的解释。 我有一些合理的猜测,但我正在寻找答案,这些答案提供了对条目中数字含义的严格定义,并有可靠的依据。引用sun文档的所有答案的自动+1。我的问题是: PSYoungGen指的是什么?我认为这与上一代(年轻人)有关,但是究竟

-

本文向大家介绍SpringBoot应用整合ELK实现日志收集的示例代码,包括了SpringBoot应用整合ELK实现日志收集的示例代码的使用技巧和注意事项,需要的朋友参考一下 ELK即Elasticsearch、Logstash、Kibana,组合起来可以搭建线上日志系统,本文主要讲解使用ELK来收集SpringBoot应用产生的日志。 ELK中各个服务的作用 Elasticsearch:用于存储

-

我是Hadoop的新手,正在学习apache Flume。我在Virtualbox上安装了CDH 4.7。以下命令将输出顶部 cputime。如何使用 Apache flume 将以下命令的日志数据输出传输到我的 HDFS?如何创建水槽配置文件?