pytorch对可变长度序列的处理方法详解

主要是用函数torch.nn.utils.rnn.PackedSequence()和torch.nn.utils.rnn.pack_padded_sequence()以及torch.nn.utils.rnn.pad_packed_sequence()来进行的,分别来看看这三个函数的用法。

1、torch.nn.utils.rnn.PackedSequence()

NOTE: 这个类的实例不能手动创建。它们只能被 pack_padded_sequence() 实例化。

PackedSequence对象包括:

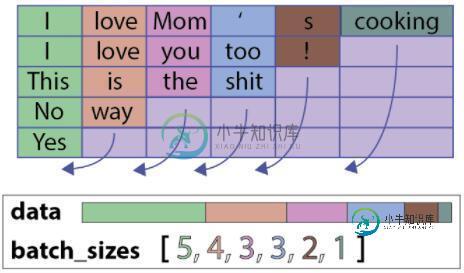

一个data对象:一个torch.Variable(令牌的总数,每个令牌的维度),在这个简单的例子中有五个令牌序列(用整数表示):(18,1)

一个batch_sizes对象:每个时间步长的令牌数列表,在这个例子中为:[6,5,2,4,1]

用pack_padded_sequence函数来构造这个对象非常的简单:

如何构造一个PackedSequence对象(batch_first = True)

PackedSequence对象有一个很不错的特性,就是我们无需对序列解包(这一步操作非常慢)即可直接在PackedSequence数据变量上执行许多操作。特别是我们可以对令牌执行任何操作(即对令牌的顺序/上下文不敏感)。当然,我们也可以使用接受PackedSequence作为输入的任何一个pyTorch模块(pyTorch 0.2)。

2、torch.nn.utils.rnn.pack_padded_sequence()

这里的pack,理解成压紧比较好。 将一个 填充过的变长序列 压紧。(填充时候,会有冗余,所以压紧一下)

输入的形状可以是(T×B×* )。T是最长序列长度,B是batch size,*代表任意维度(可以是0)。如果batch_first=True的话,那么相应的 input size 就是 (B×T×*)。

Variable中保存的序列,应该按序列长度的长短排序,长的在前,短的在后。即input[:,0]代表的是最长的序列,input[:, B-1]保存的是最短的序列。

NOTE: 只要是维度大于等于2的input都可以作为这个函数的参数。你可以用它来打包labels,然后用RNN的输出和打包后的labels来计算loss。通过PackedSequence对象的.data属性可以获取 Variable。

参数说明:

input (Variable) – 变长序列 被填充后的 batch

lengths (list[int]) – Variable 中 每个序列的长度。

batch_first (bool, optional) – 如果是True,input的形状应该是B*T*size。

返回值:

一个PackedSequence 对象。

3、torch.nn.utils.rnn.pad_packed_sequence()

填充packed_sequence。

上面提到的函数的功能是将一个填充后的变长序列压紧。 这个操作和pack_padded_sequence()是相反的。把压紧的序列再填充回来。

返回的Varaible的值的size是 T×B×*, T 是最长序列的长度,B 是 batch_size,如果 batch_first=True,那么返回值是B×T×*。

Batch中的元素将会以它们长度的逆序排列。

参数说明:

sequence (PackedSequence) – 将要被填充的 batch

batch_first (bool, optional) – 如果为True,返回的数据的格式为 B×T×*。

返回值: 一个tuple,包含被填充后的序列,和batch中序列的长度列表。

例子:

import torch

import torch.nn as nn

from torch.autograd import Variable

from torch.nn import utils as nn_utils

batch_size = 2

max_length = 3

hidden_size = 2

n_layers =1

tensor_in = torch.FloatTensor([[1, 2, 3], [1, 0, 0]]).resize_(2,3,1)

tensor_in = Variable( tensor_in ) #[batch, seq, feature], [2, 3, 1]

seq_lengths = [3,1] # list of integers holding information about the batch size at each sequence step

# pack it

pack = nn_utils.rnn.pack_padded_sequence(tensor_in, seq_lengths, batch_first=True)

# initialize

rnn = nn.RNN(1, hidden_size, n_layers, batch_first=True)

h0 = Variable(torch.randn(n_layers, batch_size, hidden_size))

#forward

out, _ = rnn(pack, h0)

# unpack

unpacked = nn_utils.rnn.pad_packed_sequence(out)

print('111',unpacked)

输出:

111 (Variable containing: (0 ,.,.) = 0.5406 0.3584 -0.1403 0.0308 (1 ,.,.) = -0.6855 -0.9307 0.0000 0.0000 [torch.FloatTensor of size 2x2x2] , [2, 1])

以上这篇pytorch对可变长度序列的处理方法详解就是小编分享给大家的全部内容了,希望能给大家一个参考,也希望大家多多支持小牛知识库。

-

问题内容: 我试图使用RNN(特别是LSTM)进行序列预测。但是,我遇到了序列长度可变的问题。例如, 我正在尝试使用一个基于此基准的简单RNN预测当前单词之后的下一个单词,以构建PTB LSTM模型 。 但是,该参数(用于展开到先前的隐藏状态)在每个Tensorflow的时期应保持相同。基本上,批处理句子是不可能的,因为句子的长度会有所不同。 在这里,对于我来说,每个句子都需要更改。我已经尝试了几

-

本文向大家介绍php可变长参数处理函数详解,包括了php可变长参数处理函数详解的使用技巧和注意事项,需要的朋友参考一下 本文实例讲述了php可变长参数处理函数。分享给大家供大家参考,具体如下: 与C++一样,PHP中也可以对含有可变参数的函数进行处理,道理都一样,需要函数来专门处理参数列表。PHP中提供了三个相关的函数: 1. func_num_args() -- 返回传递给函数的参数个数 in

-

在本章中,提出了一种替代方法,它依赖于跨两个序列的单个2D卷积神经网络。网络的每一层都根据到目前为止产生的输出序列重新编码源令牌。因此,类似注意的属性在整个网络中普遍存在。 在这里,将专注于使用数据集中包含的值创建具有特定池的顺序网络。此过程也最适用于“图像识别模块”。 以下步骤用于使用PyTorch创建带有Convent的序列处理模型 - 第1步 使用convent导入必要的模块以执行序列处理。

-

我试图读取一个csv文件,并将其设置为转换为另一种格式,以节省一些工作时间,但当一行的长度小于预期列时,我正在加载它的JTable会引发异常。如果行长度<列长度,是否有方法创建空单元格? 因此,您可以看到getValueAt(int row,int col)方法,如果col超过String[].length将导致错误。

-

本文向大家介绍keras在构建LSTM模型时对变长序列的处理操作,包括了keras在构建LSTM模型时对变长序列的处理操作的使用技巧和注意事项,需要的朋友参考一下 我就废话不多说了,大家还是直接看代码吧~ 补充知识:RNN(LSTM)数据形式及Padding操作处理变长时序序列dynamic_rnn Summary RNN 样本一样,计算的状态值和输出结构一致,也即是说只要当前时刻的输入值也前一状

-

本文向大家介绍对pandas处理json数据的方法详解,包括了对pandas处理json数据的方法详解的使用技巧和注意事项,需要的朋友参考一下 今天展示一个利用pandas将json数据导入excel例子,主要利用的是pandas里的read_json函数将json数据转化为dataframe。 先拿出我要处理的json字符串: pandas.read_json的语法如下: 第一参数就是json文