《stream》专题

-

Spark streaming Map状态超时延迟?

我希望Spark 1.6的新mapWithState API几乎可以立即删除超时的对象,但有一个延迟。 我正在使用下面经过修改的JavaStatefulNetworkWordCount版本测试API: 一起nc(

-

触发后取消Kafka Streams上的标点符号

我在转换器上创建了一个定时标点器,并将其定期运行(使用kafka v2.1.0)。每次我接受一个特定的密钥时,我都会创建一个这样的新密钥 我的问题是,我创建的所有这些标点符号都经常运行,我找不到取消它们的方法。我在互联网上找到了一个片段来使用 但不幸的是,这似乎只取消了最新创建的标点符号。 我编辑我的帖子只是为了进一步了解我的方法,以及这与沃兹尼亚的评论之间的关系。所以我的方法非常类似,只是使用一

-

kafka streams会话窗口保留时间

我们正在使用Kafka流的会话窗口来聚合相关事件的到达。除了聚合之外,我们还使用API指定窗口的保留时间。流信息: 会话窗口(非活动时间)为1分钟,传递到的保留时间为2分钟。我们使用定制的来映射事件的时间。 示例: 事件:e1;事件时间:上午10:00:00;到达时间:下午2点(同一天) 事件:e2;事件时间:上午10:00:30;到达时间:下午2:10(同一天) 第二个事件的到达时间是e1到达后

-

Java具有多个语句的8 Lambda Stream

我还在学习Lambda的过程中,如果我做错了什么,请原谅我 似乎只能对一条语句执行。它不会返回更新的流或函数来进一步处理。我可能选错了一个。 有人能指导我如何有效地做到这一点吗? 还有一个问题, 如何将其转换为Lambda表达式?

-

JAVA:如何使用stream[duplicate]从列表中删除重复项

我要根据列表中项目的属性(邮件)从列表中删除重复项。 我执行了以下操作:

-

Stream.of和IntStream.Range之间有什么区别?

请考虑以下代码: 输出将是: 谁能解释一下,为什么两个流的输出是不同的?

-

在ProjectReactor或akka streams中,接收器和用户之间的概念区别是什么?

接收器和订户的概念对我来说似乎很相似。此外,我没有看到在反应流规范中明确定义sink的概念。

-

Flink中StreamExecutionEnvironment和StreamTableEnvironment有什么

我已经看了官方的医生,但我仍然弄不清他们的区别。 此外,我试图编写一个Flink流作业,它接收来自Kafka的数据。在这种情况下,我应该使用哪种环境?

-

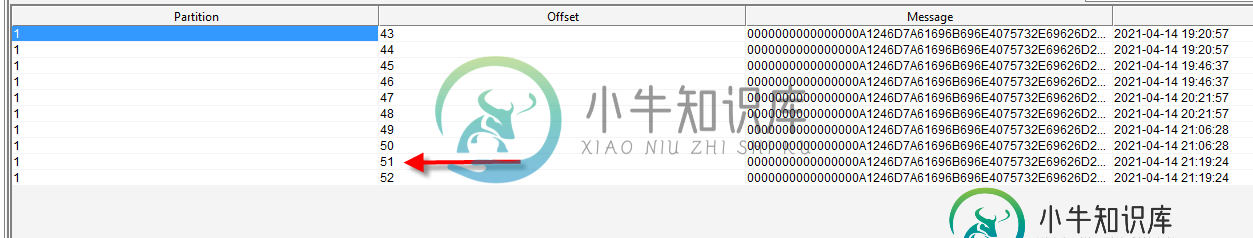

消费者不会读取来自Kafka主题(Akka Stream Kafka)的消息

消费者不会读取来自Kafka主题(Akka Stream Kafka)的消息我们使用Akka流Kafka来生成和消费消息和Strimzi Kafka集群。以下是相关版本: 重构消息发出后,消费者停止工作。我们在主题中确实有一些信息,但消费者只是在无休止地等待。 以下是日志片段: 还有一些要点: 架构注册表配置正确且良好(否则生产者将无法工作)。 主题(和组协调器)很好,我可以通过这样的普通消费者消费消息: 这就是代码卡住的地方——我使用阻塞调用获取2条消息(甚至无法获取1

-

Kafka-Flink-Stream处理:是否有一种方法可以将输入文件重新加载到流处理中使用的变量中?

我们计划使用Flink处理来自kafka主题的数据流(Json格式的日志)。 但是对于这种处理,我们需要使用每天都在变化的输入文件,其中的信息可以完全改变(不是格式,而是内容)。 每当这些输入文件中的一个发生变化时,我们必须将这些文件重新加载到程序中,并保持流处理继续进行。 重新加载数据的方式与现在相同: 但是到目前为止,我还没有找到例子,也没有想出一种方法来触发流处理作业中的重新加载。 作为额外

-

stream.parallel()不更新spliterator的特性吗?

这个问题是基于这个问题的答案,stream.of和intstream.range之间的区别是什么? 这将按任何顺序生成如下内容: 因此,我希望属性已经被删除,原因是。但是,下面的代码也返回。 为什么不更改属性,并且由于打印了所有四个数字,那么即使sorted属性仍然存在,Java又如何知道流没有排序呢?

-

stream.foreach中的java 8局部变量[重复]

我想在lambda函数中使用局部变量,但我得到错误:请参见1。和2。代码中的点。

-

如果Flux stream数据具有错误状态,如何返回不同的ServerResponse

我正在使用WebFlux实现一个RESTendpoint,我在基本操作上没有任何问题,但是有一个操作我不知道如何管理。我想返回与事件对象相关的PriceMessage对象,所以如果事件存在,endpoint返回一个ServerResponse.ok(),但是如果事件不存在,应该返回一个ServerResponse.not发现()。 在存储库层中,如果存在eventId为的代码和事件,则有以下方法返

-

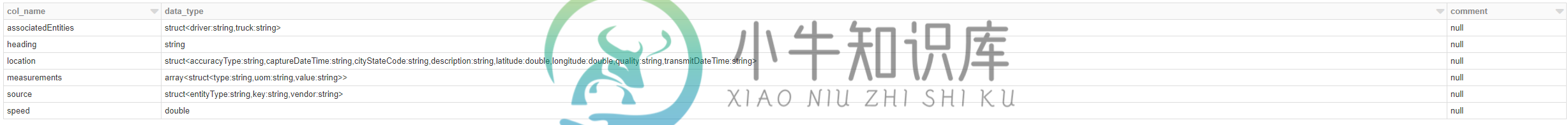

Spark Structured Streaming Databricks事件中心模式定义问题

Spark Structured Streaming Databricks事件中心模式定义问题现在,我试图做相同的架构在Streread上。 当我在笔记本中运行此单元格时:15:错误:简单表达式val jsonSchema=StructType([StructField(“associatedEntities”,struct,True),”的非法开始 编辑:目标是将数据放入数据框中。我可以从event hub消息的主体中获取json字符串,但如果无法使模式正常工作,我不确定该怎么做。

-

基于谓词[duplicate]的Java 8 Stream indexOf方法