《stream》专题

-

Spring-Cloud-StreamKafka

我已经建立了一个生产者Spring云流应用程序和Kafka作为活页夹。以下是application.yml: 我有两个实例(同一个应用程序运行在一个jvm上)作为消费者。以下是application.yml: 我对Kafka群体的理解是,对于同一群体中的消费者来说,消息只会被消费一次。假设生产者应用程序产生消息A、B,而同一组中有两个消费者应用程序,则消息A将由消费者1读取,消息B、C将由消费者2

-

如何使用Java 8 Streams以特定的方式实现zip?

我试图弄清楚如何使用Streams API实现一个zip函数,该函数以无限多的int[]作为参数;从每个元素中获取i'th元素;将它们放在一个元组中(显然需要一个自定义的元组对象-我有),并返回一个元组列表(即list)。 本质上,为: 建议的方法应该以java的形式返回:。util。列表 这是一个函数,它以“正常”的方式完成了我试图做的事情:

-

Streamparse wordcount示例

-

Spring Cloud Stream Kafka的Azure事件中心连接问题

-

如何在java中使用stream()迭代列表时向string追加值

我需要在Java8中迭代一个列表并将值追加到StringBuilder中。我已经编写了下面的代码,它正在工作,但是我需要使用map/stream等来迭代列表,而不是使用forEach循环。 我有另一个列表和地图,如果元素列表与地图的键匹配,我需要替换一个字符串。 如何使用Java8的map()/stream()等功能而不是forEach循环迭代相同的代码?

-

Java 8 Streams:如何调用一次集合。方法并检索多个聚合值的数组[重复]

我从8Java的Stream API开始。 这是我使用的Person对象: 这是我的代码,它初始化对象列表Person并获取对象的数量、最大年龄和最小年龄,最后创建一个包含这三个值的对象数组: 是否可以对方法进行一次调用并直接返回对象数组?

-

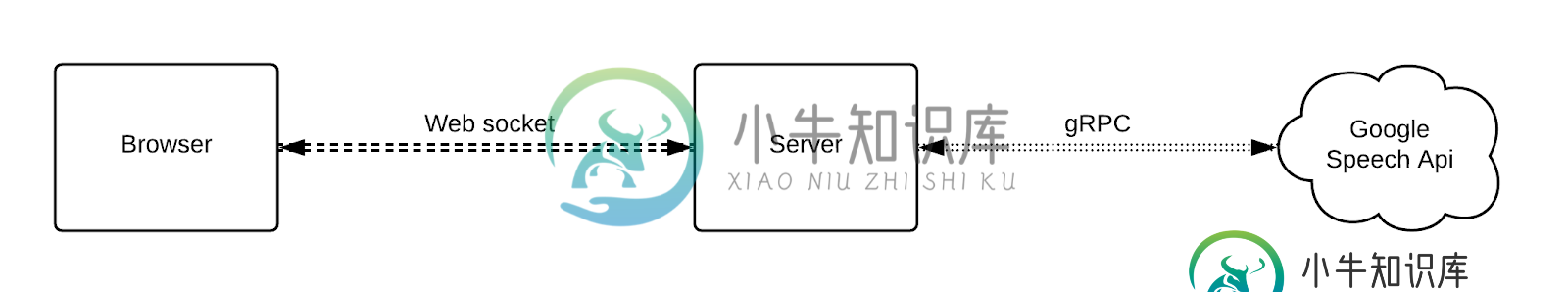

如何在Google语音到文本API中处理多个StreamingRecognite请求?

如何在Google语音到文本API中处理多个StreamingRecognite请求?我用谷歌语音对文本API构建了一个基于web的语音对文本应用程序。 应用程序流程: 从浏览器获取音频流 将音频数据流式传输到语音识别服务并在我们的用户说话时获得实时结果 我在应用程序中引用了示例代码,streamingRecognize请求与signal客户端调用完美配合,我的服务器可以从googlespeechapi接收临时转录结果。然而,当同时有多个客户端调用StreamingRecognit

-

使用Java Stream API对BigDecimals进行分组和相加

我有一个对象列表。它们都有一个。我想对它们进行分组,并将字段加起来。 对于本例:

-

等效于使用自定义比较器的stream distinct

如果我有以下列表: 并应用以下(Java8): 然后我会得到一个带有“Hello”和“World”的列表。

-

我如何使用Stream API合并然后区分集合?[副本]

我如何合并和消除列表的重复,以便得到的列表应该是包含“a”,“b”,“c”,“d”的MyObjects? 注意:这是对我们实际需要进行重复数据删除的方法的简化,这些方法实际上是hibernate加载的实体的复杂DTO,但是这个示例应该充分展示了目标。

-

使用StreamingFileSink到s3时,Flink fs s3阴影Hadoop:KerberosAuthException

我们正在尝试使用StreamingFileSink写入S3桶。这是一个简单的工作,从Kafka读到S3。s3的凭据在flink集群中配置。我们使用的Flink1.7.2没有预绑定的Hadoop。正如文档中所建议的,我们已经将flink-s3-fs-hadoop jar添加到flink集群的lib目录中。当我们运行作业时,我们会得到这个特殊的Kerberos异常。我们做错了什么?我们是否缺少任何配置

-

Apache Flink-从另一个Stream的MapFunction访问WindowedStream的内部缓冲区

我有一个基于Apache Flink的流媒体应用程序,具有以下设置: < li >数据源:每分钟生成数据。 < li >使用CountWindow的窗口流,size=100,slide=1(滑动计数窗口)。 < li>ProcessWindowFunction对窗口中的数据应用一些计算(比如F(x))。 < li >使用输出流的数据接收器 这很好。现在,我想让用户能够提供一个函数G(x ),并将其

-

如何使用Redis streams的背压?

我是否遗漏了什么,或者没有办法用Redis streams产生反压力?如果生产商将数据推送到流中,消费者可以更快地使用数据,那么没有明显的方式向生产商发出信号,表明它应该停止或放慢速度。 我预计会有一个阻塞版本的,它会阻塞客户机,直到空间在一个有限制的流中变为可用(类似于的阻塞版本,它允许用户等待数据变为可用),但情况似乎并非如此。 人们如何应对上述情况- 我知道一些数据流系统,比如Kafka,不

-

如何在redis stream中高效地使用XRange获取多条记录

查看Redis流并在流上建立索引(就像EventStore一样),这非常有效,我可以在流中获得大量条目,但我找不到一种很好的方法来按id返回所有记录,例如像MGET。这是我看到的东西的简化版本。 显然,这是非常低效的,我想知道是否有一些方法可以在1个请求中从服务器获取此信息。 我还考虑过流构建其他流,但它会导致消息重复,我们的消息可能会变得很大。是的,我可以把所有的信息放在一个集合中,但是两个级别

-

为什么Java Streams min方法不接受空值,即使使用的比较器是空友好的?

我试图用lambdas计算一些值之间的最小值。这些值可能包含空值,这在我的业务案例中是正常的,因为它们代表间隔限制。例如,如果我有下一个区间,我想检查值之间的最小区间边界,我希望结果是(作为商业案例规则,null应该被视为无穷大的等价物)。 我尝试用流实现这个,但是我注意到Stream类中的min方法不能用于这样的场景。 原因在min方法Javadoc“Throws:NullPointerExce