《数据库》专题

-

kafaka 生产数据时数据的分组策略

本文向大家介绍kafaka 生产数据时数据的分组策略相关面试题,主要包含被问及kafaka 生产数据时数据的分组策略时的应答技巧和注意事项,需要的朋友参考一下 生产者决定数据产生到集群的哪个 partition 中 每一条消息都是以(key,value)格式 Key 是由生产者发送数据传入 所以生产者(key)决定了数据产生到集群的哪个 partition

-

PyTorch数据集/数据加载程序批处理

对于在时间序列数据上实现PyTorch数据管道的“最佳实践”,我有点困惑。 我有一个HD5文件,我使用自定义DataLoader读取。似乎我应该返回数据样本作为一个(特征,目标)元组,每个元组的形状是(L,C),其中L是seq_len,C是通道数-即不要在数据加载器中预制批处理,只需返回一个表。 PyTorch模块似乎需要一个批处理暗淡,即。Conv1D期望(N,C,L)。 我的印象是,类将预先处

-

Spark数据集/数据帧连接空倾斜键

使用Spark Dataset/DataFrame联接时,我面临长时间运行且OOM作业失败的问题。 以下是输入: ~10个不同大小的数据集,大部分是巨大的( 经过一番分析,我发现作业失败和缓慢的原因是歪斜键:当左侧有数百万条记录时,用连接键。 我用了一些蛮力的方法来解决这个问题,这里我想和大家分享一下。 如果您有更好的或任何内置的解决方案(针对常规Apache Spark),请与他人分享。

-

第四章-数据序列化和模块数据

Most Odoo configurations, from user interfaces to security rules, are actually data records stored in internal Odoo tables. The XML and CSV files found in modules are not used to run Odoo applications

-

CX_Oracle-将数据从Oracle导入到Pandas数据框

问题内容: Hy 我是python的新手,我想使用此简单查询将一些数据从Oracle数据库导入python(pandas数据框) 我做了什么 但是我有这个错误 我做错了什么? 谢谢 问题答案: 您需要正确引用SQL查询。如果您查看问题(或IDE)中突出显示的语法,则会注意到单引号没有按预期工作。 将最外面的引号更改为双引号-如果要在一行上全部使用-或将三引号更改为多行:

-

原始数据导出器和嵌套数据表

我在另一个数据表中使用一个数据表。当我尝试使用数据导出器导出(任何格式)时,我得到了类似于:“”而不是内部数据表值。 这是数据导出器的限制吗?我必须实现这个扩展数据导出器的功能?有其他选择吗?

-

layui实现数据表格自定义数据项

本文向大家介绍layui实现数据表格自定义数据项,包括了layui实现数据表格自定义数据项的使用技巧和注意事项,需要的朋友参考一下 layui是一个很适合后台开发人员用的一个前端框架,界面简洁,功能丰富。 大家知道,系统一般都有数据表格及分页功能,尤其在后台管理系统之类,这类场景更是很多,layui也为我们提供了对应的支持,我这里要说的是,layui对异步返回的数据默认是有一套格式的,像下面这样

-

使用Google云数据流SDK读取流数据

我正在开发一个物联网应用程序,需要从PubSub主题读取流数据。我想使用Google云数据流SDK读取这些数据。我正在使用Java 1.8 我正在使用谷歌云平台的试用版。当我使用PubSubIO时。Read方法读取流数据时,我在日志文件中发现错误,我的项目没有足够的CPU配额来运行应用程序。 所以我想使用谷歌云数据流SDK读取流数据。 请有人告诉我在哪里可以找到使用Google Cloud Dat

-

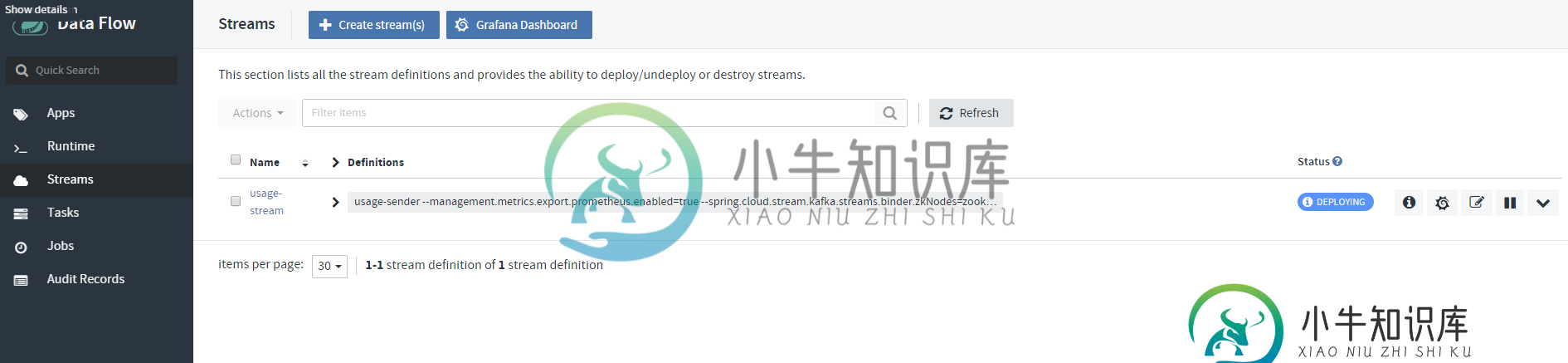

Spring云数据流Grafana Prometheus未显示流数据

Spring云数据流Grafana Prometheus未显示流数据我在这个网站上用docker compose启动了Spring云数据流。 https://dataflow.spring.io/docs/installation/local/docker/ 我创建了3个应用程序,源,处理器 我跑了 当我运行docker compose-f时/docker编写。yml-f/docker创作普罗米修斯。yml,所有我的容器都按照docker compose中的指定启

-

小图像数据集的数据增强技术?

目前,我正在用深度CNN训练类似Flickrlogos-32的小型标志数据集。为了训练更大的网络,我需要更多的数据集,因此使用增强。我现在做的最好的是使用仿射变换(特征归一化、特征中心化、旋转、宽度高度移位、水平垂直翻转)。但对于更大的网络,我需要更多的增强。我试着在Kaggle的国家数据科学碗的论坛上搜索,但没有得到多少帮助。这里给出了一些方法的代码,但我不确定哪些方法是有用的。除了仿射变换之外

-

火花2。x数据帧或数据集?[副本]

我的理解是Spark 1之间的一个重大变化。x和2。x是从数据帧迁移到采用更新/改进的数据集对象。 但是,在所有Spark 2. x文档中,我看到正在使用,而不是。 所以我问:在Spark 2. x中,我们是否仍在使用,或者Spark人员只是没有更新那里的2. x文档以使用较新的推荐的?

-

从行索引的数据帧索引数据帧

我有两个形状相同的python数据帧,例如: 我想使用df2中的值作为行索引来选择df1中的值,并创建一个形状相等的新数据帧。预期结果: 我已尝试使用.loc,它在单个列中运行良好: 但是我不能同时在所有列上使用. loc或. iloc。我想避免循环来优化性能,因为我正在处理一个大数据帧。有什么想法吗?

-

如何检查数据透视表中的数据?

我有一个和模型,其中有一个名为的数据透视表。在透视表中,当用户按下“参与”按钮时,会保存和。 我已经显示了所有的事件列表。现在我想显示作为参与而不是作为参与而参与的事件。 我试过控制器 刀片文件 我已经在和模型中设置了关系。 这段代码的问题是第二个foreach循环是pivot表循环。假设透视表中有一个数据。我列出了5个事件。由于pivot table foreach(第二个)的缘故,刀片文件中只

-

发布/发送csv数据到数据流到BigQuery

我的管道是IoTCore->pub/sub->Dataflow->bigQuery。最初,我得到的数据是Json格式的,管道工作正常。现在我需要转向csv,问题是我使用的Google定义的数据流模板使用Json输入而不是csv。是否有一种简单的方法通过数据流将csv数据从pub/sub转移到bigquery。模板可能会改变,但它是用Java实现的,我从来没有用过,所以需要很长时间来实现。我还考虑过

-

使用python将数据块数据帧写入S3

我有一个名为df的数据库数据帧。我想将它作为csv文件写入S3存储桶。我有S3存储桶名称和其他凭据。我检查了这里给出的在线留档https://docs.databricks.com/spark/latest/data-sources/aws/amazon-s3.html#mount-aws-s3它说使用以下命令 但我有的是数据帧,而不是文件。怎么才能实现?