《吉利控股》专题

-

postgresql 利用xlog进行热备操作

本文向大家介绍postgresql 利用xlog进行热备操作,包括了postgresql 利用xlog进行热备操作的使用技巧和注意事项,需要的朋友参考一下 一、验证postgresql增量合并的方案 结果:没有有效可行的增量合并方案,暂时放弃 二、梳理postgresql基于wal的增量备份 物理备份与还原适用于跨小版本的恢复但是不能跨平台 逻辑备份与还原备份数据适用于跨版本和跨平台的恢复 pos

-

如何充分利用OpenCL中的SIMD?

在北网的优化指南中,针对英特尔GPU的OpenCL开源实现 工作组大小应大于16,并且是16的倍数。 Gen上有两个可能的SIMD车道是8或16。为了不浪费SIMD车道,我们需要遵循这个规则。 英特尔处理器图形Gen7.5的计算架构中也提到: 对于Gen7。基于5个产品,每个EU有7个线程,总计28 KB的通用寄存器文件(GRF)。 。。。 在Gen7上。5计算架构,大多数SPMD编程模型都采用这

-

如何利用MongoDB图集连接MongoDB

MongoDB连接错误MongoNetworkError:在第一次连接[MongoNetworkError:到Cluster0-Shard-00-00-C487Z.MongoDB.net:27017的连接5已关闭......]时连接到服务器[Cluster0-Shard-00-00-C487Z.MongoDB.net:27017]失败 这是我的代码。

-

为什么程序不计算利息?

它以年为单位正确地显示了图表。但年末的存款金额(a)保持不变(1000); 直到利率达到10%。

-

意大利语命名实体识别

我想使用NLP工具从意大利文本中提取名称和数字。 遗憾的是,斯坦福德NLP和Apache OpenNLP都没有为意大利人提供模型。 我能找到一个,或者找到训练数据来制造一个吗?(至少15000句)

-

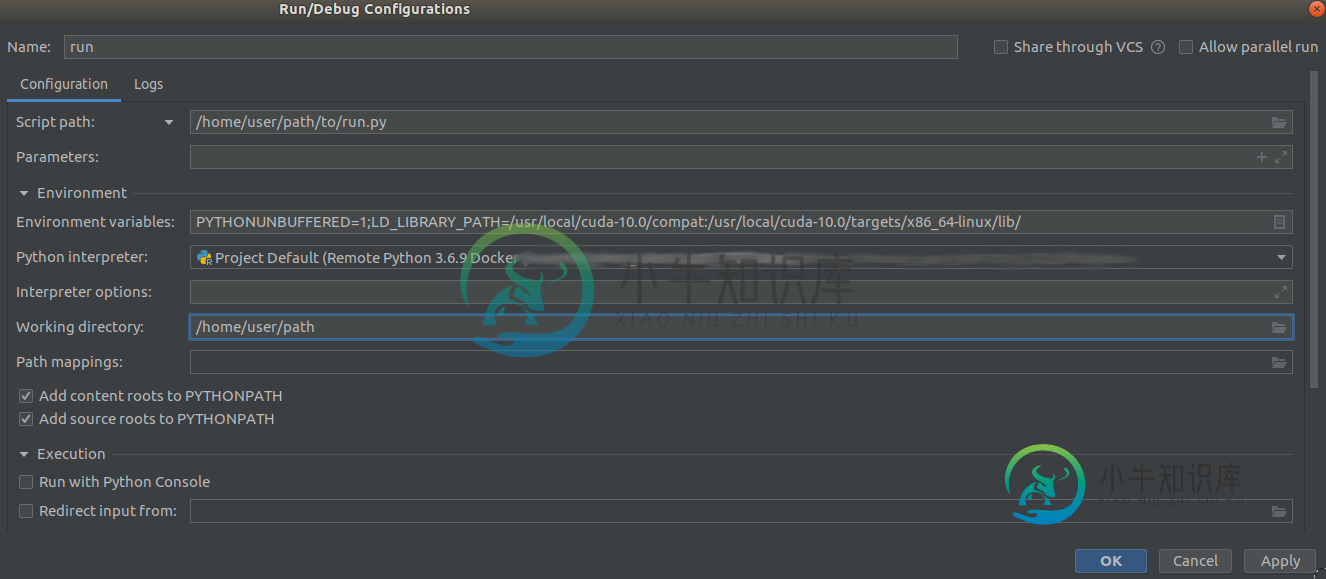

利用docker和GPU进行Pycharm调试

利用docker和GPU进行Pycharm调试在PyCharm中调试一个Python应用程序,其中我使用Tensorflow将解释器设置为自定义docker映像,因此需要GPU。问题是,据我所知,Pycharm的命令构建没有提供一种发现可用GPU的方法。 使用以下命令输入容器,指定要使哪些GPU可用(): 在容器内,我可以运行查看是否找到GPU,并确认Tensorflow找到了它,使用: 如果我不使用标志,就不会发现GPU,这是预期的。注意:

-

PHP莫利支付经常性账单

我的代码是: 结果是: 致命错误:未捕获异常'Mollie\Api\Exceptions\ApiExc0019',消息'执行API调用错误(422:不可处理实体):没有找到适合客户的任务。字段: CusterId. 我错过了什么吗??

-

拉维全向支付莫利错误

我试图在我的网站上与Onmipay Mollie和Barryvdh Laravel Omnipay建立一个支付系统 当我想付款时,提交用于付款的表格。我得到一个错误: 我的路由文件: 和我的PurchaseController: Paymenturl视图: 有什么东西不见了吗?我整个周末都在忙这个,但没有成功。有人能告诉我出了什么事吗? 仅供参考:我正在本地主机上执行此操作。不知道这是否有问题(不

-

Tic Tac Toe确定胜利者算法

我在C和一般编程方面是个新手,我想知道这段代码的性能/复杂性有多好,因为它与我在SO的其他帖子中发现的不同。for循环是否使这变得不必要的复杂?

-

JVM中的老一代空间利用

据我所知,对于旧一代JVM中的空间,它可以用于两个目的, 用于从年轻一代升级到老一代的物品 用于特殊用例中的新对象分配(https://stackoverflow.com/questions/9053144/will-i-encounter-java-lang-outofmemoryerror-even-with-no-lack-of-memory) 我的问题是, 在老一代中,是否还有其他利用空间

-

利用HTML表创建发票设计

我试图在一个简单的HTML表中创建一个发票设计。我尽了最大的努力,但我无法创建HTML的设计。我是HTML的初学者,甚至阅读了W3School中的所有章节。但我不知道我是如何在HTML中设计这个的?我尝试了下面的代码,但它不是预期的。当我附上图像时,html标签设计的代码是什么? null null HTML中的预期图像表

-

Android Studio利布格德克斯动画

每当我的角色跳跃时,我都会尝试做一个动画。它的工作方式如下:当我跳跃时,我首先绘制我的char的动画。如果完成了,我开始修改他的位置,并绘制另一个纹理,用于inAir时刻。问题是动画立即运行(我尝试将速度设置为每秒1帧,但它仍然立即运行),并且角色在动画完成之前就跳跃了。我怀疑它在实际完成之前就认为它完成了。这是我检查动画是否完成的方法:首先我检查动画是否开始(跳转按钮被按下),然后我有一个这样的

-

利用向量的gsl线性拟合

我已经从一个gsl拟合示例开始,并尝试将数组改为向量。但是当我编译我的代码时,它导致了这样一个错误,我不理解,也不知道我的代码有什么问题,我感谢任何事先的评论: 示例1.cpp:19:73:错误:无法将参数“1”的“std::vector”转换为“const double*”,转换为“int gsl_fit_linear(const double*,size_t,const double*,siz

-

Quarkus。负载测试和内存利用

我创建了一个简单的服务,它执行4个HTTP调用和4个db调用来收集一些数据,并将其作为< code>JSON传递给< code>HTTP响应。 当我启动应用程序(本机,没有docker)时,我看到它消耗,有时,有时30MB。好。 当我开始加载测试它时,每10毫秒发送1个请求,总共100个请求。 我注意到内存消耗立即达到200MB。然后经过5-6次以上的测试到400MB。(就像Spring启动版本一

-

MATLAB中利用randn生成随机数

或者有什么方法可以指定这些值应该位于平均值加/减1 SD之间?