《烽火通信》专题

-

使用Apache火花1.6使用共享配置2和共享beanutils-1.9

我的应用程序正在使用commons-configuration2和commons-beanutils1。9,但当我尝试将我的应用程序JAR用于spark流媒体作业时,它引发了以下异常。 java.lang.NoSuchmethod odError:org.apache.commons.beanutils.Properties tyUtilsBean.addBean内向者(Lorg/apache/c

-

火花纱集群vs客户机-如何选择使用哪一个?

spark文档中有以下段落描述了yarn客户机和yarn集群之间的区别: 有两种部署模式可用于在Yarn上启动Spark应用程序。在集群模式下,Spark驱动程序运行在由集群上的YARN管理的应用程序主进程中,客户端可以在启动应用程序后离开。在客户端模式下,驱动程序在客户端进程中运行,应用程序主程序仅用于从YARN请求资源。

-

火花+卡珊德拉。带聚类顺序问题的复合密钥

我有C*列族来存储类似事件的数据。以这种方式在CQL3中创建的列族: null 提前谢谢你。

-

Linux下设置防火墙白名单(RHEL 6和CentOS 7)的步骤

本文向大家介绍Linux下设置防火墙白名单(RHEL 6和CentOS 7)的步骤,包括了Linux下设置防火墙白名单(RHEL 6和CentOS 7)的步骤的使用技巧和注意事项,需要的朋友参考一下 进入Linux 命令行,编辑防火墙规则配置文件 iptables vi /etc/sysconfig/iptables 下面是一个白名单设置的例子: 其中设置白名单的部分为: 使用白名单规则使用 j

-

Docker高级教程之智能添加与修改防火墙规则

本文向大家介绍Docker高级教程之智能添加与修改防火墙规则,包括了Docker高级教程之智能添加与修改防火墙规则的使用技巧和注意事项,需要的朋友参考一下 资料简介:如果你有以下痛苦: 1、使用默认docker0桥接方式; 2、修改防火墙规则的话,使用手动修改配置; 3、并且修改时候还得计算来源端口,防止重复端口使用户登陆错误容器; 4、并当容器意外重启,内网ip变化后还得修改规则 那么你可以看看

-

代码点火器更新不能立即在服务器上工作

我正面临着一个相当奇怪的问题... 我正在使用CodeIgniter和MySQL开发一个Yellowpages网站。在我的本地机器上一切正常,但当我上传到我的服务器时,我面临一个问题。 唯一的问题是: 当我进行一些更改并按下更新按钮时,更改会立即显示在视图中(还检查了它是否在数据库中得到更新)。但是,如果我在5-10秒内再次按下“编辑”按钮,更改将撤消。 最有趣的事实是,即使我用旧的更改按upda

-

获取错误NoClassDefFoundError:org。阿帕奇。火花内部的登录Kafka Spark Stream

我在运行时通过运行下面的java代码得到一个错误, 日志记录是否需要包含任何依赖项,例如log4js或其他东西? 为什么编译时不出现这个错误,这样更容易... 这是我的Java代码, 依赖项使用, 获取以下错误,

-

NoSuchElementException火花流查询中的错误,尽管集群配置很重

有人能帮我理解这个错误背后的原因吗: 群集配置为: 数据库运行时5.5 LTS Scala 2.11 Spark 2.4.3 驱动程序:64GB内存,16核,3DBU 工人:64GB mem,16核,3DBU(2-4个工人,自动扩展) fairscheduler中定义了3个并行运行的流式查询。xml Spark配置是: 在下面添加代码流: fairScheduler示例。xml文件:

-

如何在google容器引擎中为kubernetes集群创建防火墙

这可能是一个非常简单的问题,但我似乎不知道如何只允许从我的office IP访问我的kubernetes集群。 在我的防火墙规则中,我看到我的gke节点规则是2个内部ip和我的office ip。 我还看到了我在外部IP地址中看不到的外部IP范围的防火墙规则。该IP地址也不会出现在我的负载均衡器IP中...... 最后,我有一个负载平衡防火墙规则,它允许负载平衡选项卡中的外部IP范围,这是我的ku

-

带有滞后窗口函数的火花任务不可串行化

我注意到,当我在DataFrame上使用窗口函数后,如果我用函数调用map()时,Spark会返回一个“Task not serializable”异常这是我的代码: 这是堆栈跟踪: 异常:任务不可序列化在org.apache.spark.util.ClosureCleaner$.EnsureClealizable(ClosureCleaner.scala:304)在org.apache.spar

-

在火花中加入两个数据帧,只返回一个匹配

我有两个这样的数据帧: DF1: DF2: 当我left_outer或内连接df1和df2时,我希望得到的数据帧如下: 当我加入时,id 1是c1、c2还是c3并不重要;但我只需要一张唱片。 请让我知道如何才能在火花中实现这一点。 谢谢你,约翰

-

带序列化的Scala反射(过火花)-符号不可序列化

首先,我使用的是scala 2.10.4,上面的例子是在Spark 1.6中运行的(尽管我怀疑Spark与此有关,但这只是一个序列化问题)。 所以我的问题是:假设我有一个trait,它由两个类实现,比如说和。现在,我有一个泛型特征,它由一组类扩展,其中一个类位于的子类型之上,例如(这里我保留了Spark对RDD的概念,但一旦序列化,它实际上可能是另一个类;不管实际情况如何,它都只是一个结果): 现

-

火花中的任务是什么?Spark worker如何执行jar文件?

在阅读了http://spark.apache.org/docs/0.8.0/cluster-overview.html上的一些文档之后,我得到了一些我想澄清的问题。 以Spark为例:

-

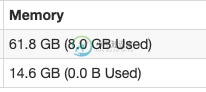

docker中的火花,为驱动程序/执行程序设置内存

docker中的火花,为驱动程序/执行程序设置内存我在一个单独的Docker中运行spark-master和spark-worker。 我能看见他们在跑 PS-EF grep火花根3477 3441 0 1 05?00:04:17/usr/lib/jvm/java-1.8-openjdk/jre/bin/java-cp/usr/local/spark/conf/:/usr/local/spark/jars/*-xmx1g org.apache.s

-

火花DF。选择返回带有标题的csv的不正确列

我正在实现Spark数据源API v1的buildScan方法。 我正在尝试读取一个带有标题的。csv文件。 但是buildScan()内部的df.show返回正确的列。 我无法找到列映射到底哪里出错了。