《烽火星空》专题

-

Tensorflow火车。py抛出Windows致命异常

我已经和Tensorflow合作了很长一段时间,有一些问题,但它们从来没有解决过。今天,当事情变得有趣时,我想训练一个新的模型。起初,训练在一步之后无缘无故地停止了。它以前发生过,打开一个新的cmd窗口解决了它。这次不难。在我再次尝试之后,我开始训练。py开始抛出这个: Windows致命异常:访问违规 当前线程0x000018d4(最新调用优先): 文件“C:\windows\system32\

-

每周特定日期的火灾报警

我正在制作一个应用程序,让用户选择几天,并在这些天的特定时间启动警报。 让我们以我的问题为例,我希望我的闹钟在每周五12:30触发,问题是它从来没有触发过闹钟,即使我在同一天,这是我的代码

-

带有火花流集成错误的kafka

我不能用火花流运行Kafka。以下是我迄今为止采取的步骤: > 将此行添加到- Kafka版本:kafka_2.10-0.10.2.2 Jar文件版本:spark-streaming-kafka-0-8-assembly_2.10-2.2.0。罐子 Python代码: 但我仍然得到以下错误: 我做错了什么?

-

Pyspark无法初始化火花上下文

我正在尝试使用spark submit server2运行spark程序。py——主本地[2]。然后我得到了这个错误: 以下是我正在运行的代码: 谁能帮我一下我做错了什么。我试过这篇文章中的解决方案无法初始化spark上下文,但它不起作用。

-

NPE当运行arquillian对远程野火-8.0.0

昨天,当我尝试将集成测试从嵌入式 GF 4 移动到远程 Wildfly 8 时,对于针对远程 Wildfly 8 实例运行的每个 arquillian 测试,我都得到了奇怪的 。同样的集成测试在嵌入式玻璃鱼4.0上工作得很好。 我的测试用例非常简单(使用单个类部署),不需要在这里发布 使用的组件: 阿奎利安 1.1.5.决赛 野蝇 8.0.0.最终版 日食月神 无论以什么方式启动我的测试用例(从E

-

从火花中读取结构在 scala 中

我正在运行以下scala代码: 我知道firstStruct是structType,StructFields的一个名称是“name”,但在尝试强制转换时似乎失败了。我被告知spark/hive结构与scala不同,但为了使用structType,我需要 所以我想他们应该是同一种类型的。 我看了看这里:https://github.com/apache/spark/blob/master/sql/c

-

保存为拼花文件在火花java

我是Spark的新手。我尝试在本地模式(windows)下使用spark java将csv文件保存为parquet。我得到了这个错误。 原因:org.apache.spark.Spark异常:写入行时任务失败 我引用了其他线程并禁用了spark推测 set("spark.speculation "," false ") 我还是会出错。我在csv中只使用了两个专栏进行测试。 输入: 我的代码: 请帮

-

火花流句柄 倾斜的Kafka分区

场景: Kafka- 每个火花流微批次中的逻辑(30秒):< br >读取Json- 我的流媒体工作是阅读大约1000个Kafka主题,大约有10K个Kafkapartitions,吞吐量大约为500万事件/秒。 问题来自 Kafka 分区之间的流量负载不均匀,一些分区的吞吐量大约是较小分区的 50 倍,这会导致 RDD 分区倾斜(因为 KafkaUtils 创建了从 Kafka 分区到 Spar

-

不允许火花操作:alter table replace columns

https://docs.databricks.com/spark/latest/spark-sql/language-manual/alter-table-or-view.html#replace-columns

-

火花:用数组加入数据框列

我有两个包含两列的DataFrames > <code>df1</code>,带有架构<code>(键1:长,值)</code> <code>df2</code>,带架构<code>(键2:数组[Long],值)</code> 我需要在键列上连接这些DataFrames(查找和中的值之间的匹配值)。但问题是它们的类型不同。有办法做到这一点吗?

-

不能启动所有的火花工人

这是第二个显然未能启动的工人的日志: Spark命令:/usr/lib/jvm/java-8-openjdk-amd64/bin/java-cp/media/ahmedn1/ahmedn12/Spark/conf/://media/ahmedn1/ahmedn12/Spark/jars/* 17/08/30 12:19:34信息工作者:启动进程名为:28819@Ahmedn1-Inspiron-5

-

基于Spark版本的火花负载罐

我们希望以版本不可知的方式为我们的spark作业加载< code > org . Apache . spark:spark-avro _ 2.12 包。 有的人在用火花3.1.2,有的人在用3.2.0。 对于3.1.2上的那些,我需要加载: 对于3.2.0上的,我需要加载: 我是否可以实现一种通用机制来根据火花版本加载正确的jar,而无需我的用户在他们那端做任何事情? 我不介意在本地保存所有版本的

-

组织。openqa。硒。火狐。启动Firefox时NotConnectedException

我在尝试启动浏览器时收到此错误消息: org.openqa.selenium.firefox.NotConnected异常:45000 ms后无法连接到端口7055上的主机127.0.0.1。Firefox控制台输出: s":[],"hasEmbeddedWebExtense": false} 我使用的是和。

-

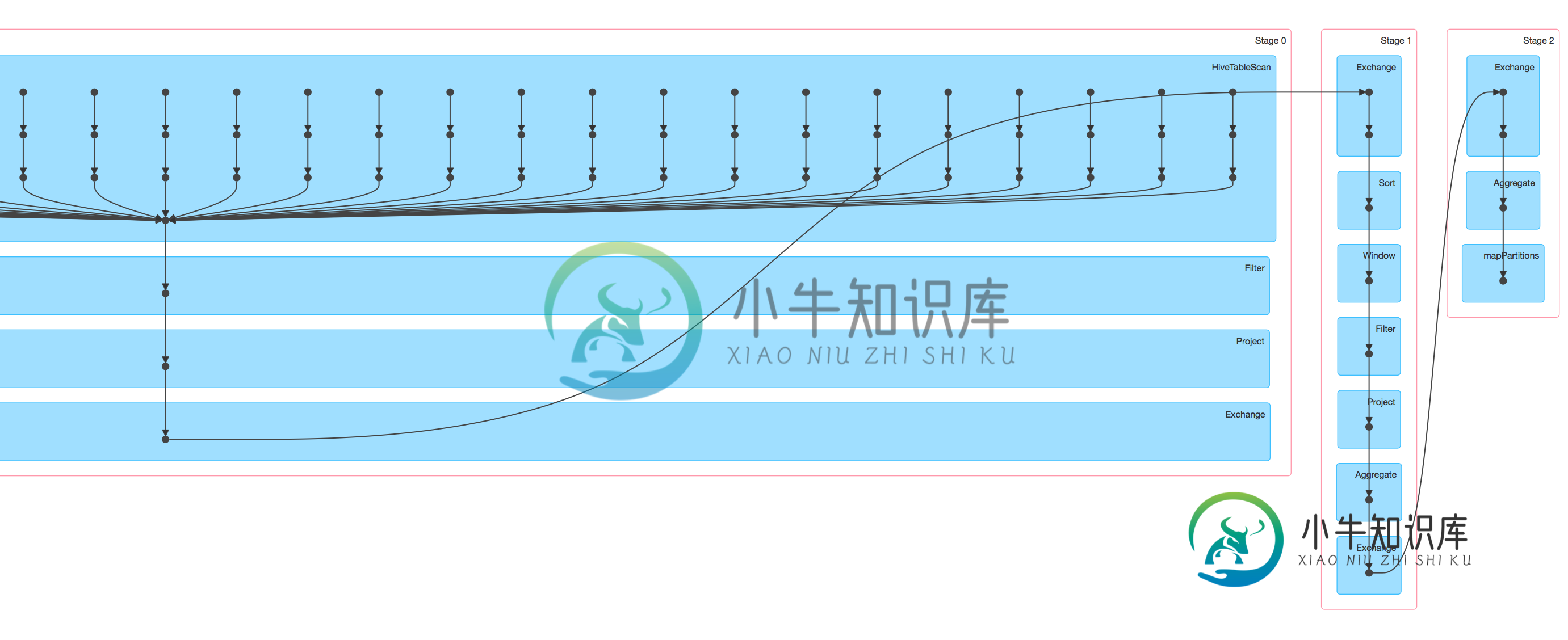

如何优化火花sql并行运行

如何优化火花sql并行运行我是spark新手,有一个简单的spark应用程序,使用spark SQL/hiveContext: 从hive表中选择数据(10亿行) 做一些过滤,聚合,包括row_number窗口函数来选择第一行,分组,计数()和最大()等。 将结果写入HBase(数亿行) 我提交的作业运行它在纱线集群(100个执行者),它很慢,当我在火花UI中查看DAG可视化时,似乎只有蜂巢表扫描任务并行运行,其余的步骤#

-

在火花 Scala UDF 中定义返回值

想象一下下面的代码: 如何定义myUdf的返回类型,以便查看代码的人立即知道它返回了一个Double?