《万科》专题

-

技术入股创业一年,家庭收入变成负5万

本文向大家介绍技术入股创业一年,家庭收入变成负5万,包括了技术入股创业一年,家庭收入变成负5万的使用技巧和注意事项,需要的朋友参考一下 一、技术入股的创业一年,家庭收入变成负5万 先说明,本人做技术出身,在外企的核心部门工作几年,总之一句话,技术通过朋友啊同事合作,基本上可以搞定。去年3月份跟一个人合作,对方投资100w,注册了个股份公司,本人占5%的股份,我个人没有实际出资,当时协商项目

-

利用python如何处理百万条数据(适用java新手)

利用python如何处理百万条数据(适用java新手)本文向大家介绍利用python如何处理百万条数据(适用java新手),包括了利用python如何处理百万条数据(适用java新手)的使用技巧和注意事项,需要的朋友参考一下 1、前言 因为负责基础服务,经常需要处理一些数据,但是大多时候采用awk以及java程序即可,但是这次突然有百万级数据需要处理,通过awk无法进行匹配,然后我又采用java来处理,文件一分为8同时开启8个线程并发处理,但是依然处

-

搜索成千上万文档(pdf和/或xml)的最佳做法

问题内容: 回顾停滞的项目,并在现代化成千上万的“旧”文档并通过网络提供文档方面寻求建议。 文档以各种格式存在,有些已经过时:(。 doc , PageMaker ,硬拷贝(OCR), PDF 等)。有资金可用于将文档迁移为“现代”格式,许多硬拷贝已被OCR转换为PDF-我们原本以为PDF是最终格式,但我们愿意接受建议(XML?) 。 一旦所有文档都采用通用格式,我们便希望 通过Web界面 提供和

-

SQL对数百万行重复删除查询以提高性能

问题内容: 这是一次冒险。我从上一个问题中的循环重复查询开始,但是每个循环将遍历所有 1700万条记录 , 这意味着将花费数周的时间 (使用MSSQL 2005,运行服务器需要4:30分钟)。我从这个站点和这个帖子中闪现了信息。 并已经到达下面的查询。问题是,对于任何类型的性能,这是否是对1700万条记录运行的正确查询类型?如果不是,那是什么? SQL查询: 问题答案: 看到QueryPlan会有

-

创建数百万个小型临时对象的最佳实践

创建(和发布)数百万个小对象的“最佳实践”是什么? 我正在用Java编写一个国际象棋程序,搜索算法为每一个可能的移动生成一个“移动”对象,一次标称搜索每秒可以轻松生成超过一百万个移动对象。JVM GC已经能够处理我的开发系统上的负载,但我有兴趣探索以下替代方法: 最小化垃圾收集的开销,以及 降低低端系统的峰值内存占用 绝大多数对象的寿命都很短,但生成的移动中约有1%是持久化的,并作为持久化值返回,

-

如何优化大多数出现的值(亿万行)的检索

问题内容: 我正在尝试从包含数亿行的SQLite表中检索一些最常出现的值。 到目前为止,查询可能如下所示: 该字段上有一个索引。 但是,使用ORDER BY子句,查询会花费很多时间,我从未见过它的结尾。 可以采取什么措施来大幅度改善对如此大量数据的此类查询? 我试图添加一个HAVING子句(例如:HAVING count> 100000)以减少要排序的行数,但是没有成功。 请注意,我不太在意插入所

-

如何在JdbcTemboard中使用获取大小来处理2000万行?

我有一个包含2000万行的表,由于,我无法使用单个查询选择所有行。我读到了属性,看起来它可能有助于解决我的问题,因为它是常见的建议 但我对如何应用它有疑问。 我有以下代码: 看起来jdbc驱动程序会为每个请求选择1000。但是我应该怎么做才能处理所有2000万行呢? 我应该调用jdbcTemplate吗。查询几次?

-

编写超过5000万从Pyspark df到PostgresSQL,最有效的方法

从Spark数据框到Postgres表格插入数百万条记录的最有效方法是什么?我在过去通过使用批量复制和批量大小选项也成功地从火花到MSSQL做到了这一点。 有没有类似的东西可以在这里为博士后? 添加我尝试过的代码以及运行流程所需的时间: 所以我做了上面的方法,1000万记录,并有5个并行连接,如中指定的,还尝试了200k的批量大小。 整个过程的总时间为0:14:05.760926(14分5秒)。

-

如何用apache spark处理数百万个较小的s3文件

注意:计数是对处理文件需要多长时间的更多调试。这项工作几乎花了一整天的时间,超过10个实例,但仍然失败,错误发布在列表的底部。然后我找到了这个链接,它基本上说这不是最佳的:https://forums.databricks.com/questions/480/how-do-i-ingest-a-large-number-of-files-from-s3-my.html 然后,我决定尝试另一个我目前

-

申万宏源产品经理国际业务部面试复盘

申万宏源产品经理国际业务部面试复盘一面 群面 一小时 三个候选人 三个面试官 ——基础问题 第一部分 个人英文自我介绍 一分钟 第二部分 自我评价(优缺点)及理想工作状态 第三部分 你了解到的产品经理完整的工作流程,详细说一下 ——业务问题 第一部分 如何理解国际业务 第二部分 如何理解前台如销售岗位与中台如产品设计岗位 第三部分 中台部门如何与前台部门合作推广一个产品 第四部分 所在实习券商公司有什么比较优势和不足 第五部分

-

用三千万影视剧字幕语料库生成词向量

对语料库切词 因为word2vec的输入需要是切好词的文本文件,但我们的影视剧字幕语料库是回车换行分隔的完整句子,所以我们先对其做切词,有关中文切词的方法请见《教你成为全栈工程师(Full Stack Developer) 三十四-基于python的高效中文文本切词》,为了对影视剧字幕语料库切词,我们来创建word_segment.py文件,内容如下: # coding:utf-8 import

-

RocketMQ每秒要写入几十万并发,是怎么实现的?

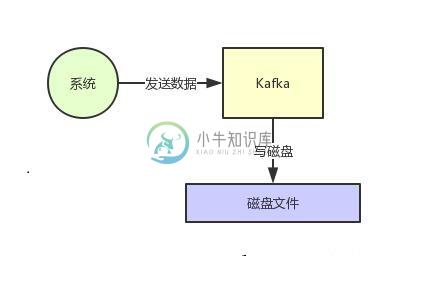

RocketMQ每秒要写入几十万并发,是怎么实现的?主要内容:1、页缓存技术 + 磁盘顺序写,2、零拷贝技术,3、最后的总结这篇文章来聊一下Kafka的一些架构设计原理,这也是互联网公司面试时非常高频的技术考点。 Kafka是高吞吐低延迟的高并发、高性能的消息中间件,在大数据领域有极为广泛的运用。配置良好的Kafka集群甚至可以做到每秒几十万、上百万的超高并发写入。 那么Kafka到底是如何做到这么高的吞吐量和性能的呢?这篇文章我们来一点一点说一下。 1、页缓存技术 + 磁盘顺序写 首先Kafka每次接收到数据都会往磁

-

mysql - MYSQL 统计二十九万条数据要13.96秒正常吗?

二十九万条数据要13秒多,是不是有点久?这个语句也没办法优化了吧?

-

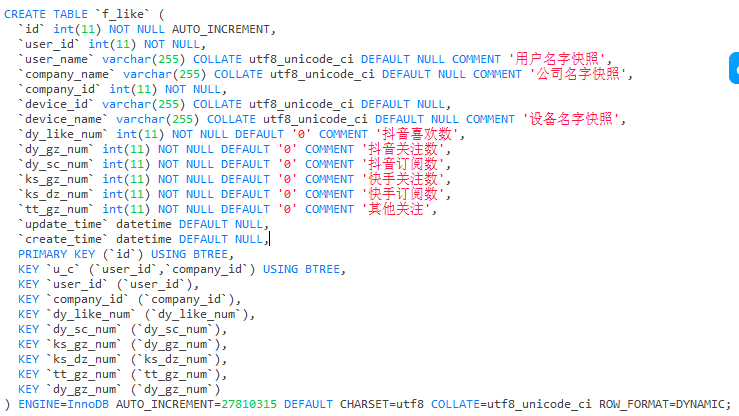

mysql sum多个字段千万级数据如何查询优化?

mysql sum多个字段千万级数据如何查询优化?统计数据表中多个sum千万级数据超时。由于业务需要实时 所以做不来快照表 我加了索引似乎也不管用 后来为了不联表 我直接把快照写入进去了

-

在Python 3中加速数百万个正则表达式的替换

问题内容: 我正在使用Python 3.5.2 我有两个清单 大约750,000个“句子”(长字符串)的列表 我想从我的750,000个句子中删除的大约20,000个“单词”的列表 因此,我必须遍历750,000个句子并执行大约20,000个替换,但前提是我的单词实际上是“单词”,并且不属于较大的字符串。 我这样做是通过预编译我的单词,使它们位于\b元字符的两侧 然后我遍历我的“句子” 这个嵌套循