《函数》专题

-

Spark Take函数

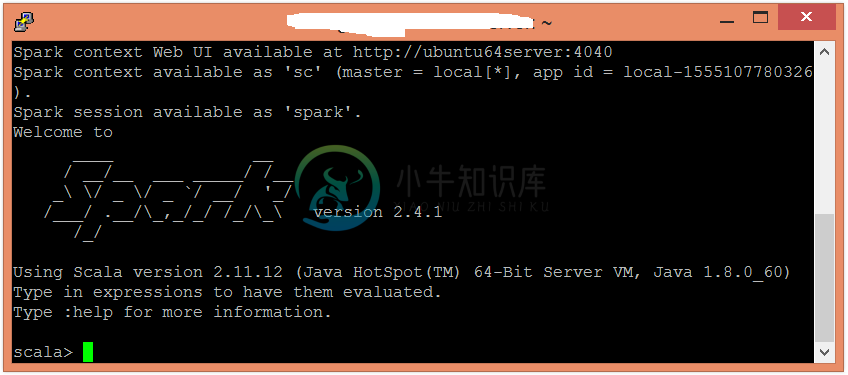

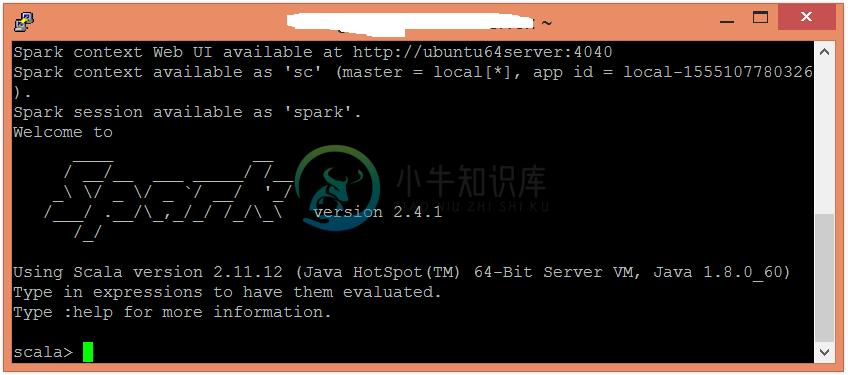

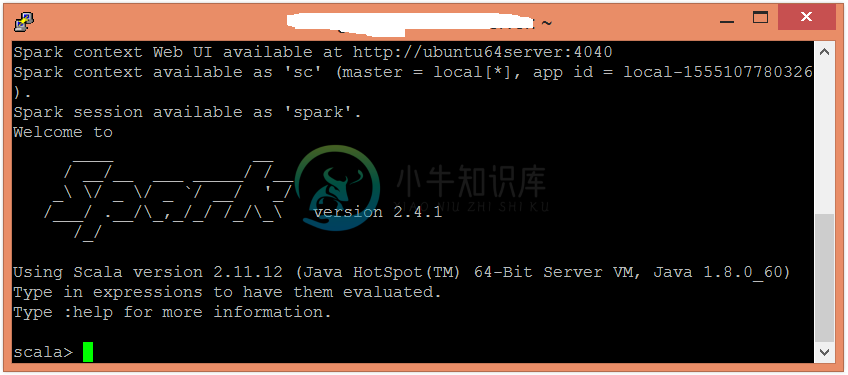

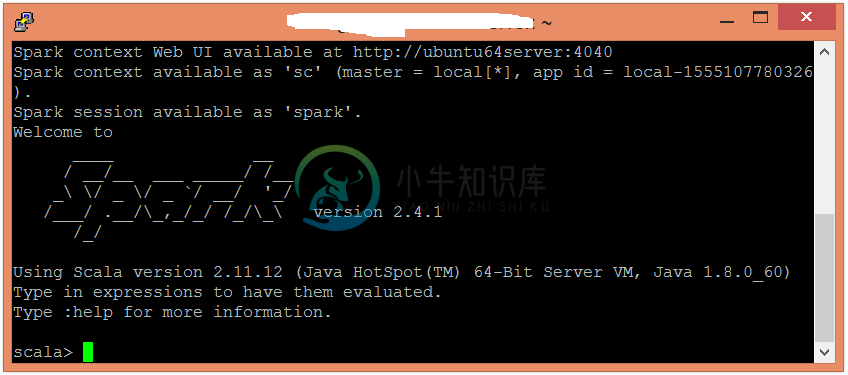

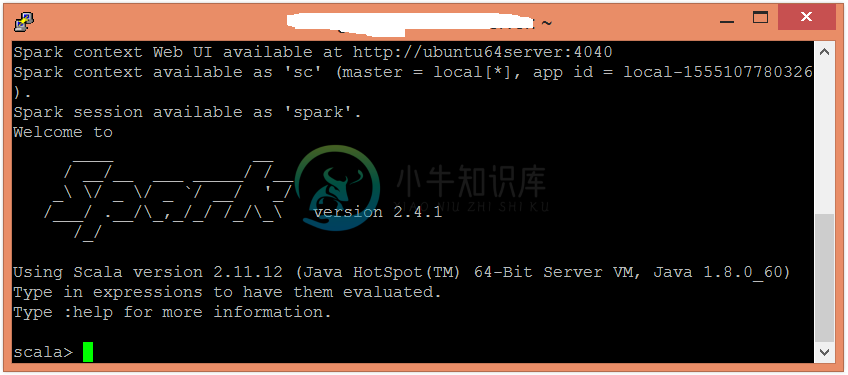

Spark Take函数主要内容:Take函数示例在Spark中,函数的行为类似于数组。它接收一个整数值(比方说,n)作为参数,并返回数据集的前个元素的数组。 Take函数示例 在此示例中,返回现有数据集的前n个元素。要在Scala模式下打开Spark,请按照以下命令操作。 在此示例中,检索数据集的第一个元素。要在Scala模式下打开Spark,请按照以下命令操作。 使用并行化集合创建RDD。 现在,可以使用以下命令读取生成的结果。 应用函数来检

-

Spark First函数

Spark First函数主要内容:First函数示例在Spark中,函数始终返回数据集的第一个元素。它类似于。 First函数示例 在此示例中,检索数据集的第一个元素。要在Scala模式下打开Spark,请按照以下命令操作。 使用并行化集合创建RDD。 现在,可以使用以下命令读取生成的结果。 应用函数来检索数据集的第一个元素。

-

Spark cogroup函数

Spark cogroup函数主要内容:cogroup函数示例在Spark中,函数对不同的数据集执行,比方说,(K,V)和(K,W)并返回元组的数据集。此操作也称为groupWith。 cogroup函数示例 在这个例子中,将执行操作。要在Scala模式下打开Spark,请按照以下命令操作。 使用并行化集合创建RDD。 现在,可以使用以下命令读取生成的结果。 使用并行化集合创建另一个RDD。 现在,可以使用以下命令读取生成的结果。 应用函数对值进行分组。 现

-

Spark reduceByKey函数

Spark reduceByKey函数主要内容:reduceByKey函数的示例在Spark中,函数是一种常用的转换操作,它执行数据聚合。它接收键值对(K,V)作为输入,基于键聚合值并生成(K,V)对的数据集作为输出。 reduceByKey函数的示例 在此示例中,我们基于键聚合值。要在Scala模式下打开Spark,请按照以下命令操作。 使用并行化集合创建RDD。 现在,可以使用以下命令读取生成的结果。 应用函数来聚合值。 现在,可以使用以下命令读取生成的结果。

-

Spark groupByKey函数

Spark groupByKey函数主要内容:groupByKey函数的示例在Spark中,函数是一种经常使用的转换操作,它执行数据的混乱。它接收键值对(K,V)作为输入,基于键对值进行分组,并生成(K,Iterable)对的数据集作为输出。 groupByKey函数的示例 在此示例中,根据键对值进行分组。要在Scala模式下打开Spark,请按照以下命令操作。 使用并行化集合创建RDD。 现在,可以使用以下命令读取生成的结果。 应用函数对值进行分组。 现在,可以使用以下

-

Spark sortByKey函数

Spark sortByKey函数主要内容:sortByKey函数的示例在Spark中,函数维护元素的顺序。它接收键值对作为输入,按升序或降序对元素进行排序,并按顺序生成数据集。 sortByKey函数的示例 在此示例中,按升序和降序排列数据集的元素。要在Scala模式下打开,请按照以下命令操作。 使用并行化集合创建RDD。 现在,可以使用以下命令读取生成的结果。 升序,应用函数来忽略重复的元素。 现在,可以使用以下命令读取生成的结果。 在这里,得到了所需的输出。对于

-

Spark Cartesian函数

Spark Cartesian函数主要内容:Cartesian函数示例在Spark中,Cartesian函数生成两个数据集的笛卡尔积,并返回所有可能的对组合。这里,一个数据集的每个元素与另一个数据集的每个元素配对。 Cartesian函数示例 在此示例中,生成两个数据集的笛卡尔积。 要在Scala模式下打开Spark,请按照以下命令操作。 使用并行化集合创建RDD。 现在,可以使用以下命令读取生成结果。 使用并行化集合创建另一个RDD。 现在,可以使用以下命令读取生

-

Spark Intersection函数

Spark Intersection函数主要内容:Intersection函数示例在Spark中,函数返回一个新数据集,其中包含不同数据集中存在的元素的交集。因此,它只返回一行。此函数的行为与SQL中的查询类似。 Intersection函数示例 在此示例中,将两个数据集的元素相交。要在Scala模式下打开Spark,请按照以下命令操作。 使用并行化集合创建RDD。 现在,可以使用以下命令读取生成的结果。 使用并行化集合创建另一个RDD。 现在,可以使用以下命令读取生成的结果。

-

Spark Union函数

Spark Union函数主要内容:Union函数示例在Spark中,函数返回一个新数据集,其中包含不同数据集中存在的元素组合。 Union函数示例 在此示例中,组合了两个数据集的元素。要在Scala模式下打开Spark,请按照以下命令操作。 使用并行化集合创建RDD。 现在,可以使用以下命令读取生成的结果。 使用并行化集合创建另一个RDD。 现在,可以使用以下命令读取生成的结果。 应用函数返回元素的并集。 现在,可以使用以下命令读取生成的结果。

-

Spark Distinct函数

Spark Distinct函数主要内容:Distinct函数的示例在Spark中,函数返回提供的数据集中的不同元素。 Distinct函数的示例 在此示例中,忽略重复元素并仅检索不同的元素。要在Scala模式下打开Spark,请按照以下命令操作。 使用并行化集合创建RDD。 现在,可以使用以下命令读取生成的结果。 应用函数来忽略重复的元素。 现在,可以使用以下命令读取生成的结果。

-

Spark Count函数

Spark Count函数主要内容:count函数的示例在Spark中,函数返回数据集中存在的元素数。 count函数的示例 在此示例中,计算数据集中存在的元素数量。使用并行化集合创建RDD。 现在,可以使用以下命令读取生成的结果。 应用函数来计算元素数。

-

Spark Filter函数

Spark Filter函数主要内容:Filter函数示例在Spark中,Filter函数返回一个新数据集,该数据集是通过选择函数返回的源元素而形成的。因此,它仅检索满足给定条件的元素。 Filter函数示例 在此示例中,将过滤给定数据并检索除之外的所有值。 要在Scala模式下打开Spark,请按照以下命令操作。 使用并行化集合创建RDD。 现在,可以使用以下命令读取生成的结果。 应用过滤器函数并传递执行所需的表达式。 现在,可以使用以下命令读取生成的

-

Spark Map函数

Spark Map函数在Spark中,Map通过函数传递源的每个元素,并形成新的分布式数据集。 Map函数示例 在此示例中,我们为每个元素添加一个常量值。要在Scala模式下打开Spark,请按照以下命令操作 - 使用并行化集合创建RDD。 现在,可以使用以下命令读取生成的结果。 应用map函数并传递执行所需的表达式。 现在,可以使用以下命令读取生成的结果。 在这里,得到了所需的输出。

-

21 lambda函数

其实就是一个匿名函数,为什么叫lambda?因为和后面的函数式编程有关. 推荐: 知乎

-

全局函数

全局函数 返回上级 DirectDrawCreate DirectDrawCreateClipper DirectDrawEnumerate DirectDrawEnumerateEx DirectDrawCreate 返回目录 创建一个DirectDraw对象的实例。 HRESULT WINAPI DirectDrawCreate( GUID FAR *lpGUID, LPDIRECTDRAW