mysql - 没有做导入操作,Got a packet bigger than 'max_allowed_packet' bytes 如何找到处理思路?

错误线索

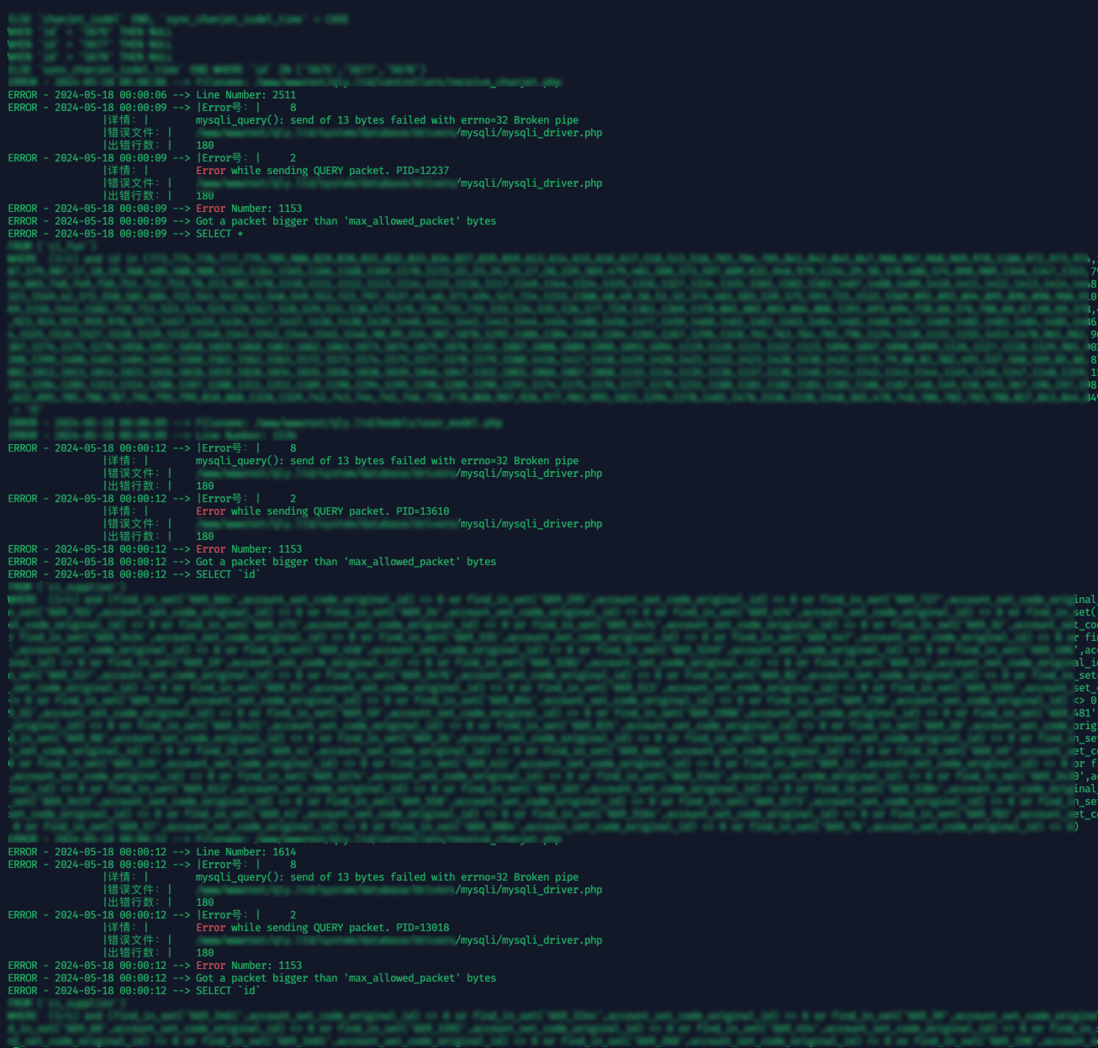

- mysql不定时崩溃,崩溃时查看日志,如下图,每一个执行的sql都报错

Got a packet bigger than 'max_allowed_packet' bytes

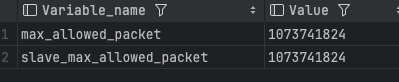

- mysql max_allowed_packet 参数为1G,如下图

- 没有做什么大型导入操作。

- 崩溃后,重启mysql,一段时间后(可能几个小时,可能几天)不定时重新出现此错误。

共有1个答案

处理思路如下:

- 检查网络层:

由于你提到没有执行大型导入操作,那么可能是网络层的问题导致数据包被错误地分割或合并。检查你的网络设备和配置,确保它们能够处理大型数据包,并且没有数据包被意外地拆分。 - 分析日志:

仔细检查MySQL的完整错误日志,看看是否有其他相关的错误信息或警告。有时候,错误日志中可能包含导致问题的线索。 - 检查应用程序代码:

尽管你提到没有执行大型导入操作,但是仍建议检查与数据库交互的应用程序代码,看是否有某些查询或操作意外地产生了过大的数据包。特别要注意是否有大对象(如BLOB、TEXT等)被操作或传输。 - 调整

max_allowed_packet参数:

尽管你的max_allowed_packet已经设置为1G,但可以尝试进一步增加这个值,看看是否解决了问题。请注意,增加这个值可能会增加内存使用和网络传输的开销。 - 检查MySQL版本和已知问题:

查看你正在使用的MySQL版本是否有已知的与max_allowed_packet或数据包大小相关的bug。如果有,考虑升级到修复了这些问题的版本。 - 考虑使用压缩:

如果网络带宽是问题所在,可以考虑启用MySQL的压缩功能,以减少传输的数据量。 - 监控和诊断工具:

使用MySQL的监控和诊断工具(如SHOW STATUS,SHOW VARIABLES,Performance Schema,Information Schema等)来收集更多关于数据库操作和性能的信息。 - 联系支持:

如果以上步骤都不能解决问题,可能需要联系MySQL的官方支持或社区寻求帮助。在联系支持时,提供尽可能详细的错误日志和配置信息。

最后,由于问题涉及网络传输和数据库配置,解决起来可能比较复杂。建议逐步排查,并考虑在测试环境中重现问题以进行更深入的分析。

-

我搜索了一个小时来找到问题的解决方案,我使用maven to pom.xml来查找这个导入的库org.springframework.jdbc.core.jdbctemplate 我的pom.xml 结果是:-

-

理解操作符导入 在消费或创建依赖于 RxJS 的公共库时,你可能遇到处理运算符导入的问题。在项目中引入操作符最主要的方式像下面这样导入: import 'rxjs/add/operator/take'; 这会将导入的操作符添加到 Observable 的原型上,以便在整个项目中使用: (源码) import { Observable } from '../../Observable'; impo

-

目前有个需求是要将csv文件内容分别插入到某数据库的两张表中,有一定依赖关系。由于一直是学生本科刚大四没毕业,故实战经验与性能优化经验薄弱 demo信息如下: 两张表分别是角色信息表和用户信息表 角色信息表 学号/工号 姓名 性别 角色(依赖权限表id) 科目表id(依赖于科目表) 用户信息表 uuid 手机号 密码 角色id(依赖于角色信息表) 权限表:老师、管理员、学生 科目表:语、数、英……

-

我们有一个用C#/WPF/Prism构建的相当大的应用程序。应用程序有几个静态模块和未知数量的动态加载模块。 我的影响范围是静态模块和shell。 我被要求实现一个将重启shell的特性,但只有在查询所有当前打开的模块是否允许重启之后。如果至少有一个模块表示不允许(例如:仍然未保存的更改),则重新启动将被推迟。 现在shell和模块通过进行通信。这意味着我可以发布一个事件,然后查看是否有任何订阅服

-

我使用hadoop 2.7.2,hbase 1.4.9,火花2.2.0,scala 2.11.8和java 1.8的hadoop集群是由一个主和两个从。 当我在启动集群后运行spark shell时,它工作正常。我正试图通过以下教程使用scala连接到hbase:[https://www.youtube.com/watch?v=gGwB0kCcdu0][1] . 但当我试图像他那样通过添加那些类似

-

我在让@RequestMapping工作时遇到了问题,我得到了以下日志;你能帮我理解一下日志吗? 调试o.s.web.servlet.DispatcherServlet-成功完成请求 访问本地主机时的日志:80/ruler/test: 调试o.s.web.servlet.DispatcherServlet-名称为“dispatcher servlet”的DispatcherServlet处理[/r