stream_setchunk_size():块大小不能大于laravel 24215454

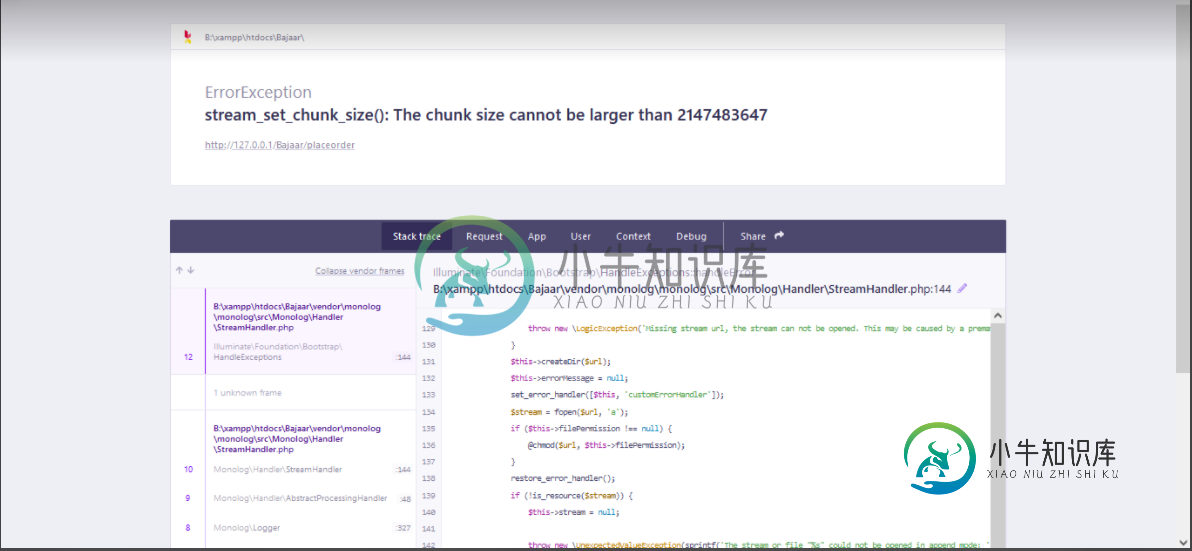

我在laravel项目中遇到了“stream\u set\u chunk\u size():chunk size不能大于laravel 24215454”这一错误。不知道这是为什么。

我使用的是Laravel8和XAMPP3.3。0

共有2个答案

问题来自php。ini文件作为包monolog/monolog和StramHandler在其指令中使用它,并且在某些情况下定义它也很重要。

键入php--ini以标识服务器上的PHP加载了哪些php.ini并标识您的自定义文件。

例如,我的服务器上的最后一个是我的自定义php。ini,它覆盖其他值的任何值:

尝试像这样更改memory_limit值:

然后重新加载页面/执行任意CLI进行尝试。

stream_set_chunk_size(resource $resourcedata, $maxsize(PHP_INT_MAX))

in php PHP_INT_MAX (integer, not int64) limit is int(2.147.483.647 byte/character).

也就是说,函数不支持高于此值的数据堆栈,因此要么减少数据堆栈,要么分析2gb数据的来源,将其分成多个部分,然后将这些部分发送到函数,然后必须合并。

-

php artisan route:cache命令引发错误: stream_set_chunk_size():块大小不能大于2147483647 在供应商处/monolog/monolog/src/monolog/Handler/StreamHandler。菲律宾比索:144 请帮我解决这个问题

-

我正在尝试安装Craftable,当我运行命令时,它抛出错误: 在StreamHandler.php第144行:stream_set_chunk_size():块大小不能大于2147483647 请帮我解决这个问题。

-

问题内容: 我是Hadoop MapReduce的新手(准确地说是4天),并且被要求在集群上执行分布式XML解析。根据我在Internet上的(重新)搜索,使用Mahout的XmlInputFormat应该相当容易,但是我的任务是确保该系统适用于大型(〜5TB)XML文件。 据我所知,发送到映射器的文件拆分不能大于hdfs块大小(或每个作业块大小)。[如果我弄错了,请纠正我]。 我面临的问题是,某

-

我正在尝试从构建镜像。构建后,命令报告的镜像虚拟大小为1.917 GB。我登录检查大小(),它是573 MB。我很确定这个巨大的大小通常是不可能的。这是怎么回事?如何获得正确的图像大小?更重要的是,当我推送这个存储库时,大小是1.9 GB而不是573 MB。 输出

-

我是Hadoop MapReduce的新手(准确地说是4天),我被要求在集群上执行分布式XML解析。根据我在Internet上的搜索,使用Mahout的XmlInputFormat应该相当容易,但我的任务是确保该系统能够处理巨大的(~5TB)XML文件。 据我所知,发送到映射器的文件拆分不能大于hdfs块大小(或每个作业块大小)。[如果我错了请纠正我]。 我面临的问题是,有些XML元素很大(~20

-

我是Java的初学者,刚开始使用Intellij作为我的IDE。 当我使用它时,有时会延迟。 我更改了我的 xms 和 xmx 以获得更大的堆大小(xms = 1024,xmx = 2048),但它抛出了一个错误。 所以,我把它回滚了。 错误消息是这样的:“初始堆大小设置为大于最大堆大小的值”。 有什么问题? 如果可能,如何增加最大堆大小? 我用的是笔记本电脑,它有8GB内存。x64Intelli