使用ActiveDirectoryPassword连接Azure SQL DB时出错

我正在尝试用AAD-Password-auth从Databricks连接Azure sql db。我导入了azure sql数据库

java.lang.NoClassDefFoundError: com/nimbusds/oauth2/sdk/AuthorizationGrant

堆栈跟踪:

at com.microsoft.sqlserver.jdbc.SQLServerADAL4JUtils.getSqlFedAuthToken(SQLServerADAL4JUtils.java:24)

at com.microsoft.sqlserver.jdbc.SQLServerConnection.getFedAuthToken(SQLServerConnection.java:3609)

at com.microsoft.sqlserver.jdbc.SQLServerConnection.onFedAuthInfo(SQLServerConnection.java:3580)

at com.microsoft.sqlserver.jdbc.SQLServerConnection.processFedAuthInfo(SQLServerConnection.java:3548)

at com.microsoft.sqlserver.jdbc.TDSTokenHandler.onFedAuthInfo(tdsparser.java:261)

at com.microsoft.sqlserver.jdbc.TDSParser.parse(tdsparser.java:103)

at com.microsoft.sqlserver.jdbc.SQLServerConnection.sendLogon(SQLServerConnection.java:4290)

at com.microsoft.sqlserver.jdbc.SQLServerConnection.logon(SQLServerConnection.java:3157)

at com.microsoft.sqlserver.jdbc.SQLServerConnection.access$100(SQLServerConnection.java:82)

at com.microsoft.sqlserver.jdbc.SQLServerConnection$LogonCommand.doExecute(SQLServerConnection.java:3121)

at com.microsoft.sqlserver.jdbc.TDSCommand.execute(IOBuffer.java:7151)

at com.microsoft.sqlserver.jdbc.SQLServerConnection.executeCommand(SQLServerConnection.java:2478)

at com.microsoft.sqlserver.jdbc.SQLServerConnection.connectHelper(SQLServerConnection.java:2026)

at com.microsoft.sqlserver.jdbc.SQLServerConnection.login(SQLServerConnection.java:1687)

at com.microsoft.sqlserver.jdbc.SQLServerConnection.connectInternal(SQLServerConnection.java:1528)

at com.microsoft.sqlserver.jdbc.SQLServerConnection.connect(SQLServerConnection.java:866)

at com.microsoft.sqlserver.jdbc.SQLServerDriver.connect(SQLServerDriver.java:569)

at org.apache.spark.sql.execution.datasources.jdbc.JdbcUtils$$anonfun$createConnectionFactory$1.apply(JdbcUtils.scala:63)

at org.apache.spark.sql.execution.datasources.jdbc.JdbcUtils$$anonfun$createConnectionFactory$1.apply(JdbcUtils.scala:54)

at org.apache.spark.sql.execution.datasources.jdbc.JDBCRDD$.resolveTable(JDBCRDD.scala:56)

at org.apache.spark.sql.execution.datasources.jdbc.JDBCRelation.<init>(JDBCRelation.scala:115)

at org.apache.spark.sql.execution.datasources.jdbc.JdbcRelationProvider.createRelation(JdbcRelationProvider.scala:5

at com.databricks.backend.daemon.driver.DriverWrapper.tryExecutingCommand(DriverWrapper.scala:590)

at com.databricks.backend.daemon.driver.DriverWrapper.getCommandOutputAndError(DriverWrapper.scala:474)

at com.databricks.backend.daemon.driver.DriverWrapper.executeCommand(DriverWrapper.scala:548)

at com.databricks.backend.daemon.driver.DriverWrapper.runInnerLoop(DriverWrapper.scala:380)

at com.databricks.backend.daemon.driver.DriverWrapper.runInner(DriverWrapper.scala:327)

at com.databricks.backend.daemon.driver.DriverWrapper.run(DriverWrapper.scala:215)

at java.lang.Thread.run(Thread.java:748)

Caused by: java.lang.ClassNotFoundException: com.nimbusds.oauth2.sdk.AuthorizationGrant

at java.net.URLClassLoader.findClass(URLClassLoader.java:381)

at java.lang.ClassLoader.loadClass(ClassLoader.java:424)

at sun.misc.Launcher$AppClassLoader.loadClass(Launcher.java:338)

at java.lang.ClassLoader.loadClass(ClassLoader.java:357)

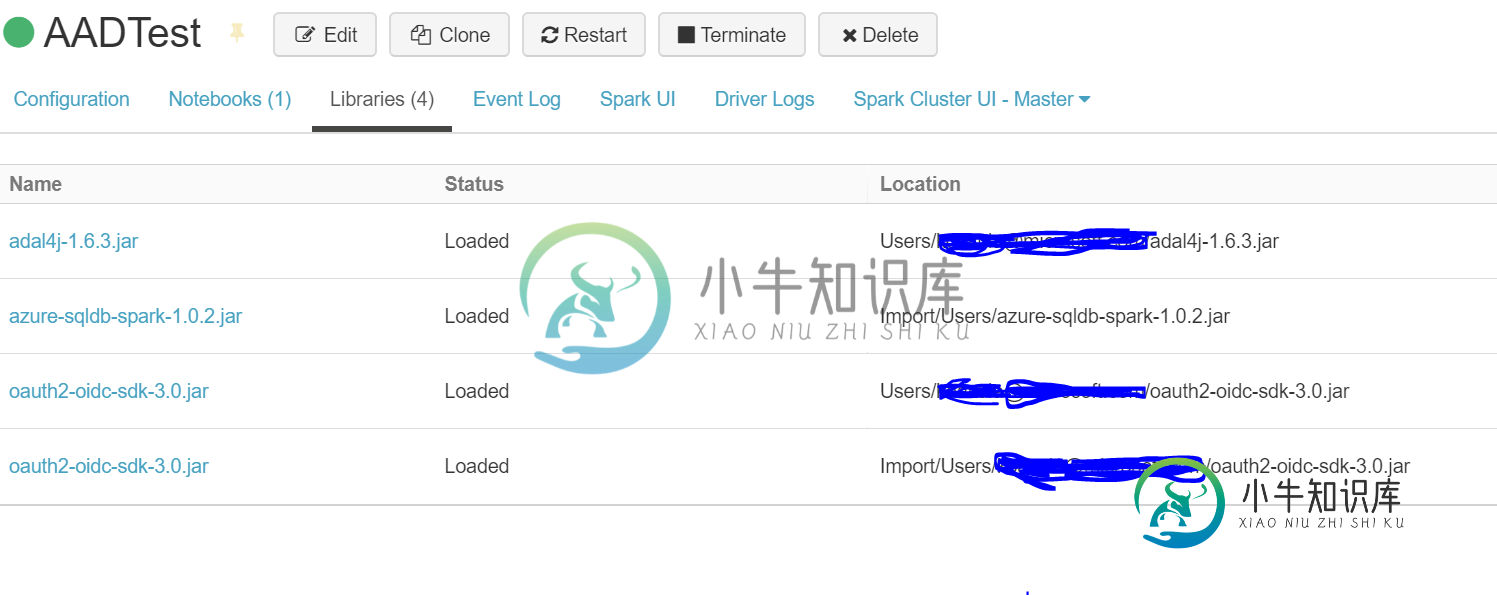

已将nimbusds库导入我的工作区。

这里是配置

import com.microsoft.azure.sqldb.spark.config.Config

import com.microsoft.azure.sqldb.spark.connect._

import org.apache.spark.sql.SparkSession

val spark: SparkSession = SparkSession.builder().getOrCreate()

val config = Config(Map(

"url" -> "ServerName.database.windows.net",

"databaseName" -> "dbname",

"dbTable" -> "dbo.test",

"user" -> "alias@domain.com",

"password" -> "pwd",

"authentication" -> "ActiveDirectoryPassword",

"encrypt" -> "true",

"trustServerCertificate"->"false",

"hostNameInCertificate"->"*.database.windows.net"

))

val collection = spark.read.sqlDB(config)

collection.show()

如果有人解决了这个问题,请帮助我。

共有1个答案

点击这里下载工作笔记本。

已知工作配置-Databricks Runtime 5.2(包括ApacheSpark 2.4.0和Scala 2.11)

- 导航到群集

已知的工作版本-com.microsoft.azure: azure-sqldb-火花: 1.0.2

更新变量值(CusterName,服务器,数据库,表,用户名,密码)

这将执行以下操作:

- 在dbfs:/databricks/init/

- 创建一个子文件夹,其名称为Databricks群集

- 为每个依赖项创建bash脚本

Bash Script命令:*wget:从Web服务器检索内容*--退出:关闭wget的输出*-O:输出

依赖项:

>

http://central.maven.org/maven2/com/nimbusds/oauth2-oidc-sdk/5.24.1/oauth2-oidc-sdk-5.24.1.jar

这是执行init脚本所必需的。

这将测试通过Active Directory身份验证连接到Azure SQL数据库的能力。

初始化命令

// Initialisation

// This code block only needs to be run once to create the init script for the cluster (file remains on restart)

// Get the cluster name

var clusterName = dbutils.widgets.get("cluster")

// Create dbfs:/databricks/init/ if it doesn’t exist.

dbutils.fs.mkdirs("dbfs:/databricks/init/")

// Create a directory named (clusterName) using Databricks File System - DBFS.

dbutils.fs.mkdirs(s"dbfs:/databricks/init/$clusterName/")

// Create the adal4j script.

dbutils.fs.put(s"/databricks/init/$clusterName/adal4j-install.sh","""

#!/bin/bash

wget --quiet -O /mnt/driver-daemon/jars/adal4j-1.6.0.jar http://central.maven.org/maven2/com/microsoft/azure/adal4j/1.6.0/adal4j-1.6.0.jar

wget --quiet -O /mnt/jars/driver-daemon/adal4j-1.6.0.jar http://central.maven.org/maven2/com/microsoft/azure/adal4j/1.6.0/adal4j-1.6.0.jar""", true)

// Create the oauth2 script.

dbutils.fs.put(s"/databricks/init/$clusterName/oauth2-install.sh","""

#!/bin/bash

wget --quiet -O /mnt/driver-daemon/jars/oauth2-oidc-sdk-5.24.1.jar http://central.maven.org/maven2/com/nimbusds/oauth2-oidc-sdk/5.24.1/oauth2-oidc-sdk-5.24.1.jar

wget --quiet -O /mnt/jars/driver-daemon/oauth2-oidc-sdk-5.24.1.jar http://central.maven.org/maven2/com/nimbusds/oauth2-oidc-sdk/5.24.1/oauth2-oidc-sdk-5.24.1.jar""", true)

// Create the json script.

dbutils.fs.put(s"/databricks/init/$clusterName/json-smart-install.sh","""

#!/bin/bash

wget --quiet -O /mnt/driver-daemon/jars/json-smart-1.1.1.jar http://central.maven.org/maven2/net/minidev/json-smart/1.1.1/json-smart-1.1.1.jar

wget --quiet -O /mnt/jars/driver-daemon/json-smart-1.1.1.jar http://central.maven.org/maven2/net/minidev/json-smart/1.1.1/json-smart-1.1.1.jar""", true)

// Create the jwt script.

dbutils.fs.put(s"/databricks/init/$clusterName/jwt-install.sh","""

#!/bin/bash

wget --quiet -O /mnt/driver-daemon/jars/nimbus-jose-jwt-7.0.1.jar http://central.maven.org/maven2/com/nimbusds/nimbus-jose-jwt/7.0.1/nimbus-jose-jwt-7.0.1.jar

wget --quiet -O /mnt/jars/driver-daemon/nimbus-jose-jwt-7.0.1.jar http://central.maven.org/maven2/com/nimbusds/nimbus-jose-jwt/7.0.1/nimbus-jose-jwt-7.0.1.jar""", true)

// Check that the cluster-specific init script exists.

display(dbutils.fs.ls(s"dbfs:/databricks/init/$clusterName/"))

测试命令

// Connect to Azure SQL Database via Active Directory Password Authentication

import com.microsoft.azure.sqldb.spark.config.Config

import com.microsoft.azure.sqldb.spark.connect._

// Get Widget Values

var server = dbutils.widgets.get("server")

var database = dbutils.widgets.get("database")

var table = dbutils.widgets.get("table")

var username = dbutils.widgets.get("user")

var password = dbutils.widgets.get("password")

val config = Config(Map(

"url" -> s"$server.database.windows.net",

"databaseName" -> s"$database",

"dbTable" -> s"$table",

"user" -> s"$username",

"password" -> s"$password",

"authentication" -> "ActiveDirectoryPassword",

"encrypt" -> "true",

"ServerCertificate" -> "false",

"hostNameInCertificate" -> "*.database.windows.net"

))

val collection = sqlContext.read.sqlDB(config)

collection.show()

-

我正在尝试使用Azure AD(应用程序作为DB用户)从Spring Boot(2.0.1)Web应用程序连接到Azure SQL DB,但似乎无法连接点。 我遵循了使用Azure AD Auth进行连接的步骤。然而,我得到一个失败的登录。 我假设这是因为没有在JDBC url中设置“身份验证”属性,它只是直接对数据库进行身份验证(用户使用CREATE USER创建 有没有办法在连接时配置spri

-

我正在尝试使用solrj CloudSolrClient连接到solrCloud,但出现了错误。 用于直接调用单个solr节点,现在切换到solrcloud。我已经尝试了各种不同的url格式,如在线文档中指定的。 使用以下zkHost字符串时,我会发现各种错误。 主持人:2181 2019-08-21 15:53:17错误o. a. c. c.C.[.[.[.[.a. d. n. s.超文本传输协

-

我得到一个连接不打开发送()错误后立即连接到一个万花筒节点的网络套接字。我试图从web3js版本1.0.0-beta.34使用WebSocketProvider。 我的连接代码看起来像这样,其中,和是带有Kaleido节点信息的局部变量。 我已经尝试了Github问题中列出的建议步骤——在连接丢失时尝试重新连接,但错误仍然存在。我认为这可能是一个Kaleido问题,因为我可以使用Websocket

-

我从2016年的Exchange迁移到2019年。我有一个PowerShell脚本,用于使用EWS连接到exchange以访问用户的收件箱。它在连接时一直失败。我试着看看从2016年到2019年是否有什么不同,但结果是空的。这里是我用来连接到2016年的代码

-

我正试图用下面给出的代码,用pyodbc从SQL数据库中提取数据。连接很少工作,大多数时候会出错, OperationalError:(“HYT00”,“[HYT00][Microsoft][ODBC SQL Server驱动程序]登录超时过期(0)(SQLDriverConnect)”) 在使用SQL Server 2014时,我尝试将超时设置为零和Driver={SQL Server的ODBC

-

我尝试执行下面的python代码 最后一个语句通过以下连接错误。