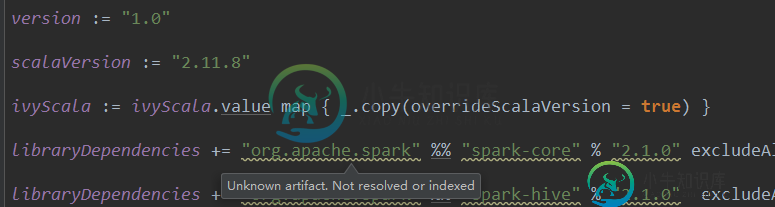

SBT上Spark 2.1.0的“未解析依赖项”

版本:=“1.0”

scalaVersion:=“2.11.8”

ivyScala:=ivyScala.Value map{_.copy(overrideScalaVersion=true)}

libraryDependencies+=“org.apache.spark”%%“Spark-Core”%“2.1.0”

当我尝试用sbt组装jar时,我试图将spark引入我的开发环境,但它失败了,并且在我的sbt中显示[error],如下所示:

[warn] :::::::::::::::::::::::::::::::::::::::::::::: <br/>

[warn] :: UNRESOLVED DEPENDENCIES :: <br/>

[warn] :::::::::::::::::::::::::::::::::::::::::::::: <br/>

[warn] :: org.apache.spark#spark-core_2.11;2.1.0: not found <br/>

[warn] :::::::::::::::::::::::::::::::::::::::::::::: <br/>

[warn]

[warn] Note: Unresolved dependencies path: <br/>

[warn] org.apache.spark:spark-core_2.11:2.1.0 (D:\MyDocument\IDEA\Scala\model\build.sbt#L9-10) <br/>

[warn] +- org.apache.spark:spark-catalyst_2.11:2.1.0 <br/>

[warn] +- org.apache.spark:spark-sql_2.11:2.1.0 (D:\MyDocument\IDEA\Scala\model\build.sbt#L15-16) <br/>

[warn] +- org.apache.spark:spark-hive_2.11:2.1.0 (D:\MyDocument\IDEA\Scala\model\build.sbt#L11-12) <br/>

[warn] +- default:producttagmodel_2.11:1.0 <br/>

[trace] Stack trace suppressed: run 'last *:update' for the full output. <br/>

[error] (*:update) sbt.ResolveException: unresolved dependency: org.apache.spark#spark-core_2.11;2.1.0: not found

我的IntelliJ版本是2016.3.5,sbt版本是0.13.13,scala版本是2.11.8;我发现sbt已经成功下载了spark-core.jar,我在.ivy/cache目录中找到了它,但它总是显示“Unknown Artifact.Not Resovled or indexed”。我刷新了我的项目索引很多次,但它没有工作。我使用相同的build.sbt创建了一个新项目,以防止IntelliJ缓存受到干扰,但它没有起作用。我完全搞不清这个问题。

下面是我的build.sbt设置:

共有1个答案

将依赖关系更改为:

libraryDependencies += "org.apache.spark" % "spark-core_2.11" % "2.1.0"

此外,对于spark应用程序,这通常是作为“provided”添加的,它不应该包含在jar中,因为当您提交作业时,相关的spark库已经安装在驱动程序和执行程序中。

-

关于解决依赖关系,我与sbt有一些问题。 built.sbt Sbt版本:来自arch community repository的Sbt 1.0.0-2 运行操作系统:Antergos内核4.12.8-2-arch

-

试图遵循O'Reilly的“编程Scala”一书中的示例。下载并安装sbt,使用:brew install sbt@1似乎已成功。然后在命令行输入“sbt”或“sbt-v”(在Mac上bash)后,我会得到: 格伦

-

使用IntelliJ最新的scala插件sbt 13.8和scala 2.11.7的新sbt项目,我尝试添加一个库-akka 2.4.2。在此之后,我简单地添加 [信息]解析org.scala-sbt#testing;0.13.8... [信息]解析org.scala-sbt#test-agent;0.13.8... [信息]解析org.scala-SBT#test-interface;1.0..

-

我做错了什么? 我已经将Intellij设置为使用Scala2.11.8,但输出可能意味着使用了不同的版本(?)。 我试过以前一个类似问题的想法,但没有帮助: 更新:我将SBT版本更改为0.13.18后的输出

-

我正在使用IntelliJ开发Spark应用程序。我正在遵循这个关于如何使intellij与SBT项目良好地工作的指导。 但这样我就无法在IntelliJ内部运行应用程序,因为类路径中不会包含spark依赖项。

-

导入SBT项目时出错: ... 关于如何解决这个问题的任何建议。导入在另一台机器上运行良好。我看到了.ivy2文件夹中的jar文件。