attention机制

参考回答:

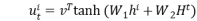

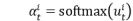

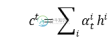

Attention简单理解就是权重分配,。以seq2seq中的attention公式作为讲解。就是对输入的每个词分配一个权重,权重的计算方式为与解码端的隐含层时刻作比较,得到的权重的意义就是权重越大,该词越重要。最终加权求和。

-

本文向大家介绍Attention机制的作用相关面试题,主要包含被问及Attention机制的作用时的应答技巧和注意事项,需要的朋友参考一下 参考回答: 减少处理高维输入数据的计算负担,结构化的选取输入的子集,从而降低数据的维度。让系统更加容易的找到输入的数据中与当前输出信息相关的有用信息,从而提高输出的质量。帮助类似于decoder这样的模型框架更好的学到多种内容模态之间的相互关系。

-

Attention center 是一个机器学习模型,这个仓库包含: 一个 TensorFlow Lite 模型,可用于预测图像的注意中心,即图像中最突出的部分所在的区域 一个 Python 脚本,可用于使用注意力中心对图像进行批量编码。这可以和子模块 libjxl 一起使用,以便创建 JPEG XL 图像,这样解码图像将从由模型决定的注意中心开始。 Google Attention center

-

简介:Attention机制是一种用于加强神经网络在处理序列数据中关注重要部分的机制。在处理长序列时,RNN可能难以捕捉到序列中不同部分的重要程度,导致信息传递不够高效。而Attention机制允许网络根据当前输入和其他位置的信息,动态地调整各个位置的权重,使得模型可以有选择地关注不同部分的输入。Transformer是一种基于Attention机制的神经网络架构,由著名且经典的"Attentio

-

本文向大家介绍Java JVM虚拟机运行机制,包括了Java JVM虚拟机运行机制的使用技巧和注意事项,需要的朋友参考一下 一:JVM基础概念 JVM(Java虚拟机)一种用于计算设备的规范,可用不同的方式(软件或硬件)加以实现。编译虚拟机的指令集与编译微处理器的指令集非常类似。Java虚拟机包括一套字节码指令集、一组寄存器、一个栈、一个垃圾回收堆和一个存储方法域。

-

本文向大家介绍RDD机制?相关面试题,主要包含被问及RDD机制?时的应答技巧和注意事项,需要的朋友参考一下 rdd分布式弹性数据集,简单的理解成一种数据结构,是spark框架上的通用货币。 所有算子都是基于rdd来执行的,不同的场景会有不同的rdd实现类,但是都可以进行互相转换。 rdd执行过程中会形成dag图,然后形成lineage保证容错性等。 从物理的角度来看rdd存储的是block和nod

-

Session即HttpSession对象,是维护客户端/服务器端的身份识别机制之一 默认情况下,单机使用,并不需要特别的Session机制 但,如果是集群,或者你想用Redis/Memcached等存放Session,那么就需要自定义Session了 Session有很多种, 例如: *容器本身提供的(tomcat/jetty/jboss/weblogic等都自带跨JVM的Session,功能强