python动态网页批量爬取

四六级成绩查询网站我所知道的有两个:学信网(http://www.chsi.com.cn/cet/)和99宿舍(http://cet.99sushe.com/),这两个网站采用的都是动态网页。我使用的是学信网,好了,网站截图如下:

网站的代码如下:

<form method="get" name="form1" id="form1" action="/cet/query"> <table border="0" align="center" cellpadding="0" cellspacing="0"> <tr><td align="right">准考证号:</td><td align="left"><input name="zkzh" value="112008000463141" id="zkzh" type="text" size="18" maxlength="15" class="input_text input_t_l" /></td> <td align="left" class="font12 color666">请输入15位准考证号</td> </tr> <tr><td align="right">姓名:</td><td align="left"><input name="xm" value="啊啊" id="xm" type="text" size="18" maxlength="50" class="input_text input_t_l" /></td> <td align="left" class="font12 color666">姓名超过3个字,可只输入前3个</td> </tr> <tr><td align="center"> </td> <td colspan="2" align="left"><input type="submit" id="submitCET" class="btn_blue" value="查询" /></td> </tr> </table> </form>

由图中可以看出表单提交的链接为/cet/query,即:http://www.chsi.com.cn/cet/query,好了,填写表单和结果如下:

但是,点击查看源代码之后发现,没有成绩,即代码仍是上面那个,之后按F12查看代码:

<TBODY><TR> <TH>姓名:</TH> <TD>XXXX</TD></TR> <TR> <TH>学校:</TH> <TD>XXXXXX</TD></TR> <TR> <TH>考试类别:</TH> <TD>英语四级</TD></TR> <TR> <TH>准考证号:</TH> <TD>120135151100101</TD></TR> <TR> <TH>考试时间:</TH> <TD>2015年06月</TD></TR>总分:</TH><TD class=fontBold vAlign="top"><SPAN class=colorRed>403 </SPAN><BR><SPAN class=color666>听力:</SPAN> 132 <BR><SPAN class=color666>阅读:</SPAN> 147 <BR><SPAN class=color666>写作与翻译:</SPAN> 124 </TD></TR>

该代码显示了成绩,可以知道,该网站使用的是动态网页,用的JavaScript或者Ajax.js还是其他的我就不知道了0.0。上面为需求。

前言:使用过BeautifulSoup爬取过,但是BeautifulSoup是爬取不了动态网页的,上各种论坛找各种资料,用了n种东西,scapy,pyqt等等,走了真心不少弯路,不是不行,应该是我不会用,最终用了selenium和phantomjs,这两个应该也是目前最流行的爬虫模块了吧。

一、导入selenium和phantomjs

from selenium import webdriver

driver = webdriver.PhantomJS(executable_path='D:\phantomjs-2.1.1-windows\phantomjs.exe')

driver.get(url)

driver.find_element_by_id('zkzh').send_keys(i)

driver.find_element_by_id('xm').send_keys(xm)

driver.find_elements_by_tag_name('form')[1].submit()

代码说明:

3.selenium可以加载很多驱动,比如Chrome、FireFox等,这里需要有这两个浏览器和驱动才行,折腾了一下,网上说Phantomjs是较好的了

5、6、7分别是准考证号,姓名和提交

二、字符处理

提交之后就可以直接查找了:

print driver.find_element_by_xpath("//tr[3]/td[1]").text

print driver.find_element_by_xpath("//tr[6]/td[1]").text

代码说明:

1.查看姓名

2.查看分数及其具体成绩

打印之后为:

姓名 听力 阅读 写作

之后要对分数进行字符串处理,选取各部分的数字,这里我们采用re模块:

import re m = re.findall(r'(\w*[0-9]+)\w*', chuli2)

其中m是数组,输出的是["403","132","147","142"]

三、数据库

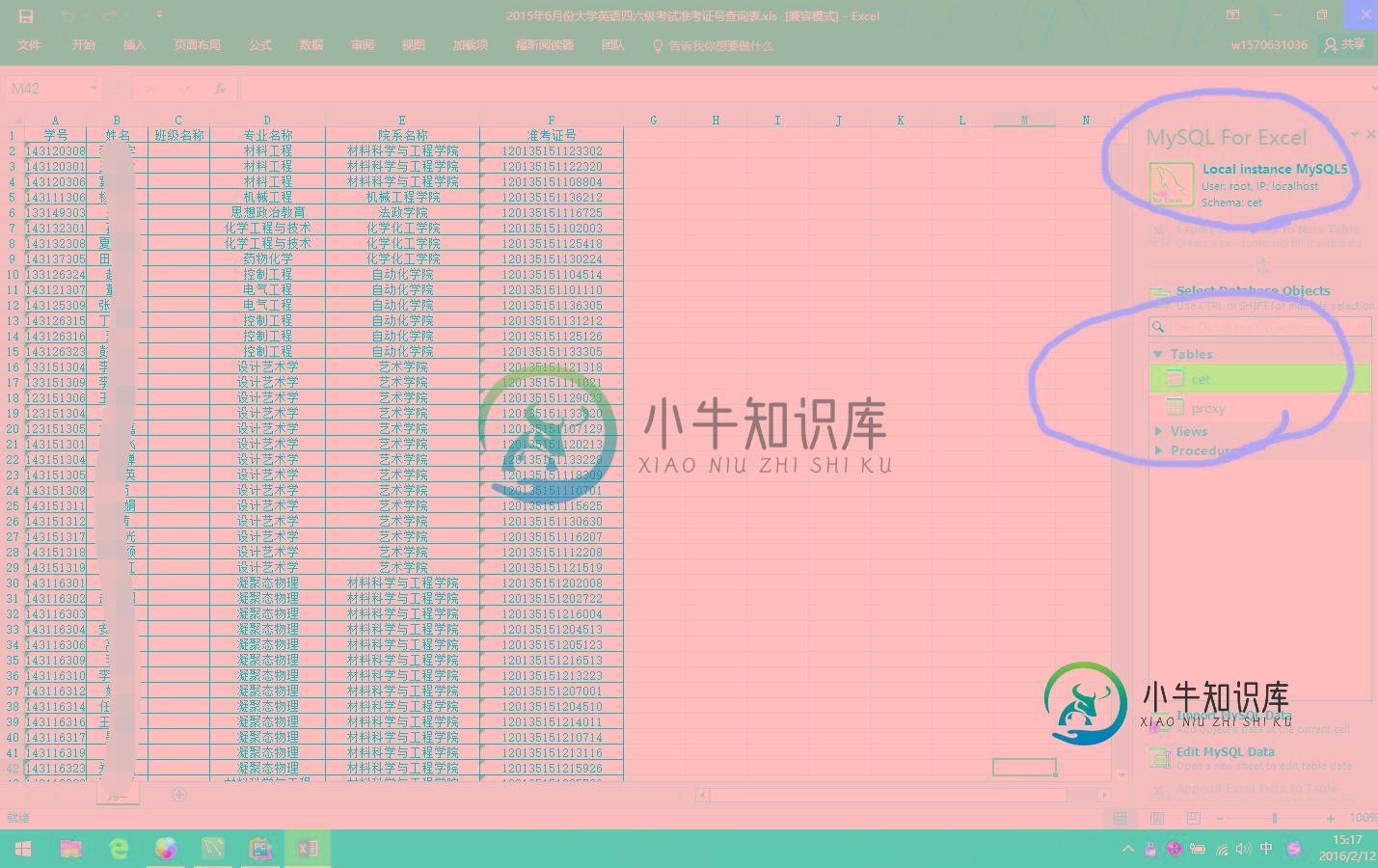

我们学校也不知说很渣还是人性化,反正公布了全校的四六级准考证号,当然,是excel的,需要导入mysql数据库,打开Excel之后,我发现微软大法和Oracle真是牛,Excel365居然有mysql workbench连接部分。

数据库代码如下:

import MySQLdb

conn = MySQLdb.Connect(host='localhost', user='root', passwd='root', db='cet', port=3306, charset='utf8')

cur = conn.cursor()

curr = conn.cursor()

cur.execute("select name from cet.cet where zkzh=(%s)" % i)

xm = cur.fetchone()[0]

print "Name is " + xm

sqltxt = "update cet.cet set leibie=(%s),zongfen=(%s),tingli=(%s),yuedu=(%s),xiezuo=(%s) WHERE zkzh=(%s)" % (

ss, m[0], m[1], m[2], m[3], i)

cur.execute(sqltxt)

conn.commit()

cur.close()

conn.close()

代码说明:

3.python连接数据库代码

6.连接数据库取得姓名部分

9.这行我好无语啊,使用‘“+ss+”'这样的写法一直报错,最终找了半天资料,这个写法我不太喜欢,但是凑合着用吧。

12.记得一定要提交事务!!!commit()!!!不然是没有效果的

四、使用代理服务器(保留以后写)

运行了一段时间之后,大概抓了几百人的吧,然后就出现要求验证码了,解决办法只能处理验证码或者使用代理服务器了,这部分继续加强学习再弄出来了↖(^ω^)↗

五、源代码和效果

# encoding=utf8

import MySQLdb

import re

import time

from selenium import webdriver

# connect mysql,get zkxh and xm

conn = MySQLdb.Connect(host='localhost', user='root', passwd='root', db='cet', port=3306, charset='utf8')

cur = conn.cursor()

curr = conn.cursor()

url = 'http://www.chsi.com.cn/cet/query'

def kaishi(i):

print i,

print " start"

try:

cur.execute("select name from cet.cet where zkzh=(%s)" % i)

xm = cur.fetchone()[0]

print "Name is " + xm

driver = webdriver.PhantomJS(executable_path='D:\phantomjs-2.1.1-windows\phantomjs.exe')

driver.get(url)

driver.find_element_by_id('zkzh').send_keys(i)

driver.find_element_by_id('xm').send_keys(xm)

driver.find_elements_by_tag_name('form')[1].submit()

driver.set_page_load_timeout(10)

leibie = driver.find_element_by_xpath("//tr[3]/td[1]").text

leibie2 = str(leibie.encode("utf-8"))

ss = ""

if leibie2.decode("utf-8") == '英语四级'.decode("utf-8"):

ss = 4

else:

ss = 6

# zongfen = driver.find_element_by_xpath("//tr[6]/th[1]").text

# print zongfen

# print "===="

chuli = driver.find_element_by_xpath("//tr[6]/td[1]").text

print chuli

chuli2 = str(chuli.encode("utf-8"))

m = re.findall(r'(\w*[0-9]+)\w*', chuli2)

sqltxt = "update cet.cet set leibie=(%s),zongfen=(%s),tingli=(%s),yuedu=(%s),xiezuo=(%s) WHERE zkzh=(%s)" % (

ss, m[0], m[1], m[2], m[3], i)

cur.execute(sqltxt)

conn.commit()

print str(i) + " finish"

except Exception, e:

print e

driver.close()

time.sleep(10)

kaishi(i)

# for j1 in range(1201351511001, 1201351512154):

for j1 in range(1201351511007, 1201351512154):

for j2 in range(0, 3):

for j3 in range(0, 10):

j = str(j1) + str(j2) + str(j3)

if str(j2) + str(j3) == "00":

print "0.0"

elif str(j2) + str(j3) == "29":

kaishi(str(j1) + str(j2) + str(j3))

j4 = str(j1) + "30"

kaishi(j4)

else:

kaishi(j)

print "END!!!"

cur.close()

conn.close()

总结:python的字符串处理细节真的很重要,动不动就输出错误,还有IDE的编码不一样,记得还有个系统编码,字符编码,环境编码,数据库编码等等都要一致。

以上就是本文的全部内容,希望对大家的学习有所帮助。

-

本文向大家介绍python 自动批量打开网页的示例,包括了python 自动批量打开网页的示例的使用技巧和注意事项,需要的朋友参考一下 如下所示: 以上这篇python 自动批量打开网页的示例就是小编分享给大家的全部内容了,希望能给大家一个参考,也希望大家多多支持呐喊教程。

-

本文向大家介绍Puppeteer 爬取动态生成的网页实战,包括了Puppeteer 爬取动态生成的网页实战的使用技巧和注意事项,需要的朋友参考一下 Puppeteer 相关介绍与安装不过多介绍,可通过以下链接进行学习 一、Puppeteer 开源地址 英文文档 中文社区 二、爬取动态网页 1. 需求 首先,了解下我们的需求: 爬取zoomcharts 文档中 Net Chart 目录下所有访问连接

-

本文向大家介绍Python使用爬虫爬取静态网页图片的方法详解,包括了Python使用爬虫爬取静态网页图片的方法详解的使用技巧和注意事项,需要的朋友参考一下 本文实例讲述了Python使用爬虫爬取静态网页图片的方法。分享给大家供大家参考,具体如下: 爬虫理论基础 其实爬虫没有大家想象的那么复杂,有时候也就是几行代码的事儿,千万不要把自己吓倒了。这篇就清晰地讲解一下利用Python爬虫的理论基础。 首

-

主要内容:静态网页,动态网页本节我们了解一下静态网页和动态网页的相关概念。如果您熟悉前端语言的话,那么您可以快速地了解本节知识。 当我们在编写一个爬虫程序前,首先要明确待爬取的页面是静态的,还是动态的,只有确定了页面类型,才方便后续对网页进行分析和程序编写。对于不同的网页类型,编写爬虫程序时所使用的方法也不尽相同。 静态网页 静态网页是标准的 HTML 文件,通过 GET 请求方法可以直接获取,文件的扩展名是 、 等,网面中

-

本文向大家介绍python爬虫爬取网页数据并解析数据,包括了python爬虫爬取网页数据并解析数据的使用技巧和注意事项,需要的朋友参考一下 1.网络爬虫的基本概念 网络爬虫(又称网络蜘蛛,机器人),就是模拟客户端发送网络请求,接收请求响应,一种按照一定的规则,自动地抓取互联网信息的程序。 只要浏览器能够做的事情,原则上,爬虫都能够做到。 2.网络爬虫的功能 网络爬虫可以代替手工做很多事情,比如可以

-

本文向大家介绍python批量爬取下载抖音视频,包括了python批量爬取下载抖音视频的使用技巧和注意事项,需要的朋友参考一下 本文实例为大家分享了python批量爬取下载抖音视频的具体代码,供大家参考,具体内容如下 以上就是本文的全部内容,希望对大家的学习有所帮助,也希望大家多多支持呐喊教程。