Spring Boot 搭建 ELK正确看日志的配置流程

为什么要用ELK

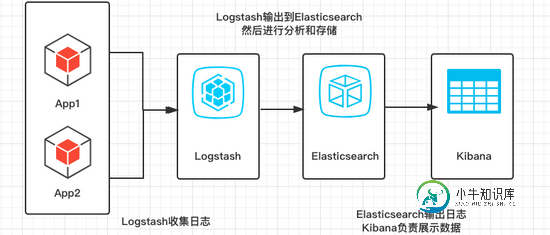

ELK实际上是三个工具,Elastricsearch + Logstash + Kibana,通过ELK,用来收集日志还有进行日志分析,最后通过可视化UI进行展示。一开始业务量比较小的时候,通过简单的SLF4J+Logger在服务器打印日志,通过grep进行简单查询,但是随着业务量增加,数据量也会不断增加,所以使用ELK可以进行大数量的日志收集和分析

简单画了一下架构图

在环境配置中,主要介绍Mac和Linux配置,Windows系统大致相同,当然,前提是大家都安装了JDK 1.8及以上版本~

[root@VM_234_23_centos ~]# java -version java version "1.8.0_161" Java(TM) SE Runtime Environment (build 1.8.0_161-b12) Java HotSpot(TM) 64-Bit Server VM (build 25.161-b12, mixed mode)

注意:高版本的ELK同样需要高版本的JDK支持,本文配置的ELK版本是6.0+,所以需要的JDK版本不小于1.8

Elasticsearch

Elasticsearch是一个分布式的RESTful风格的搜索和数据分析引擎,能够解决不断涌现出的各种用例。作为Elastic Stack的核心,它集中存储您的数据,帮助您发现意料之中以及意料之外的情况。

Mac安装和运行:

- 安装:brew install elasticsearch

- 运行:elasticsearch

Linux:从Elasticsearch官方地址下载(也可以下载完,通过ftp之类的工具传上去),gz文件的话通过tar进行解压缩,然后进入bin目录下运行软件。

[root@VM_234_23_centos app]# curl -L -O https://artifacts.elastic.co/downloads/elasticsearch/elasticsearch-6.2.4.tar.gz [root@VM_234_23_centos app]# tar -zxvf elasticsearch-6.2.4.tar.gz [root@VM_234_23_centos app]# cd elasticsearch-6.2.4 [root@VM_234_23_centos elasticsearch-6.2.4]# ./bin/elasticsearch

注意:在Linux机器上,运行Elasticsearch需要一个新的用户组,文章最后有Elastic在Linux安装的踩坑记录。

Logstash

Logstash是开源的服务器端数据处理管道,能够同时从多个来源采集数据,转换数据,然后将数据发送到您最喜欢的“存储库”中。(我们的存储库当然是Elasticsearch。)——官方卖萌

软件安装

Mac安装:

brew install logstash

Linux安装:

[root@VM_234_23_centos app]# curl -L -O https://artifacts.elastic.co/downloads/logstash/logstash-6.3.2.tar.gz

% Total % Received % Xferd Average Speed Time Time Time Current

Dload Upload Total Spent Left Speed

100 137M 100 137M 0 0 5849k 0 0:00:24 0:00:24 --:--:-- 6597k

[root@VM_234_23_centos app]# tar -zxvf logstash-6.3.2.tar.gz

修改配置文件

vim /etc/logstash.conf

conf文件,指定要使用的插件,和配置对应的elasticsearch的hosts。

input { stdin { } }

output {

elasticsearch { hosts => ["localhost:9200"] }

stdout { codec => rubydebug }

}

运行

bin/logstash -f logstash.conf

访问 http://localhost:9600/

{

"host": "=-=",

"version": "6.2.4",

"http_address": "127.0.0.1:9600",

"id": "5b47e81f-bdf8-48fc-9537-400107a13bd2",

"name": "=-=",

"build_date": "2018-04-12T22:29:17Z",

"build_sha": "a425a422e03087ac34ad6949f7c95ec6d27faf14",

"build_snapshot": false

}

在Elasticsearch日志中,也能看到Logstash正常加入的日志。

[2018-08-16T14:08:36,436][INFO ][o.e.c.m.MetaDataIndexTemplateService] [f2s1SD8] adding template [logstash] for index patterns [logstash-*]

看到这种返回值,表示已经成功安装和启动。

踩坑

在运行的那一步,有可能遇到内存分配错误:

Java HotSpot(TM) 64-Bit Server VM warning: INFO: os::commit_memory(0x00000000c5330000, 986513408, 0) failed; error='Cannot allocate memory' (errno=12)

这个错误很明显就是内存不足,由于个人购买的是腾讯云1G内存的服务器(如果是壕,请随意购买更高的配置=-=),已经运行了Elasticsearch,导致Logstash分配不到足够的内存,所以最后要修改一下JVM配置。

[root@VM_234_23_centos logstash-6.3.2]# cd config/ [root@VM_234_23_centos config]# ll total 28 -rw-r--r-- 1 root root 1846 Jul 20 14:19 jvm.options -rw-r--r-- 1 root root 4466 Jul 20 14:19 log4j2.properties -rw-r--r-- 1 root root 8097 Jul 20 14:19 logstash.yml -rw-r--r-- 1 root root 3244 Jul 20 14:19 pipelines.yml -rw-r--r-- 1 root root 1696 Jul 20 14:19 startup.options [root@VM_234_23_centos config]# vim jvm.options

将-Xms1g -Xmx1g修改为:

-Xms256m

-Xmx256m

然后就能正常启动了~~

Kibana

软件安装

Kibana让您能够可视化Elasticsearch中的数据并操作Elastic Stack,因此您可以在这里解开任何疑问:例如,为何会在凌晨2:00被传呼,雨水会对季度数据造成怎样的影响。(而且展示的图标十分酷炫)

Mac安装:

brew install kibana

Linux安装,官方下载地址: https://www.elastic.co/downloads/kibana

[root@VM_234_23_centos app]# curl -L -O https://artifacts.elastic.co/downloads/kibana/kibana-6.3.2-linux-x86_64.tar.gz

% Total % Received % Xferd Average Speed Time Time Time Current

Dload Upload Total Spent Left Speed

0 195M 0 271k 0 0 19235 0 2:57:54 0:00:14 2:57:40 26393

在这一步,有可能下载速度奇慢,所以我本地下载好之后,通过rz命令传输到服务器。

[root@VM_234_23_centos app]# rz rz waiting to receive. Starting zmodem transfer. Press Ctrl+C to cancel. Transferring kibana-6.3.2-linux-x86_64.tar.gz... 100% 200519 KB 751 KB/sec 00:04:27 0 Errors [root@VM_234_23_centos app]# tar -zxvf kibana-6.3.2-linux-x86_64.tar.gz

修改配置

修改config/kibana.yml配置文件,设置elasticsearch.url指向Elasticsearch实例。

如果跟我一样使用默认的配置,可以不需要修改该文件。

启动

[root@VM_234_23_centos kibana]# ./bin/kibana

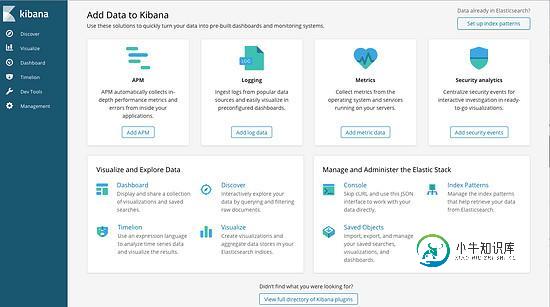

访问 http://localhost:5601/app/kibana#/home?_g= ()

界面显示了这么多功能,下面通过整合SLF4J+LogBack。

整合Spring+Logstash

修改logstash.conf后,重新启动Logstash

input {

# stdin { }

tcp {

# host:port就是上面appender中的destination,

# 这里其实把Logstash作为服务,开启9250端口接收logback发出的消息

host => "127.0.0.1" port => 9250 mode => "server" tags => ["tags"] codec => json_lines

}

}

output {

elasticsearch { hosts => ["localhost:9200"] }

stdout { codec => rubydebug }

}

在Java应用中引用依赖

<dependency> <groupId>net.logstash.logback</groupId> <artifactId>logstash-logback-encoder</artifactId> <version>5.2</version> </dependency>

在logback.xml中配置日志输出

<!--日志导出的到 Logstash-->

<appender name="stash"

class="net.logstash.logback.appender.LogstashTcpSocketAppender">

<destination>localhost:9250</destination>

<!-- encoder必须配置,有多种可选 -->

<encoder charset="UTF-8"

class="net.logstash.logback.encoder.LogstashEncoder" >

<!-- "appname":"ye_test" 的作用是指定创建索引的名字时用,并且在生成的文档中会多了这个字段 -->

<customFields>{"appname":"ye_test"}</customFields>

</encoder>

</appender>

<root level="INFO">

<appender-ref ref="stash"/>

</root>

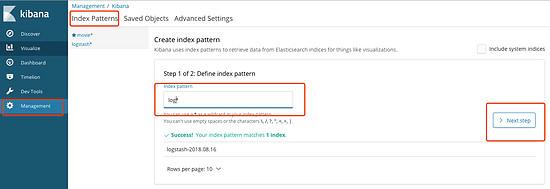

由于我在第一步骤中,没有指定对应的index,所以在服务启动的时候,日志采集器Logstash帮我自动创建了logstash-timestamp的index。

在Kibana中添加index索引

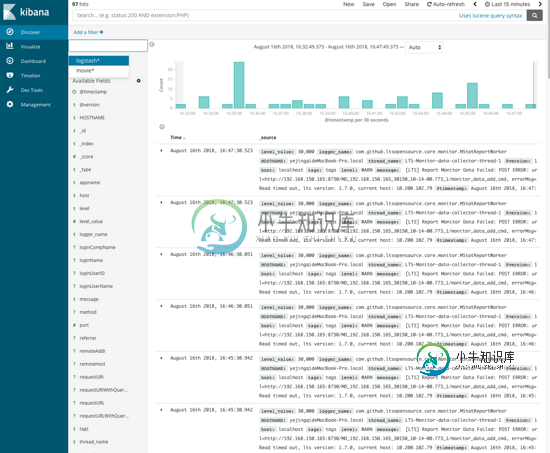

在左边discover中查看索引信息

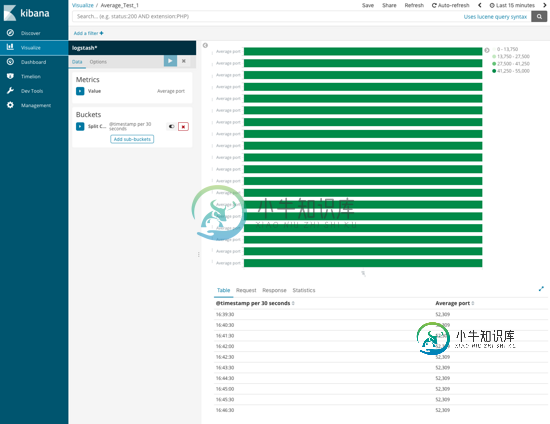

添加可视化图表Visualize

还有更多功能还在探索中,首先环境搭起来才会用动力继续去学习~

踩坑记录 启动报错

uncaught exception in thread [main] org.elasticsearch.bootstrap.StartupException: java.lang.RuntimeException: can not run elasticsearch as root

原因: 不能使用Root权限登录

解决方案: 切换用户

[root@VM_234_23_centos ~]# groupadd es [root@VM_234_23_centos ~]# useradd es -g es -p es [root@VM_234_23_centos ~]# chown es:es /home/app/elasticsearch/ # 切换用户,记得su - ,这样才能获得环境变量 [root@VM_234_23_centos ~]# sudo su - es Exception in thread “main” java.nio.file.AccessDeniedException:

错误原因:使用非 root用户启动ES,而该用户的文件权限不足而被拒绝执行。

解决方法: chown -R用户名:用户名 文件(目录)名

例如: chown -R abc:abc searchengine,再启动ES就正常了

Elasticsearch启动后报Killed

[2018-07-13T10:19:44,775][INFO ][o.e.p.PluginsService ] [f2s1SD8] loaded module [aggs-matrix-stats]

[2018-07-13T10:19:44,779][INFO ][o.e.p.PluginsService ] [f2s1SD8] loaded module [analysis-common]

[2018-07-13T10:19:44,780][INFO ][o.e.p.PluginsService ] [f2s1SD8] loaded module [ingest-common]

[2018-07-13T10:19:44,780][INFO ][o.e.p.PluginsService ] [f2s1SD8] loaded module [lang-expression]

[2018-07-13T10:19:44,780][INFO ][o.e.p.PluginsService ] [f2s1SD8] loaded module [lang-mustache]

[2018-07-13T10:19:44,780][INFO ][o.e.p.PluginsService ] [f2s1SD8] loaded module [lang-painless]

[2018-07-13T10:19:44,780][INFO ][o.e.p.PluginsService ] [f2s1SD8] loaded module [mapper-extras]

[2018-07-13T10:19:44,780][INFO ][o.e.p.PluginsService ] [f2s1SD8] loaded module [parent-join]

[2018-07-13T10:19:44,780][INFO ][o.e.p.PluginsService ] [f2s1SD8] loaded module [percolator]

[2018-07-13T10:19:44,780][INFO ][o.e.p.PluginsService ] [f2s1SD8] loaded module [rank-eval]

[2018-07-13T10:19:44,781][INFO ][o.e.p.PluginsService ] [f2s1SD8] loaded module [reindex]

[2018-07-13T10:19:44,781][INFO ][o.e.p.PluginsService ] [f2s1SD8] loaded module [repository-url]

[2018-07-13T10:19:44,781][INFO ][o.e.p.PluginsService ] [f2s1SD8] loaded module [transport-netty4]

[2018-07-13T10:19:44,781][INFO ][o.e.p.PluginsService ] [f2s1SD8] loaded module [tribe]

[2018-07-13T10:19:44,781][INFO ][o.e.p.PluginsService ] [f2s1SD8] loaded module [x-pack-core]

[2018-07-13T10:19:44,781][INFO ][o.e.p.PluginsService ] [f2s1SD8] loaded module [x-pack-deprecation]

[2018-07-13T10:19:44,781][INFO ][o.e.p.PluginsService ] [f2s1SD8] loaded module [x-pack-graph]

[2018-07-13T10:19:44,781][INFO ][o.e.p.PluginsService ] [f2s1SD8] loaded module [x-pack-logstash]

[2018-07-13T10:19:44,782][INFO ][o.e.p.PluginsService ] [f2s1SD8] loaded module [x-pack-ml]

[2018-07-13T10:19:44,782][INFO ][o.e.p.PluginsService ] [f2s1SD8] loaded module [x-pack-monitoring]

[2018-07-13T10:19:44,782][INFO ][o.e.p.PluginsService ] [f2s1SD8] loaded module [x-pack-rollup]

[2018-07-13T10:19:44,782][INFO ][o.e.p.PluginsService ] [f2s1SD8] loaded module [x-pack-security]

[2018-07-13T10:19:44,782][INFO ][o.e.p.PluginsService ] [f2s1SD8] loaded module [x-pack-sql]

[2018-07-13T10:19:44,782][INFO ][o.e.p.PluginsService ] [f2s1SD8] loaded module [x-pack-upgrade]

[2018-07-13T10:19:44,782][INFO ][o.e.p.PluginsService ] [f2s1SD8] loaded module [x-pack-watcher]

[2018-07-13T10:19:44,783][INFO ][o.e.p.PluginsService ] [f2s1SD8] no plugins loaded

Killed

修改config目录下的jvm.options,将堆的大小设置小一点。

# Xms represents the initial size of total heap space # Xmx represents the maximum size of total heap space -Xms512m -Xmx512m

虚拟内存不足

max virtual memory areas vm.max_map_count [65530] is too low, increase to at least [262144]

需要修改虚拟内存的大小(在root权限下)

[2018-07-13T14:02:06,749][DEBUG][o.e.a.ActionModule ] Using REST wrapper from plugin org.elasticsearch.xpack.security.Security

[2018-07-13T14:02:07,249][INFO ][o.e.d.DiscoveryModule ] [f2s1SD8] using discovery type [zen]

[2018-07-13T14:02:09,173][INFO ][o.e.n.Node ] [f2s1SD8] initialized

[2018-07-13T14:02:09,174][INFO ][o.e.n.Node ] [f2s1SD8] starting ...

[2018-07-13T14:02:09,539][INFO ][o.e.t.TransportService ] [f2s1SD8] publish_address {10.105.234.23:9300}, bound_addresses {0.0.0.0:9300}

[2018-07-13T14:02:09,575][INFO ][o.e.b.BootstrapChecks ] [f2s1SD8] bound or publishing to a non-loopback address, enforcing bootstrap checks

ERROR: [1] bootstrap checks failed

[1]: max virtual memory areas vm.max_map_count [65530] is too low, increase to at least [262144]

[2018-07-13T14:02:09,621][INFO ][o.e.n.Node ] [f2s1SD8] stopping ...

[2018-07-13T14:02:09,726][INFO ][o.e.n.Node ] [f2s1SD8] stopped

[2018-07-13T14:02:09,726][INFO ][o.e.n.Node ] [f2s1SD8] closing ...

[2018-07-13T14:02:09,744][INFO ][o.e.n.Node ] [f2s1SD8] closed

到此这篇关于Spring Boot 搭建 ELK正确看日志的配置流程的文章就介绍到这了,更多相关Spring Boot 搭建 ELK内容请搜索小牛知识库以前的文章或继续浏览下面的相关文章希望大家以后多多支持小牛知识库!

-

ELK 是 ElasticSearch + Logstash + Kibana 这套组合工具的简称,是一个常用的日志系统。 ElasticSearch:是一款开源的基于 Lucene 之上实现的一个分布式搜索引擎,也是一个存储引擎(例如:日志),它的特点有:分布式、零配置、自动发现、索引自动分片、索引副本机制、Restful 风格的接口、多数据源和自动搜索负载等。 Logstash:是一款开源的日

-

版本说明 本文包含了:Elasticsearch 2.4.X 和 Elasticsearch 5.2.X 和 Elasticsearch 5.5.X,请有针对性地选择。 教程说明 官网:https://www.elastic.co/ 官网总文档:https://www.elastic.co/guide/index.html 官网最终指南:https://www.elastic.co/guide/e

-

我正在使用logstash进行集中式日志记录。我在托运人节点上使用logstash转发器,在收集器节点上使用ELK堆栈。我想知道日志存储在elasticsearch中的位置,我没有看到日志所在位置创建的任何数据文件stored.Do有人知道吗?

-

本文向大家介绍详解利用ELK搭建Docker容器化应用日志中心,包括了详解利用ELK搭建Docker容器化应用日志中心的使用技巧和注意事项,需要的朋友参考一下 概述 应用一旦容器化以后,需要考虑的就是如何采集位于Docker容器中的应用程序的打印日志供运维分析。典型的比如SpringBoot应用的日志 收集。本文即将阐述如何利用ELK日志中心来收集容器化应用程序所产生的日志,并且可以用可视化的方式

-

本文向大家介绍springboot+log4j.yml配置日志文件的方法,包括了springboot+log4j.yml配置日志文件的方法的使用技巧和注意事项,需要的朋友参考一下 一,Maven 依赖 pom.xml配置 1, 去掉默认日志,以便切换到log4j2的日志依赖 2, 然后添加如下两个日志依赖 二,在工程根目录下添加 lo4g2.yml 配置文件 2, 配置文件内容 三,在工程根目录下

-

问题: 如何设置日志塔什ELK堆栈的多个http输入 我已经拥有的: <李>工作麋鹿码头工人形象基于:https://github.com/deviantony/docker-elk < li >工作日志存储-输入-http-插件基于:https://www . elastic . co/blog/introducing-log stash-input-http-plugin < li >我的lo

-

看过本章第一节的同学应该还记得,log_by_lua* 是一个请求经历的最后阶段。由于记日志跟应答内容无关,Nginx 通常在结束请求之后才更新访问日志。由此可见,如果我们有日志输出的情况,最好统一到 log_by_lua* 阶段。如果我们把记日志的操作放在 content_by_lua* 阶段,那么将线性的增加请求处理时间。 在公司某个定制化项目中,Nginx 上的日志内容都要输送到 syslo

-

上节课和大家介绍了 Kubernetes 集群中的几种日志收集方案,Kubernetes 中比较流行的日志收集解决方案是 Elasticsearch、Fluentd 和 Kibana(EFK)技术栈,也是官方现在比较推荐的一种方案。 Elasticsearch 是一个实时的、分布式的可扩展的搜索引擎,允许进行全文、结构化搜索,它通常用于索引和搜索大量日志数据,也可用于搜索许多不同类型的文档。 El