在python环境下运用kafka对数据进行实时传输的方法

背景:

为了满足各个平台间数据的传输,以及能确保历史性和实时性。先选用kafka作为不同平台数据传输的中转站,来满足我们对跨平台数据发送与接收的需要。

kafka简介:

Kafka is a distributed,partitioned,replicated commit logservice。它提供了类似于JMS的特性,但是在设计实现上完全不同,此外它并不是JMS规范的实现。kafka对消息保存时根据Topic进行归类,发送消息者成为Producer,消息接受者成为Consumer,此外kafka集群有多个kafka实例组成,每个实例(server)成为broker。无论是kafka集群,还是producer和consumer都依赖于zookeeper来保证系统可用性集群保存一些meta信息。

总之:kafka做为中转站有以下功能:

1.生产者(产生数据或者说是从外部接收数据)

2.消费着(将接收到的数据转花为自己所需用的格式)

环境:

1.python3.5.x

2.kafka1.4.3

3.pandas

准备开始:

1.kafka的安装

pip install kafka-python

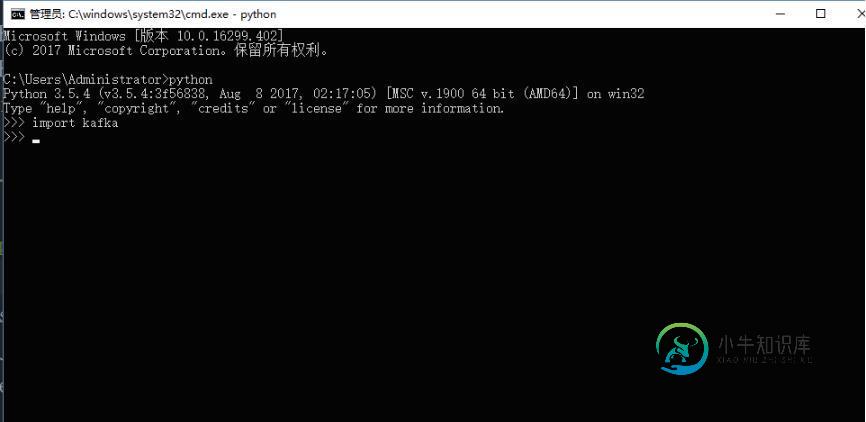

2.检验kafka是否安装成功

3.pandas的安装

pip install pandas

4.kafka数据的传输

直接撸代码:

# -*- coding: utf-8 -*-

'''

@author: 真梦行路

@file: kafka.py

@time: 2018/9/3 10:20

'''

import sys

import json

import pandas as pd

import os

from kafka import KafkaProducer

from kafka import KafkaConsumer

from kafka.errors import KafkaError

KAFAKA_HOST = "xxx.xxx.x.xxx" #服务器端口地址

KAFAKA_PORT = 9092 #端口号

KAFAKA_TOPIC = "topic0" #topic

data=pd.read_csv(os.getcwd()+'\\data\\1.csv')

key_value=data.to_json()

class Kafka_producer():

'''

生产模块:根据不同的key,区分消息

'''

def __init__(self, kafkahost, kafkaport, kafkatopic, key):

self.kafkaHost = kafkahost

self.kafkaPort = kafkaport

self.kafkatopic = kafkatopic

self.key = key

self.producer = KafkaProducer(bootstrap_servers='{kafka_host}:{kafka_port}'.format(

kafka_host=self.kafkaHost,

kafka_port=self.kafkaPort)

)

def sendjsondata(self, params):

try:

parmas_message = params #注意dumps

producer = self.producer

producer.send(self.kafkatopic, key=self.key, value=parmas_message.encode('utf-8'))

producer.flush()

except KafkaError as e:

print(e)

class Kafka_consumer():

def __init__(self, kafkahost, kafkaport, kafkatopic, groupid,key):

self.kafkaHost = kafkahost

self.kafkaPort = kafkaport

self.kafkatopic = kafkatopic

self.groupid = groupid

self.key = key

self.consumer = KafkaConsumer(self.kafkatopic, group_id=self.groupid,

bootstrap_servers='{kafka_host}:{kafka_port}'.format(

kafka_host=self.kafkaHost,

kafka_port=self.kafkaPort)

)

def consume_data(self):

try:

for message in self.consumer:

yield message

except KeyboardInterrupt as e:

print(e)

def sortedDictValues(adict):

items = adict.items()

items=sorted(items,reverse=False)

return [value for key, value in items]

def main(xtype, group, key):

'''

测试consumer和producer

'''

if xtype == "p":

# 生产模块

producer = Kafka_producer(KAFAKA_HOST, KAFAKA_PORT, KAFAKA_TOPIC, key)

print("===========> producer:", producer)

params =key_value

producer.sendjsondata(params)

if xtype == 'c':

# 消费模块

consumer = Kafka_consumer(KAFAKA_HOST, KAFAKA_PORT, KAFAKA_TOPIC, group,key)

print("===========> consumer:", consumer)

message = consumer.consume_data()

for msg in message:

msg=msg.value.decode('utf-8')

python_data=json.loads(msg) ##这是一个字典

key_list=list(python_data)

test_data=pd.DataFrame()

for index in key_list:

print(index)

if index=='Month':

a1=python_data[index]

data1 = sortedDictValues(a1)

test_data[index]=data1

else:

a2 = python_data[index]

data2 = sortedDictValues(a2)

test_data[index] = data2

print(test_data)

# print('value---------------->', python_data)

# print('msg---------------->', msg)

# print('key---------------->', msg.kry)

# print('offset---------------->', msg.offset)

if __name__ == '__main__':

main(xtype='p',group='py_test',key=None)

main(xtype='c',group='py_test',key=None)

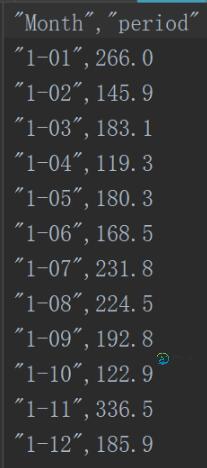

数据1.csv如下所示:

几点注意:

1、一定要有一个服务器的端口地址,不要用本机的ip或者乱写一个ip不然程序会报错。(我开始就是拿本机ip怼了半天,总是报错)

2、注意数据的传输格式以及编码问题(二进制传输),数据先转成json数据格式传输,然后将json格式转为需要格式。(不是json格式的注意dumps)

例中,dataframe->json->dataframe

3、例中dict转dataframe,也可以用简单方法直接转。

eg: type(data) ==>dict,data=pd.Dateframe(data)

以上这篇在python环境下运用kafka对数据进行实时传输的方法就是小编分享给大家的全部内容了,希望能给大家一个参考,也希望大家多多支持小牛知识库。

-

我正在使用python从USB输入设备读取数据。我想知道是否有一种方法可以与MATLAB中的模型实时交换。我现在的做法是将读取的数据保存在一个.mat文件中,然后让模型从那里读取数据,这不是很直观。我使用的代码如下所示:

-

AST或字节码的解释过程只是在代码过程层面,不足以成为一个完整的运行,因为程序计算是需要数据和存储空间的,光有代码跑不起来,需要运行时环境,至少要有数据,实际情况中还需要一些其他信息。为讨论方便,在解释器中将运行时环境抽象为前述的env对象,通过一些接口来实现存取,这里先只讨论单执行序列,不考虑并发 env在前面的分析中总共就涉及了三个接口,get,set和set_exception(当然还应该有

-

本文向大家介绍python实现udp数据报传输的方法,包括了python实现udp数据报传输的方法的使用技巧和注意事项,需要的朋友参考一下 本文实例讲述了Python实现UDP数据报传输的方法,非常具有实用价值。分享给大家供大家参考。具体方法分析如下: 服务端代码: 客户端代码: 结果:先运行服务端,然后运行客户端, 服务端打印出: 补充: socket.sendto(string[, flags

-

本文向大家介绍Python对数据进行插值和下采样的方法,包括了Python对数据进行插值和下采样的方法的使用技巧和注意事项,需要的朋友参考一下 使用Python进行插值非常方便,可以直接使用scipy中的interpolate 其中y_bspline就是从1024插值得到的4096的数据 但是,scipy中好像并没有进行下采样的函数,嗯..难道是因为太过简单了么,不过好像用一个循环就可以完成,但如

-

运行时环境 Spring Security 3.0 需要Java 5.0或者更高版本的运行环境。由于Spring Security是自包含的方式进行操作,所以不需要放置特别的配置文件到你的Java运行环境。特别的,不需要配专门的Java认证和授权服务(JAAS)策略文件或者放到Spring Security普通的类路径下。 同样如果你使用EJB容器或者Servlet容器,没有必要放置配置文件到任何

-

主要内容:相关知识,2.系统环境,3.任务内容,4.任务步骤1.相关知识 Flume是一个海量日志采集、聚合和传输的日志收集系统。 Kafka是一个可持久化的分布式的消息队列。 由于采集和处理数据的速度不一定同步,所以使用Kafka这个消息中间件来缓冲,如果你收集了日志后,想输出到多个业务方也可结合Kafka,Kafka支持多个业务来读取数据。 上图中Kafka生产的数据,是由Flume提供的,这里我们需要用到Flume集群,通过Flume集群将Agent