网站渗透常用Python小脚本查询同ip网站

旁站查询来源:

http://dns.aizhan.com

http://s.tool.chinaz.com/same

http://i.links.cn/sameip/

http://www.ip2hosts.com/

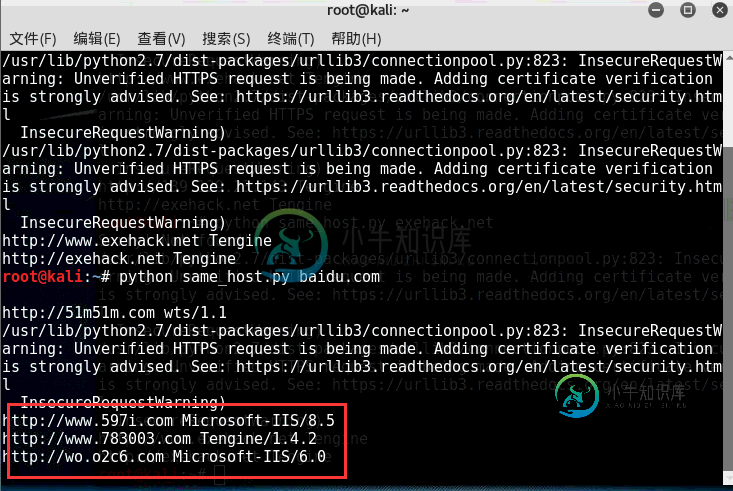

效果图如下:

以百度网站和小残博客为例:

PS:直接调用以上4个旁注接口查询同服服务器域名信息包含服务器类型 比如小残博客使用的是Tengine

#!/usr/bin/env python

#encoding: utf-8

import re

import sys

import json

import time

import requests

import urllib

import requests.packages.urllib3

from multiprocessing import Pool

from BeautifulSoup import BeautifulSoup

requests.packages.urllib3.disable_warnings()

headers = {'User-Agent' : 'Mozilla/5.0 (Macintosh; Intel Mac OS X 10_7_3) AppleWebKit/535.20 (KHTML, like Gecko) Chrome/19.0.1036.7 Safari/535.20'}

def links_ip(host):

'''

查询同IP网站

'''

ip2hosts = []

ip2hosts.append("http://"+host)

try:

source = requests.get('http://i.links.cn/sameip/' + host + '.html', headers=headers,verify=False)

soup = BeautifulSoup(source.text)

divs = soup.findAll(style="word-break:break-all")

if divs == []: #抓取结果为空

print 'Sorry! Not found!'

return ip2hosts

for div in divs:

#print div.a.string

ip2hosts.append(div.a.string)

except Exception, e:

print str(e)

return ip2hosts

return ip2hosts

def ip2host_get(host):

ip2hosts = []

ip2hosts.append("http://"+host)

try:

req=requests.get('http://www.ip2hosts.com/search.php?ip='+str(host), headers=headers,verify=False)

src=req.content

if src.find('result') != -1:

result = json.loads(src)['result']

ip = json.loads(src)['ip']

if len(result)>0:

for item in result:

if len(item)>0:

#log(scan_type,host,port,str(item))

ip2hosts.append(item)

except Exception, e:

print str(e)

return ip2hosts

return ip2hosts

def filter(host):

'''

打不开的网站...

'''

try:

response = requests.get(host, headers=headers ,verify=False)

server = response.headers['Server']

title = re.findall(r'<title>(.*?)</title>',response.content)[0]

except Exception,e:

#print "%s" % str(e)

#print host

pass

else:

print host,server

def aizhan(host):

ip2hosts = []

ip2hosts.append("http://"+host)

regexp = r'''<a href="[^']+?([^']+?)/" rel="external nofollow" target="_blank">\1</a>'''

regexp_next = r'''<a href="http://dns.aizhan.com/[^/]+?/%d/" rel="external nofollow" >%d</a>'''

url = 'http://dns.aizhan.com/%s/%d/'

page = 1

while True:

if page > 2:

time.sleep(1) #防止拒绝访问

req = requests.get(url % (host , page) ,headers=headers ,verify=False)

try:

html = req.content.decode('utf-8') #取得页面

if req.status_code == 400:

break

except Exception as e:

print str(e)

pass

for site in re.findall(regexp , html):

ip2hosts.append("http://"+site)

if re.search(regexp_next % (page+1 , page+1) , html) is None:

return ip2hosts

break

page += 1

return ip2hosts

def chinaz(host):

ip2hosts = []

ip2hosts.append("http://"+host)

regexp = r'''<a href='[^']+?([^']+?)' target=_blank>\1</a>'''

regexp_next = r'''<a href="javascript:" rel="external nofollow" val="%d" class="item[^"]*?">%d</a>'''

url = 'http://s.tool.chinaz.com/same?s=%s&page=%d'

page = 1

while True:

if page > 1:

time.sleep(1) #防止拒绝访问

req = requests.get(url % (host , page) , headers=headers ,verify=False)

html = req.content.decode('utf-8') #取得页面

for site in re.findall(regexp , html):

ip2hosts.append("http://"+site)

if re.search(regexp_next % (page+1 , page+1) , html) is None:

return ip2hosts

break

page += 1

return ip2hosts

def same_ip(host):

mydomains = []

mydomains.extend(ip2host_get(host))

mydomains.extend(links_ip(host))

mydomains.extend(aizhan(host))

mydomains.extend(chinaz(host))

mydomains = list(set(mydomains))

p = Pool()

for host in mydomains:

p.apply_async(filter, args=(host,))

p.close()

p.join()

if __name__=="__main__":

if len(sys.argv) == 2:

same_ip(sys.argv[1])

else:

print ("usage: %s host" % sys.argv[0])

sys.exit(-1)

大家可以发挥添加或者修改任意查询接口。注意是这个里面的一些思路与代码。

-

网络渗透测试是将在本节中介绍的第一个渗透测试。大多数系统和计算机都连接到网络。如果设备连接到互联网,这意味着设备已连接到网络,因为互联网是一个非常大的网络。因此,我们需要知道设备如何在网络中相互交互,以及网络如何工作。 网络渗透测试分为3个小部分: 预连接攻击:在本节中,我们将了解在连接到网络之前可以执行的所有攻击。 获得攻击:在本节中,我们将了解如何破解Wi-Fi密钥并获取Wi-Fi网络,无论使

-

本文向大家介绍Shell脚本获取本地网卡IP、mac地址、子网掩码、dns IP、外网IP,包括了Shell脚本获取本地网卡IP、mac地址、子网掩码、dns IP、外网IP的使用技巧和注意事项,需要的朋友参考一下

-

问题内容: 通过使用python,如何检查网站是否正常?从我阅读的内容中,我需要检查“ HTTP HEAD”并看到状态码“ 200 OK”,但是该怎么做呢? 干杯 有关 如何使用Python发送HEAD HTTP请求? 问题答案: 您可以尝试使用要做到这一点从 urllib的 编辑:对于更现代的python,即使用:

-

本文向大家介绍寻找网站后台地址的python脚本,包括了寻找网站后台地址的python脚本的使用技巧和注意事项,需要的朋友参考一下

-

问题内容: 从昨天开始,我一直在寻找一个更简单的解决方案,以便仅对网站进行ping并检查它在Swift中是否返回200。 但是我发现的只是目标C中的解决方案。 在Swift中,我找到了一些答案,例如 但是当我从其他函数调用它时 它给出了奇怪的错误,例如 我如何简单地在Swift 4中ping并检查它是否返回200? 问题答案: 我想这个问题很容易:您启用了 应用沙箱 , 但未选中 传出连接 。 那

-

通过监听session对象的方式来实现在线人数的统计和在线人信息展示,并且让超时的自动销毁。 对session对象实现监听,首先必须继承HttpSessionListener类,该程序的基本原理就是当浏览器访问页面的时候必定会产生一个session对象,当关闭该页面的时候必然会删除session对象。所以每当产生一个新的session对象就让在线人数+1,当删除一个session对象就让在线人数-